随着人工智能技术的飞速发展,口型同步(Lipsync)技术成为视频内容创作和智能交互中的关键环节。传统的口型同步方法通常依赖于大量标注数据和复杂训练流程,限制了其在多样化场景中的灵活应用。为解决这一瓶颈,我们成功研发出业内领先的零样本口型同步模型,实现了从任意音频输入到视频口型精准匹配的突破,为多领域带来了极具变革性的技术支持。口型同步的核心挑战在于声音信息与面部动作之间的精确转换,尤其在多语言、多语境甚至不同人物的背景下,保持一致性和自然流畅性的难度极大。零样本学习理念的引入则使模型在无需专门针对特定数据的训练下,具备强大的泛化能力,能够直接对未曾见过的音频和视频内容进行匹配,大大提高了系统的实用性和适应力。该模型基于最新的深度神经网络架构,结合自监督学习和跨模态融合技术,实现音频信号特征和面部表情动态的高度协同。

通过一系列创新算法,模型精准捕捉音频节奏、韵律及情感色彩,映射到唇部动作细节,使生成的视频口型高度真实且极具感染力。我们的系统支持多格式视频输入,包括mp4、mov、webm等主流文件格式,兼容多样的音频编码如mp3、wav、aac,极大地方便用户上传和处理数据。用户能够轻松利用VEED平台的交互界面,拖放文件或输入链接,即刻体验生成的唇-sync效果,且生成过程高效、稳定,满足商业及创意制作的多重需求。在应用场景方面,该模型广泛服务于影视制作、游戏动画、虚拟主播、在线教育及社交媒体内容创造。影视制作者能借助其快速生成多语言配音版本,无需耗费大量人工同步成本。游戏角色配音更加自然逼真,提升玩家沉浸感。

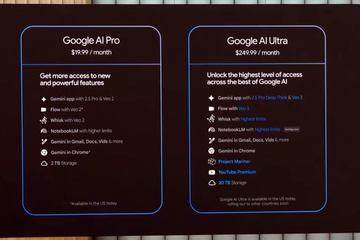

在线课程中,零样本口型同步为多语言教学提供了技术保障,使内容本地化更快捷精准。社交平台上的短视频创作者亦能利用该技术实现音画同步,增强作品吸引力和传播效果。商业模式方面,我们采用按需计费方式,用户仅为实际生成内容时长付费,每分钟仅需0.4美元,成本透明且具竞争力。配套API接口和开放平台功能支持合作伙伴深度集成并定制个性化解决方案,推动行业生态的共赢发展。安全合规也是项目重点,严格遵守隐私保护和数据安全规范,确保用户素材与生成内容的安全可靠。我们持续优化模型性能,增强适应不同语言、方言及情感表达的能力,同时精细化唇动细节,提升整体真实感。

未来,随着硬件算力和算法的进一步革新,这一零样本口型同步技术将更加普及,助力娱乐产业和数字内容创造进入全新智能化时代。综上,领先的零样本口型同步模型不仅极大提升了音视频配合的效率和品质,更为创作者和企业提供了强有力的技术保障,推动数字媒体创作迈向便捷、多样和高质量的新阶段。这个创新成果标志着人工智能在视觉与声音融合领域的显著突破,是数字内容产业升级的重要里程碑。