随着人工智能的迅猛发展,语言模型在自然语言处理领域扮演着越来越关键的角色。特别是以GPT为代表的大型变换器模型,在文本生成、翻译、问答等任务中展现出了惊人的能力。然而,围绕着这些模型的一个重要且复杂的问题依然备受关注——语言模型到底记忆了多少训练数据?它们是如何区分记忆和泛化的?这些问题关乎模型的隐私安全、性能稳定性和未来发展方向。首先,我们必须明确语言模型的“记忆”并非简单的重复记忆,而是指模型内部所保存的信息。这包括对训练集中特定数据点的记忆,也包括对整个数据生成过程规律的捕捉。近年来,研究者提出了一种全新的视角,将模型的记忆划分为两大部分:非预期记忆和泛化。

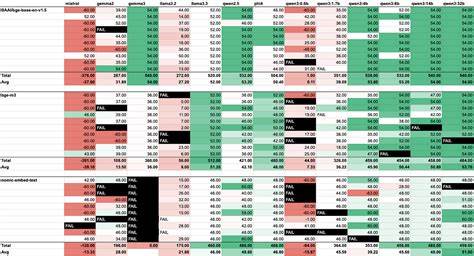

非预期记忆指的是模型对训练集中某些具体数据的直接记忆,这种记忆有可能带来信息泄露的风险。泛化则是模型学习到数据背后的规律和模式,从而能够推断和生成未曾见过的信息,是模型真正智能的体现。为了准确衡量语言模型的记忆能力,研究团队设计了一种创新的方法,能够剥离泛化效应,单纯评估模型对具体数据点的“记忆量”。通过这一方法,他们发现,现代的GPT风格的语言模型大约每个参数存储有3.6比特的信息,这被视为语言模型的容量指标。容量作为一种量化标准,帮助我们理解语言模型的潜在限制和优化方向。随着训练数据量的增长,模型记忆的表现并非线性变化。

起初,模型会不断增加对数据的记忆,直到达到其容量极限。此时出现了模型“顿悟”(grokking)现象,即模型开始从简单的记忆转向更深层次的泛化理解。顿悟之后,非预期记忆反而会减少,因为模型不再依赖逐字记忆,而是依赖对数据本质的理解。这一发现具备深远意义:它表明模型通过不断训练,能够摆脱对训练集的机械记忆,获得更强的泛化能力,从而提升实际应用中的表现及安全性。该研究涵盖了500K到15亿参数规模的数百个变换器模型,系统地建立了模型容量和数据规模与成员推理攻击(membership inference)之间的关系。成员推理攻击是评估模型是否过度记忆训练数据、可能导致隐私泄露的重要指标。

研究表明,模型越接近其容量极限,发生成员推理攻击的风险越大;而随着泛化能力的提升,这类风险出现的频率则下降。这些成果不仅为学术界提供了新的理论框架,也对业界设计更安全、更高效的人工智能系统具有指导意义。现代语言模型的记忆机制复杂,既包括对数据的直接记忆,也涵盖通过泛化获得的更高级别信息。弄清楚两者的界限,有助于平衡模型的学习效率和隐私保障。未来的研究可能会在提升模型泛化能力的同时,设计更完善的机制减少不必要的记忆,以避免数据泄露。同时,该领域的进步也将有助于开发更符合伦理规范的人工智能技术。

语言模型的记忆容量及其泛化行为,是连接理论研究与应用实践的重要桥梁。理解和量化模型所记忆的信息量,不仅揭示了神经网络的工作原理,也为模型的优化提供了方向。随着新技术和新算法的不断涌现,语言模型在保持强大能力的同时,其记忆策略也将越来越科学与合理。综上所述,语言模型的记忆远非简单的数据存储,而是一个动态变化的过程,涉及模型容量、训练数据量以及模型的泛化性能。把握这一点,有助于我们更好地评估和使用这些强大的工具,推动自然语言处理技术迈向新的高度。