随着人工智能技术的不断发展,语音交互已经成为人机交流的重要形式。Google DeepMind最新发布的Gemini 2.5模型在音频对话和生成技术上实现了重大突破,成为推动多模态AI发展的一座里程碑。Gemini 2.5不仅能够理解和生成文本,更具备处理图像、音频、视频和代码等多种模态的能力,为用户带来丰富而自然的交互体验。 Gemini 2.5的音频对话系统采用了自上而下的设计理念,能够实现实时、高质量的语音交流。传统的语音识别和合成技术往往在语音的情感表达、语调节奏和语音风格调整方面表现有限,Gemini 2.5通过内置的音频理解及生成机制,实现了用户与AI之间更自然、流畅的对话。它不仅能精准识别说话内容,更能捕捉语音中的情绪变化、口音差异甚至非语言声音,例如笑声和叹息,令交互更具人情味。

Gemini 2.5的最大亮点之一是它在对话中的风格控制能力。用户可以通过自然语言指令轻松调整AI的语音风格,比如设置口音、音调、语速,甚至让系统“低声细语”。这不仅提供了高度个性化的交互体验,也极大地拓宽了该技术在播客、游戏、教育和客户服务等多领域的应用潜力。 此外,Gemini 2.5支持多工具集成和函数调用,在对话过程中可以实时获取外部信息,例如结合Google搜索提供最新数据,或调用定制开发的工具,显著提升对话的实用性和智能化水平。它具备对对话上下文的敏锐感知,能够主动识别并忽略背景噪音及无关语音,只在合适的时机回应,避免了传统语音助手频繁被环境干扰的难题。 Gemini 2.5还突破性地实现了音频和视频内容的联合理解。

通过实时流媒体音视频输入,这一系统能够针对屏幕共享或摄像头捕捉的信息进行语音对话,增强了远程协作和虚拟助理的交互体验。更令人惊喜的是,它支持超过24种语言,并且能够在单句话中灵活切换多语言,使其在全球化应用中具有极高的适应性和竞争力。 在文本到语音(TTS)技术方面,Gemini 2.5同样展现了领先优势。该模型不仅保证了语音生成的自然度,还创新性地赋予用户对生成语音的全面控制。无论是诗歌朗读、新闻播报还是故事讲述,用户都能通过自然语言指令精准设定情感表达、语速节奏和发音细节,令生成的声音更加生动和富有表现力。 值得一提的是,Gemini 2.5支持多说话人对话生成,基于文本内容自动合成两人甚至更多演员的多声道互动音频,极大提升了内容的趣味性和沉浸感,为音频内容创作者提供了强力工具。

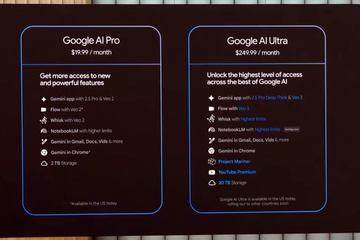

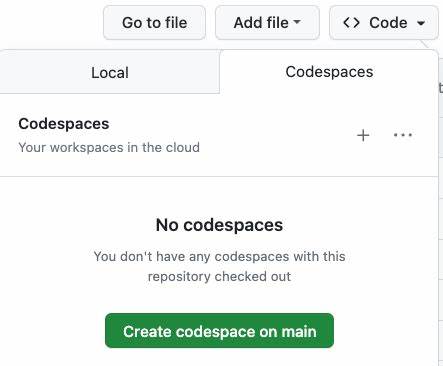

与此同时,多语言生成能力也为跨语言传播和多文化内容制作带来了便利。 Google DeepMind对安全与责任问题高度重视,Gemini 2.5在研发过程中严格评估潜在风险,采取了多层次的安全防护和伦理策略。所有AI生成的音频都会嵌入SynthID数字水印,确保内容的透明度和追踪能力,有效防止技术被滥用。这种负责任的设计体现了谷歌在AI伦理方面的领先水平。 开发者方面,Gemini 2.5提供了丰富的API能力,支持通过Google AI Studio或Vertex AI平台,轻松调用原生音频对话和生成接口。这不仅加速了创新应用的落地,也为创业公司和大型企业打造智能语音服务提供了坚实基础。

无论是实时语音助手、交互式学习工具还是多媒体内容生产,Gemini 2.5都能助力开发者实现更智能、更具表现力的产品体验。 综合来看,Gemini 2.5代表了当前AI音频技术的前沿,融合了多模态理解与生成能力、强大的语音风格调控、多语言支持和安全透明机制,其应用潜力涵盖客服、内容创作、虚拟助理、智能家居、娱乐游戏等众多领域。随着这一技术的不断成熟和普及,未来人们将享受到更为自然、丰富和智慧的语音交互体验,人工智能在日常生活中的应用将变得更加深入和广泛。 Gemini 2.5不仅是技术进步的象征,更是开启智能音频新时代的钥匙。通过它,AI与人类的对话不再是冰冷的机器回应,而是充满人情味、富有表达力的交流伙伴。对于行业从业者和技术爱好者来说,深入理解和利用这项技术,无疑将成为抢占未来智能语音市场的重要优势。

Google DeepMind持续推动多模态AI演进,未来或将带来更多创新突破,激发整个生态系统的活力与创造力。