近年来,人工智能领域尤其是自然语言处理技术经历了飞速发展,GPT-2模型凭借其强大的文本生成能力在业界引起了广泛关注。GPT-2 124M模型作为其中一个基础版本,因其适中的规模和良好的性能成为学习和研究的热点。通常,此类模型的实现依赖于Python及其深度学习库,但近日出现了一个极为创新的项目:利用Bash和Awk脚本语言实现GPT-2 124M模型。这一突破不仅为语言处理带来新的思路,也为资源有限的环境提供了另一种可行方案。Bash与Awk作为传统的脚本技术,均以其简单、高效和易于嵌入系统任务而著称。一般情况下,Bash用作系统命令行的自动化工具,Awk则专注于文本处理。

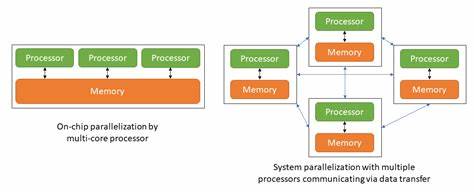

将这两者结合来实现复杂的神经网络模型,显然是一项技术挑战和创意表现。该项目主要通过详细的脚本设计和精妙的文本处理逻辑,将深度学习中繁复的矩阵运算和模型推理封装在Linux终端环境。项目采用了基于Conda环境的依赖管理,以确保运行时库与脚本协同工作,保证代码的兼容性和运行效率。用户首先需要创建相应的Conda虚拟环境,确保包括Python及其相关库得到正确安装。紧接着,通过Python工具导出模型权重,这是将预训练的GPT-2参数转换成脚本可以调用格式的关键步骤。值得一提的是,项目对awk的实现版本有明确要求,推荐使用gawk以避免mawk在处理Unicode和UTF-8编码时出现的兼容性问题。

通过设置gawk为默认awk,脚本在处理多字节字符时表现更为流畅,减少了编码错误的概率。启动脚本运行时,用户只需指定输入文本、期望生成的token数量、权重所在目录以及临时文件存储路径。整个生成过程虽然运行时间较长,通常需要数小时甚至更久,但与最初版本相比性能提升显著。该项目作者指出,初代实现生成一个token时可能需时超过36小时,而当前优化已将此大幅缩短至一两小时,这对于纯脚本实现来说极具成果。在实践中,实现Bash与Awk操作深度学习模型带来了极大挑战。首先,这两种语言并非为严密的数值计算设计,缺少高级数组和矩阵操作的优化。

其次,处理大规模模型参数时,文件加载与内存管理同样面临考验。作者通过巧妙的文本解析和流程控制,成功绕过了这些限制,实现了模型的前向传播和文本生成。该方案虽然不适合高性能生产环境,但它展示了极具探索价值的思想和实现方法,为理解神经网络模型底层机制提供了全新视角。它同时也激发了社区对轻量级脚本语言能否胜任深度学习任务的思考,拓宽了人们对于代码可移植性与兼容性的认知边界。另一方面,该实现依然有不少提升空间。比如,可以尝试引入更高效的脚本解释器,或结合C语言扩展模块加速关键运算,进一步缩短生成时间。

此外,针对模型参数的压缩和简化,也有助于减轻资源消耗,加速执行。该项目持开放态度,欢迎利用者贡献代码、报告问题和提出改进建议。通过社区协作,将有望推动此类创新技术不断完善,适配不同用户需求。总结而言,Bash和Awk实现GPT-2 124M模型不仅是一项技术实验,更是脚本语言应用领域的一次突破。这项工作展示了在传统命令行环境下实现现代AI模型的可能性,拓展了开发者的工具箱。对于热衷于深层技术探索和创新实践的人士来说,它既是学习机器学习底层逻辑的绝佳资源,也是激发创意灵感的触发点。

未来,伴随着算法优化和计算能力提升,类似基于轻量脚本语言的AI实现方案可能在边缘计算、低功耗设备以及教学领域获得更多关注与应用。