随着人工智能技术的迅猛发展,AI写作已逐渐成为内容创作领域的重要助力。然而,传统的书籍生成方式因其章节的顺序依赖,导致整体制作时间冗长且易受单点故障影响,严重制约了大规模、高质量内容的快速输出。近年来,业界探索出一种基于无状态架构的并行生成模式,成功将生成时间从传统的60分钟大幅缩短至3.5分钟左右,彻底革新了AI书籍创作体验。传统AI书籍生成流程中,章节的生成环环相扣,前一章完成后才能启动下一章,这种线性流程天然带来了时间上的瓶颈。同时,任何一个章节生成出现超时或错误,都会导致全文的生成失败,极大降低了系统的容错性和鲁棒性。作者和用户面临漫长等待,体验感不佳,尤其在现代快节奏的信息环境下显得尤为低效。

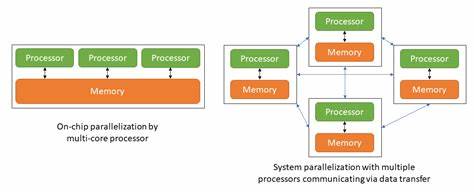

无状态并行生成架构的核心理念是打破章节之间的依赖关系,通过构建一个涵盖整本书必要信息的“全局上下文”文档,让每一章节在独立环境中利用相同的上下文信息同步生成。这样一来,各章节之间完全解耦,实现真正意义上的并行处理。具体而言,系统首先通过人工智能模型根据书籍大纲和主题抽取并整合关键信息,生成一个综合性的上下文文件。然后利用云端强大的并行计算能力,如AWS Step Functions的Map状态实现将各章节任务同时派发给独立的计算单元。每个单元负责根据上下文信息独立生成对应章节文本。生成完成后,所有章节将按预定顺序智能组装成完整书籍。

整体流程自然缩短为3.5分钟左右,相比传统的线性处理快了数十倍。这种架构不仅极大提升了速度,还带来了极高的稳定性。单个章节出现超时或失败时,其他章节依旧能够正常并行计算,无需重新生成整本书,极大降低了资源浪费与用户等待时间。该解决方案特别适用于非虚构类多章节书籍,且适合5到20章节的中等规模作品。由于上下文生成在前期完成,确保了文本内容的一致性与连贯性。事实上,这种无状态并行生成架构不仅适合书籍生成,还可广泛应用于教育课程编写、内容代理机构大规模文本创作、以及需要快速响应的SaaS内容服务平台,极大提升内容生产效率和扩展性。

考虑到现代云计算资源的普及,基于AWS Lambda等无服务器计算平台的实现方案具有极佳的弹性和成本效益。开发者只需关注上下文生成和章节独立生成逻辑,无需维护复杂的状态管理,降低了开发和运维门槛。此架构同时支持市面上主流的大型语言模型API,如OpenAI和Anthropic,使其具有高度的灵活性和兼容性。尽管该方法有“需要提前准备完整上下文”的限制,但在大多数非虚构文本场景中,预先构建上下文是自然且必要的步骤,对于保证文字逻辑衔接尤为关键。当前的技术迭代也在持续优化上下文自动生成的效率和精度,从而不断推动整体解决方案的性能边界。并行无状态架构的兴起,为AI写作带来了真正意义上的速度革命,使得作者和出版社能够在极短时间内完成海量作品的生成和发布,打破了以往创作的时效瓶颈。

此外,该模式还提供了高度灵活的容错机制,有利于构建稳定可靠的内容生产系统。在未来,随着计算能力的进一步提升和大型语言模型的不断进步,这种架构有望在更多文本创作领域发挥更大价值,推动AI与内容产业的深度融合。综合来看,基于无状态并行架构的书籍生成方法不仅实现了速度的质变,更引领了一种全新的内容自动化思路。它打破了传统章节依赖,人人都能获得高效可靠的智能写作体验,帮助出版商、教育机构和内容服务商快速响应市场需求。正是这种技术创新,推动了AI内容生成从辅助工具走向真正生产力的跃升,驱动着数字时代的内容产业迈入高质量、高效率的新篇章。