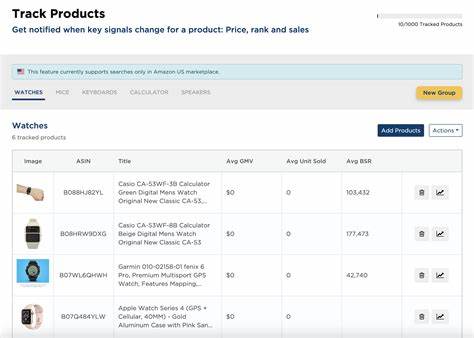

在人工智能领域的不断发展中,如何提升复杂任务的解决效率和准确率成为关键课题。近年来,融合不同模型优势的合金智能体概念逐渐走入视野,其核心在于通过多款大型语言模型(LLM)的交替调用,利用各自独特的强项,实现整体性能的跨越式提升。这一创新思路已在XBOW这一自主渗透测试系统中得到成功应用,彻底改变了传统单一模型驱动的智能代理的表现。XBOW是一款自主自动的渗透测试工具,能够针对网站进行模拟攻击测试,并在发现漏洞时及时反馈,以助开发人员完善安全防护。作为完全自动化的系统,XBOW的核心挑战在于让智能代理无需人为指引,独立执行大量繁琐且复杂的测试任务。核心问题在于,渗透测试不仅涉及对庞大攻击面多层次的探索,还需要构建持续更新的目标网站认知模型,理清其中的技术栈、逻辑关系与潜在漏洞。

期间需要智能代理反复尝试不同攻击路径,筛选有效线索,不断调整策略以最大化成功率。传统的智能代理通常使用单一大型语言模型来完成这些迭代动作。每一步,模型基于当前收集的信息生成下一步操作建议,比如运行命令行指令或执行自动化脚本。XBOW的测试设计中单轮迭代次数有限,超过一定次数便会终止以避免效率下降。挑战在于,渗透测试过程并非线性提升的明显进展,更像是在广阔复杂的搜索空间中不断试错:误入死胡同后及时纠偏,最终依靠积累的多条有效路径和关键思路突破难关。正是由于这一特性,XBOW团队萌生了融合多种模型实力的“合金智能体”构想。

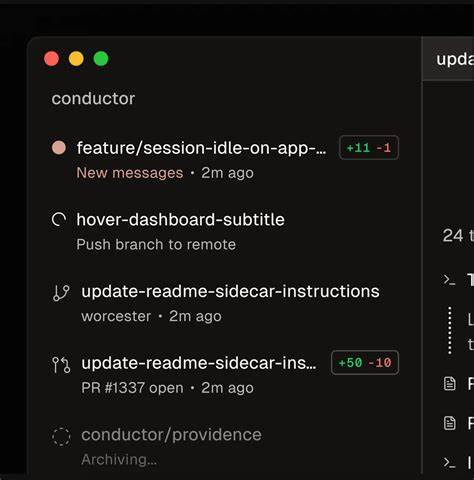

不同于以往单一模型循环调用,这一策略轮换使用多个大型语言模型生成动作指令,形成互补优势。具体实现时,所有操作均在单一对话线程中执行,模型间并不“知晓”彼此存在,换言之,某一次返回内容虽然由模型A产生,但下一轮由模型B继续接收处理,所有内容对各自而言均如自我输出。此种设计简化交互复杂度,又保持了多模型潜能的联动。为何选择不同模型交替调用?实验证明,不同模型对于解决某些渗透测试子任务的表现差异显著。例如,升至Sonnet 4.0与Google Gemini 2.5 Pro后,单模型表现虽均优异,但各自擅长的“灵感类型”存在互补。结合起来,可覆盖更广泛的思路组合,极大提升成功率。

XBOW实际测试数据显示,单独使用Sonnet 4.0或Gemini 2.5 Pro的成功率分别为约57.5%和57.2%,而融合两者形成合金智能体后,成功率跃升至68.8%以上,充分验证了多模型交叉优势。更有趣的是,性能提升与模型间差异度成正相关,模型越独特,合金效果越显著。另一方面,如果某个参与合金的模型性能明显落后,反而可能拉低整体表现,因此实际部署时需权衡模型质量与组合策略。此外,模型调用次数的分配也影响合金效能,合理倾斜至更强模型一般能得到更好结果。合金智能体不仅适合复杂的多思路任务,也极适合需要在有限时间和尝试次数内不断调整策略的场景。但该方法并非无懈可击。

场景若为进度稳定递增、每步均持续靠近目标,单一模型持续发力反而更高效。不仅如此,涉及非常长提示与短答复时,合金模型的缓存和成本压力亦较大,应考虑综合投入收益比。而且,合金思维真正产生效果的前提是各模型间存在核心优势互补,若选用同一家厂商旗下相似算法,实际提升空间不大。相比业内其他多模型协作理念,合金智能体简单直观,无需复杂的任务划分、多模型投票或让模型彼此对话,因而在迭代和效率上具备明显优势。通过同一对话线程交替调用模型,既避免繁复协调,也保留了不同视角的进攻力量。在多样化问题求解中,这种思路形象地映射了“两个大脑比一个强”的理念。

基于此,合金智能体不仅限于渗透测试领域,对其他需要多阶段、多思路接力解决的问题同样具备借鉴意义。未来,随着人工智能模型持续多样化,合金智能体框架将成为将多模型优势最大化的关键路径之一,为智能系统注入更强的灵活性和创造力。同时,团队还在尝试更复杂的模型调用策略,例如基于随机、轮流或任务特征动态调整模型调用顺序,实现更加智能化的组合效果。人工智能业界对于如何将不同模型力量最优结合早有诸多探索,AutoGPT中的任务拆分、多模型问答投票、智能辩论等方式各有千秋。XBOW的合金智能体提供了一种专注于连续迭代任务的简洁高效方案,有望成为未来智能代理设计的重要范式。总之,合金智能体以多模型轮换调用作为核心机制,成功突破了单一模型固有局限,显著提升了复杂任务中的解决力和成功率。

这一创新不仅推动了安全自动化领域的发展,更为广泛的人工智能应用开辟了新思路。对希望提升智能代理表现的开发者和研究者而言,尝试构建合金智能体并结合自身需求设计灵活调用策略,无疑值得投入时间与资源。合金智能体正以其独特优势赋能智能时代,为我们勾勒出更加开放、多元且强大的人工智能未来蓝图。