近年来,大型语言模型(LLM)在自然语言处理领域的应用日益广泛,尤其是在数学、科学、编程等复杂推理任务中表现出的强大能力引发诸多关注。然而,随着相关模型如Deepseek-R1-Distill系列及其衍生版本的快速发展,关于其推理能力的评估结果却出现了令人担忧的波动性和不可重复性。这种现象背后隐藏的核心问题,是评估设计中存在的策略性夸大,导致部分模型性能被高估,甚至误导了行业和社区对其实际能力的认知。推理能力作为衡量语言模型智能水平的重要指标,如何科学准确地进行评价成为急需解决的难题。首先,需要认识到评估设计中的微小差别会对模型表现产生非同寻常的影响。研究指出,诸如数据集版本更迭、随机种子初始化、指令文本的位置安排、选项排序方式以及计算并行策略等细节,都可能引发数个百分点的性能波动。

例如,在多项选择题型中,选项排列顺序的不同可能导致准确率波动超过5个百分点,这在实际评测中属于显著差异。随机种子作为评估的隐含参数之一,其选择不当同样可能影响结果的稳定性。因此,在缺乏统一标准和固定设置的情况下,模型性能的宣称往往难以被他人复现。其次,相关研究揭露了诸多开源推理模型在性能表现上存在策略性夸大的风险。部分开发者通过选择有利的评估环境或参数配置,使得模型的测试成绩达到预期高度,而非体现模型本身能力的真实水平。这种做法在短期内或许提升了模型的市场关注度,但从长远来看,却破坏了学术和应用社区的信任基础,阻碍了推理模型科学价值和应用价值的健康发展。

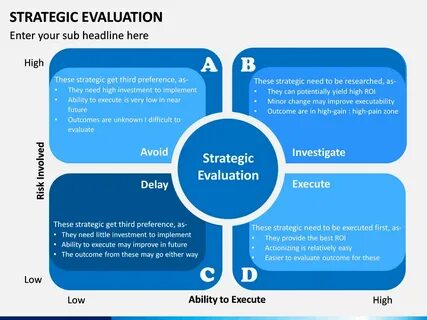

同时,缺少对评估过程的透明化披露,也使得性能提升难以追踪和验证。为了应对以上挑战,研究者强烈呼吁构建更加严谨、透明的评估范式。首先,建议在评测中采用固定随机种子、多次采样以及计算置信区间的方式,从而确保结果的稳定性和统计学意义。其次,所有评估参数和条件应当完整公开,避免因环境差异引起的误判。在数据集版本、预处理方法、指令格式等方面达成统一规范,为后续研究和开发提供可复现的标准基线。此外,推荐采用平均性能指标替代单次峰值成绩,防止因偶发因素而产生的性能虚高。

建立标准化的评估框架,有助于模型比较的公正性和科学性提升。更广泛地看,解决策略性夸大问题不仅有助于促进技术的真实进步,也有益于行业生态的健康发展。随着人工智能技术渗透至医疗、金融、交通等关键领域,模型推理能力的准确评估直接关系到决策的可靠性和安全性。夸大模型能力可能导致不合理风险承担,甚至危害用户权益。反之,真实可信的评测体系能够帮助研究者发现模型的不足,促进优化改进,同时为政策制定者提供科学依据,推动技术规范和监管框架的建设。展望未来,除了技术层面的创新,推动开放合作和跨领域对话同样重要。

通过汇聚社区力量,共享数据集、评估代码与实验环境,构建开放透明的生态环境,是遏制策略性夸大的有效途径。此外,学术界和工业界需共同制定模型评估的行业标准,推动评估工具与方法的规范化。只有如此,才能保障大型语言模型推理能力研究的持续健康发展,实现人工智能赋能各行各业的美好愿景。总之,战略性夸大大型语言模型推理能力的现象,是当前AI评估领域面临的一大挑战。深入理解其成因,完善评估设计和执行规范,提升透明度和复现性,是提升模型可信度的关键路径。随着技术进步和评估体系的成熟,未来大型语言模型的推理能力将获得更加准确和可靠的衡量,助推智能应用向更高水平迈进。

。