随着人工智能技术的不断进步,尤其是大型语言模型(Large Language Models, LLMs)在软件开发领域的崛起,代码自动生成正逐步改变着传统的编程方式。利用自然语言指令促使模型生成代码,已成为许多开发者提升效率的利器。然而,安全问题始终是软件开发过程中无法回避的挑战。自动生成的代码如果含有安全漏洞,可能会给系统带来严重威胁。因此,如何通过有效的提示技术提升生成代码的安全性,成为当前研究的热点与难点。本文将围绕安全代码生成的提示技术展开,解析其内涵、分类以及在实际应用中的表现,帮助读者全面了解该领域的最新研究进展和实践方向。

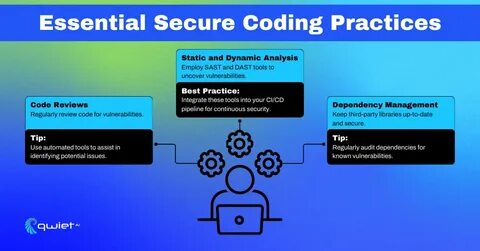

提示技术,顾名思义,是指针对人工智能模型,设计并优化自然语言输入,以引导模型产生更准确、更符合预期的输出。对于代码生成任务而言,提示的精准度和策略直接关系到生成代码的质量和安全性。不同的提示方法能够激发模型的潜能,提升代码的完成度和健壮性,从而防范潜在的安全漏洞。研究显示,传统的简单指令通常难以确保代码的安全性,模型在缺乏明确指导的情况下,容易生成带有采信漏洞或不安全编码习惯的代码片段。早期的提示策略多聚焦于功能实现层面,强调代码的逻辑正确性和执行效率,而忽略了信息安全维度。随着研究的深入,学者们开始探索结合安全审计、漏洞检测等元素的复合型提示方法,这些方法能够促使模型在编写代码时同步考虑安全防护措施。

现有的提示技术可大致分为几类,其中递归批判与改进(Recursive Criticism and Improvement, RCI)的技术被证明在减少代码缺陷和安全漏洞方面尤为有效。RCI方法通过多轮交互,允许模型对自身的生成结果进行反思和修正,逐步改进代码质量。具体来说,模型在生成初稿后,便主动检查并指出潜在的问题,随即根据反馈调整代码,实现安全和性能的双重提升。这种动态迭代的促动机制,有效弥补了单次生成中对安全考虑不充分的问题。此外,分步骤提示(Step-by-Step Prompting)、引导式链式思维(Chain-of-Thought Prompting)等技术也显示出辅助代码安全提升的潜力。这些技术通过引导模型细化思路,拆解复杂任务,让模型跟随清晰的流程生成代码,从而降低错误率和安全隐患。

研究人员利用包含150条与安全相关的自然语言代码生成提示的数据集,将多种提示技术应用于GPT-3、GPT-3.5及GPT-4等主流大型语言模型,发现通过科学设计的提示策略能够显著降低代码中存在的安全弱点。这一发现不仅说明了提示技术的重要价值,也为未来安全代码自动化生成提供了实践依据。未来,安全代码生成的提示技术有望继续向多模态、上下文感知以及知识融合方向发展。借助更丰富的安全知识库、漏洞库,结合自动化审计工具,提示技术能够实现对代码安全的全方位保障。同时,随着模型不断升级和优化,提示细粒度和语义深度的提升也将极大促进安全代码生成的实践应用。这对于开发者而言,是提升代码质量与安全防护能力的重要利器。

企业在实际项目中若能合理运用这些提示技巧,不仅能够节省大量漏洞修复和安全审计的成本,更能在激烈的市场竞争中提升产品的信誉度和用户信任感。综上所述,提示技术是连接自然语言与安全代码生成的桥梁,其科学设计和精准应用对确保自动化编程结果的安全性具有关键意义。推动这一技术的发展,需要多领域的协同努力,共同构建更加智能、安全、可靠的软件开发生态。未来,随着人工智能与安全工程的融合加深,基于提示技术的安全代码生成必将成为软件产业创新和进步的重要引擎。