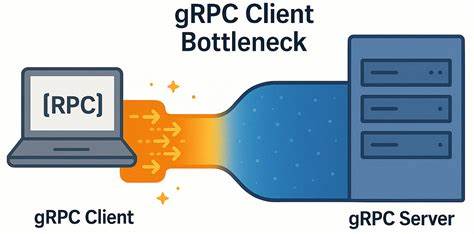

随着分布式系统和微服务架构的广泛应用,gRPC作为一种高效的远程过程调用协议,逐渐被视为跨服务通信的首选方案。其基于HTTP/2协议,支持多路复用流,天然适合高并发、低延迟的场景。然而,事实证明,在极低网络延迟环境下,gRPC客户端依然可能成为性能瓶颈,限制整个系统的响应速度和吞吐能力。YDB团队的深入研究和实测给我们提供了宝贵的洞见。gRPC客户端瓶颈主要体现在其单连接多路复用机制受限于HTTP/2协议的并发流数上限,进而引发请求排队、响应延迟增加的现象。在使用单一TCP连接时,HTTP/2连接存在最大并发流数限制,通常默认为100。

这意味着当并行RPC请求数接近上限时,新发起的RPC请求将被阻塞,等待已有请求完成后才得以发送,形成客户端请求堆积,延迟陡增。YDB在使用gRPC暴露数据库API时观察到,随着集群节点数减少,客户端发起负载的能力反而下降,资源利用率降低且客户端延迟不断上涨,这一逆势表现引发了深入排查。通过构建简单的gRPC ping微基准测试,YDB团队得以复现并分析瓶颈。测试环境中,客户端与服务器部署在两台配备高性能英特尔Xeon处理器的物理机器上,网络带宽高达50Gbps,网络往返延迟低至0.04毫秒。即便如此,在使用单连接且多工并行请求时表现仍未达预期的线性可扩展性能,延迟逐渐攀升且吞吐增长受限。深入监控揭示TCP连接唯一、网络无拥塞、TCP窗口及Nagle算法配置合理,服务器响应迅速,瓶颈实际上源自客户端gRPC层内部机制。

客户端将多个工作线程的RPC请求复用至同一HTTP/2连接,受限于并发流限制,导致请求批量发送和响应批量回包之间出现150到200微秒的停顿,形成性能瓶颈。对此,官方gRPC性能最佳实践建议采用多连接策略,具体包括为高负载区域创建多个独立gRPC通道(Channel),或采用通道池方式分散RPC负载。YDB团队实测发现,这两种策略并非割裂的选项,而是同一问题的两个改进步骤。通过为每个worker创建独立且带有区分参数的gRPC通道,客户端不仅打破了单连接流数限制,还借助GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数进一步优化子通道池的隔离,实现了高吞吐和低延迟双重目标。实验数据体现出显著的性能飞跃。在单连接多RPC请求模式下,增加10倍客户端并发仅带来3.7倍吞吐增长,且延迟线性上升。

而经多连接分配优化后,吞吐提升达6倍,延迟增幅明显减缓,系统运行更加稳定高效。YDB东测还针对网络延迟较高(如5毫秒)的环境进行了对比实验,结果显示在中高延迟网络中,该瓶颈影响较小,即多连接优化优势在低延迟环境下更为显著。这一发现为高性能分布式数据库和微服务架构的设计者敲响警钟。网络层面无明显瓶颈时,应用层通信协议的内部机制仍可能成为制约性能的隐形壁垒。尤其在现代云原生及边缘计算场景下,低延迟需求日益凸显,深入理解gRPC的通信架构和客户端行为显得尤为重要。针对实际应用,开发者可参考YDB团队的优化思路。

首先,应避免多个worker复用同一gRPC通道而产生竞争,推荐为每个worker或逻辑单元创建独立通道,且确保通道参数唯一以避免连接共享。其次,合理配置GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,优化子通道池的本地复用,降低竞争资源。再次,结合业务场景设计合理的并发请求数,避免超出HTTP/2协议本身的流数限制。最后,要结合NUMA绑定、线程亲和性等底层系统调优,确保处理器资源高效利用,减少跨核通信开销。除了架构调整外,持续监控网络与应用性能指标,捕捉异常延迟波动,有助于及早识别瓶颈并调优。YDB团队的分享不仅对数据库领域具有指导意义,对所有应用gRPC通信的分布式系统同样适用。

通过合理的多连接策略和参数配置,可以显著提升整体系统的响应速度与吞吐能力,缓解低延迟网络环境下的隐性瓶颈问题。展望未来,随着gRPC社区和生态不断发展,可能会出现更加灵活的多路复用配置方式、增强的连接管理策略,以及多通道负载均衡优化。相关企业和开发者也应密切关注这些进展,将其引入自身系统,持续提升分布式服务性能和用户体验。同时,YDB团队鼓励行业同仁及开源社区参与性能优化,共享经验、贡献代码,共同推动gRPC技术在极端高并发低延迟环境下的应用成熟。综上所述,gRPC客户端在低延迟网络中存在的意外瓶颈,源自于HTTP/2连接并发流数限制和客户端多线程绕不过的资源竞争。通过创建多通道、优化通道参数和合理控制并发请求数方案,可有效突破瓶颈,实现系统响应与吞吐的最佳平衡。

掌握这一关键技术细节,是迈向高性能分布式应用的必由之路。对于追求极致性能的开发者而言,持续关注gRPC协议内部机制及其最佳实践,是确保应用能够在未来复杂业务场景中脱颖而出的关键因素。