随着开源模型和推理工具的发展,在本地运行大型语言模型(LLM)变得越来越可行,也更具吸引力。无论你是开发者、研究人员,还是对数据隐私有较高要求的个人用户,掌握本地部署 LLM 的核心思路都能带来更高的控制权、更低的使用成本以及更灵活的定制能力。本文将从为什么要本地化、硬件与软件要求、主流工具与对比、模型与量化建议、实操步骤、性能优化到安全与合规等方面,提供可直接落地的指导与实践建议,帮助你在最短时间内搭建并稳定运行本地 LLM 环境。 为何选择在本地运行 LLM 本地运行 LLM 最直接的优势是隐私和控制。对敏感数据不再需要发往第三方云服务,从而避免潜在的数据泄露风险和不必要的合规负担。其次,长时间高频使用时,本地推理的边际成本显著低于云 API 支出。

对于延迟敏感的应用,尤其是在没有稳定网络或需要局域网低延迟访问的场景,本地部署能带来更好的响应速度。最后,本地部署利于模型微调与插件集成,便于将模型定制为面向企业内部知识库、代码助手或专用分析工具。 硬件与软件基本要求 机器内存(RAM)与显存(GPU VRAM)是决定可运行模型规模的关键。经验法则是模型量化后所需内存应低于系统可用内存,否则会频繁发生掉页或性能退化。有 GPU 的机器能显著提升推理速度,NVIDIA 显卡凭借成熟的 CUDA 生态在 Windows 和 Linux 下有优势;Apple Silicon(M1/M2/M3)在 macOS 上也表现出色,尤其配合 Metal 优化的推理后端。没有 GPU 的情况下,利用基于 llama.cpp 的 CPU 推理与 4-bit 量化也能带来可用的体验,但速度会比 GPU 慢许多。

理解量化与推理后端 量化是将模型参数从高精度(如 32-bit)降到低精度(如 8-bit、4-bit)以节省显存和内存占用的过程。常见的量化策略有 8-bit、4-bit(Q4_K_M 等格式)与混合精度方案。4-bit 量化在保证输出质量的同时极大降低资源需求,是目前在消费级硬件上最常见的选择。推理框架方面,llama.cpp 因为其优秀的 CPU 推理性能与广泛兼容性,成为许多本地工具的底层引擎,而针对 GPU 的推理则有更高性能的后端,如 GGML、vLLM、CUDA/Trt 或基于 Metal 的实现。 主流本地运行工具对比与场景适配 LMStudio、Ollama、OpenWebUI、LocalAI、GPT4All、AnythingLLM 等工具各有侧重点。LMStudio 提供丰富的桌面交互体验,适合希望快速上手并追求易用性的用户;Ollama 更加简洁,配置开箱即用,适合希望最低门槛尝试本地 LLM 的用户。

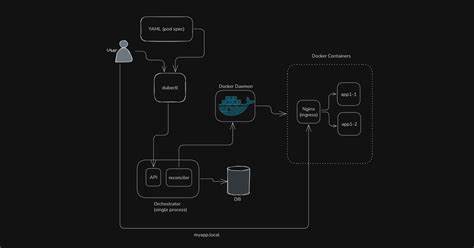

OpenWebUI 则偏向高度可自定义的 Web 前端,适合高级用户做插件或模型试验。LocalAI 更适合在服务器或容器化场景下作为本地推理 API 使用,便于与其他系统集成。选择工具时优先考虑目标场景:桌面交互、局域网服务、科研实验或生产 API 接入。 推荐模型与任务匹配 选择模型时优先考虑任务类型与硬件限制。通用聊天与写作任务可以选择 GPT-OSS、Gemma 系列或 Mistral 家族的 7B/13B 模型;编码辅助可首选 Qwen-3 Coder 或专门的 coder 系列;数学或科研任务可选 Mathstral 等针对 STEM 优化的模型。对于没有独立 GPU 的设备,可尝试 4B 或更小参数量的版本,如 Gemma 3-1B、TinyLlama 等。

Hugging Face 上很多模型会提供量化后的版本和硬件适配建议,建议在下载前查看模型页面的量化标签与运行示例。 快速上手实践建议 想要最低成本、最快速度上手的路径是使用 LMStudio 或 Ollama。下载安装后,打开模型商店或导入模型权重,程序会自动完成量化检测与运行时配置。对于更精细的控制,可以使用 OpenWebUI 或直接基于 llama.cpp 的命令行部署,通过命令指定量化类型、GPU/CPU offload 策略与线程数。在 macOS 上运行时注意安装对应的 Metal 后端或使用 Conda 环境来管理依赖;Windows 用户若使用 NVIDIA 显卡,建议安装匹配的 CUDA 与 cuDNN 版本,并为推理进程设置显存上限以避免与其他应用冲突。 性能优化实用技巧 若想提升推理速度与稳定性,优先实现模型完全放入 GPU 显存,减少 CPU 与显卡间的频繁交换。

开启 GPU offload 并调整 batch 或 context window 大小可以在不同负载下获得更好平衡。使用 4-bit 量化与适当的 KV 缓存策略(key-value cache)能显著提高长对话的响应速度。为避免系统在模型加载时占用全部内存,建议为模型进程预留空间并配置 swapfile 作为缓冲,但频繁的 swap 会严重拖慢性能,因此应作为最后的保底方案。 常见问题与排错策略 模型下载失败通常与网络或源站限速有关,使用镜像或 CDN 加速服务能有效缓解。加载报错经常源于量化格式或推理后端不匹配,确认工具与模型的量化版本一致后重试。遇到显存不足,可以尝试更低量化位数、模型拆分或开启 CPU offload。

若输出出现重复或流畅度异常,可适当调整温度、重复惩罚(repetition penalty)和 top-p/top-k 等采样参数。 Fine-tuning 与 LoRA 微调实践 在本地对模型进行微调或应用 LoRA 插件,是将通用模型改造成垂直领域助手的高效方式。对于没有大规模显存的用户,LoRA 提供轻量化微调方法,仅需在少量参数上训练即可实现明显风格或任务适配。工具链方面,可使用 PEFT/LoRA 等库将已有模型加载并训练小规模 adapter,然后将其按需合并回主模型或在推理时动态加载。 安全与合规注意事项 本地部署虽能降低外发数据风险,但仍需关注模型许可与数据合规性。部分开源权重在商业使用或再分发上有额外限制,使用前务必查阅模型许可协议。

运行含有潜在危险能力的模型时,应对接合适的内容过滤与审计机制,尤其是在企业级部署或面对未成年人使用场景时。 案例与应用场景 在企业内部,团队协作助理可通过本地 LLM 与内部知识库对接,实现保密问答、自动化文档生成与代码审阅等功能。在教育与科研领域,本地模型便于离线实验、数据私有化分析与教学演示。个人开发者可以将本地 LLM 集成到 VSCode、Obsidian 等工具中,实现离线代码补全、笔记智能搜索或隐私聊天机器人。 总结与推荐路径 对于想最快上手的用户,LMStudio 提供最少阻力的桌面体验;需要更高透明度与可编排能力的用户可从 Ollama 或基于 llama.cpp 的 OpenWebUI 开始;面向生产部署或集群化推理应考虑 LocalAI 或容器化的推理服务。无论选择哪条路径,核心在于合理评估硬件能力,优先选择适配显存的量化模型,并在性能、隐私与合规之间找到合适平衡。

掌握这些基础之后,你就能将本地 LLM 变成可靠的日常工具,为工作与创作带来实质性的效率提升。 。