随着人工智能从云端回流到设备端,边缘图像分类成为许多行业实践的核心需求。边缘部署要求模型在延迟、功耗与隐私三方面达到严格平衡,同时不能牺牲分类精度。实现既快又准的边缘图像分类,需要对模型架构、推理策略、训练方法与工程化部署做系统优化。本文聚焦本地视觉语言模型(Visual Language Models,VLM)及其在边缘场景中的应用,结合具体技术手段与实践经验,给出可落地的路线图和优化建议。首先需要明确为什么选择在边缘进行图像分类。边缘部署的最大优势在于数据隐私与实时性。

工业检测、安防摄像、医疗影像与自动驾驶等场景往往要求在网络不可用或延迟不可接受的情况下完成判断;同时部分数据具有高度敏感性,无法传输到云端处理。此外,边缘推理可显著降低带宽与云端成本。在明确目标后,选择合适的模型是第一要务。传统的卷积神经网络在轻量化方面有丰富经验,但近年来本地化的视觉语言模型例如 LFM2-VL 系列展示了在多模态理解与文本引导推理上的独特优势。对于简单分类任务,较小体积的模型如 LFM2-VL-450M 在经过工程化优化后就能达到接近生产级的精度;对于复杂任务或噪声场景,1.6B 等更大模型提供更强的泛化能力,但需要权衡算力与延迟。权衡标准围绕三个指标展开:延迟、精度与资源占用。

实战中常见策略是先在小模型上快速验证工作流,再通过结构化生成与微调等技术将性能逐步推高。为了可靠评估模型表现,必须建立完整的评估管道。一个健壮的评估体系包括固定随机种子、分割好的训练与验证集、标准化的输入预处理、统一的 prompt 与输出映射,以及逐样本的诊断报告。仅仅看总体准确率往往掩盖问题;对不平衡数据集应优先考虑召回、精确率与 F1 等指标,特别是在安全相关的场景中更应关注少数类的召回率。样本级可视化分析非常重要,它能帮助快速定位数据集噪声、标注错误与模型系统性偏差,是后续改进的关键起点。在推理端降低错误产生的一个有效办法是采用结构化生成。

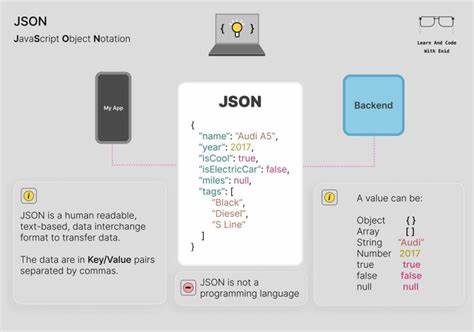

VLM 将图像信息映射到文本空间,若不加约束,语言模型可能输出超出预期的词汇,例如在二分类场景中生成品种名称而非类别标签。结构化生成通过在解码环节强制输出格式,例如限定 JSON 键名与值集合,从而减少语义发散与幻觉。这种方法既能提高结果一致性,又便于后续自动解析与决策。结构化生成的实现可借助第三方库对解码时的词表分布进行屏蔽或约束,使生成过程在关键位置保持确定性。微调依然是提升边缘模型性能的最直接手段,但直接训练大模型的成本极高。为了解决这一矛盾,LoRA 等低秩适配技术应运而生。

LoRA 保持预训练模型主权重冻结,只在特定层插入低秩适配器以学习任务相关更新,从而在显存与计算开销上大幅节约。结合 LoRA 与高效优化器,可以对边缘可部署的中小模型进行有针对性的调优,快速收敛并显著提升分类精度。在实际训练流程中,使用合理的数据划分与早期停止机制可以避免过拟合;同时建议使用混合精度训练与梯度累积以在单卡或受限 GPU 环境下完成大批量等价样本训练。除了微调,模型压缩技术是提升边缘推理速度的另一大类手段。量化、剪枝与知识蒸馏各有侧重。量化能将模型参数与激活从 32 位浮点降低到 8 位或更低位宽,显著缩短内存读写与计算延迟。

针对移动端与 NPU,整数量化兼容性尤为重要。剪枝可以去除冗余通道与参数,但需与微调结合保证精度不受损。知识蒸馏通过让小模型模仿大模型的软标签分布来提升其泛化能力,是在资源受限设备上提升性能的有效策略。部署流水线方面,将训练后的权重转换为设备原生格式是必要步骤。对于苹果生态,转换为 Core ML 格式并利用 Apple Neural Engine 可以获得最佳延迟表现;对于安卓与通用嵌入式平台,ONNX 或 TensorFlow Lite 提供广泛支持。工程实现中要关注输入预处理一致性,确保训练与推理环节的图像缩放、归一化与通道顺序完全一致,否则会导致显著性能回退。

边缘部署还需要关注运行时系统优化。实行推理批次合理化、模型热启动、内存复用与并行预处理,可以把端到端延迟降到最低。图像分辨率与窗口裁剪策略同样重要,合理降低输入分辨率可以极大提升吞吐但需要评估对精度的影响。缓存策略对重复场景尤为有效,短期缓存模型输出或中间特征能避免重复计算。在真实产品中,模型表现不仅取决于推理库,还依赖于数据质量与标签策略。常见失误包括数据集中存在文本、水印或与分类无关的元素,导致模型学习到错误的相关性。

彻底的样本级审查与清洗,以及在训练中加入代表性负样本,可以让模型更稳健。处理不平衡数据时,应考虑过采样、样本权重或任务特定损失函数来提升少数类表现。评估之外,监控与持续改进流程是保证长期效果的保障。将推理日志、错误样本与模型置信度收集并建立反馈回路,可定期进行再训练或微调以应对概念漂移。在隐私或法规严格的场景里,本地化训练与联邦学习为数据保留在设备上提供了可选方案,但这类方法在实现与验收上更复杂,需要权衡系统复杂度与合规性收益。举例说明可使概念更易理解。

对一个猫狗分类任务,初始用 LFM2-VL-450M 在原始数据上得到了接近 97% 的准确率,通过样本级可视化发现若干标签噪声与少数误导性样本后,采用结构化生成去除模型输出幻觉,再将训练数据按 90/10 划分进行 LoRA 微调与梯度累积,最终在受控测试集上达到接近 100% 的准确率。这一流程展示了从基础评估到工程化改进的完整路径。最后讨论部署生态的实践建议。选择合适的边缘 SDK 能极大简化适配工作。例如专门面向移动端的 Edge SDK 会提供设备感知的优化、模型转换工具与延迟统计接口。结合异构加速器(CPU + GPU + NPU)进行算子调度,可以在不同机型上获得更一致的体验。

企业在做大规模分发时应建立多版本兼容策略,以便在低端设备上使用更轻量模型而在高端设备上启用更强能力。边缘图像分类的未来将继续朝向更强的本地自主性、更高的能效与更低的成本迈进。本地 VLM 的出现,使得跨模态理解与基于文本的输出约束成为可能,进而提升了系统的可控性与解释性。结合结构化生成、LoRA、量化与蒸馏等技术,可以在资源受限的设备上实现近乎云端级别的性能,同时保持隐私与实时性。构建高效的边缘图像分类系统既是工程挑战也是策略选择,需要在模型、数据与系统三方面持续迭代。成功的关键在于以数据为驱动的诊断、以工程为导向的优化与以场景为中心的权衡。

。