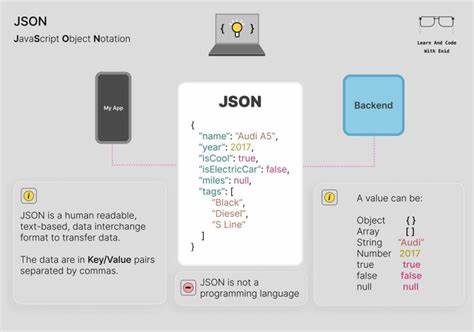

JSON曾被誉为简单、轻量且可读的通用数据交换格式,但在跨语言与异构系统之间使用时,它常常暴露出比规范更为复杂的实现差异。表面上符合规范的JSON数据在不同的解析器和运行时中会产生不同的语义,进而导致数据精度丢失、字符串比较失败、加密签名不一致、时间错位等难以定位的缺陷。理解这些差异的来源并采取工程化对策,对于分布式系统、API设计与第三方集成至关重要。 数字精度是最常见的陷阱之一。JavaScript将所有数字以IEEE 754 64位浮点数表示,这意味着大于2的53次方减1的整数会失去精度。许多后端数据库和语言本身支持任意精度整数或64位整型,导致同一条JSON记录在前端展示时整数被篡改,而后端仍保留正确值。

金融应用、数据库主键和时间戳都是受影响的高风险字段。解决之道不是依赖运行时默认行为,而是统一约定数据类型的表示方式,例如以字符串形式传递超出安全范围的整数,或在传输层使用明确的类型标注并在接收端用大整数或十进制库还原。 浮点数的十进制表示同样容易产生误导。0.1与0.2之和在多数语言的原生浮点运算中会出现0.30000000000000004这种现象,这并非JSON规范的问题,而是底层浮点表示的固有特性。关键在于对业务敏感的领域应使用定点或十进制类型,例如Python的Decimal、Java的BigDecimal、C#的decimal,或者在JavaScript中采用BigDecimal或定点库。JSON解析器通常允许将浮点数解析为更精确的数值类型,生产环境应开启或配置这些选项并在Schema中严格声明货币字段的类型。

字符串与Unicode规范化问题在国际化场景中尤为致命。视觉相同的字符可能由不同的Unicode序列组成,例如带重音的字母既可以是单个码点也可以是基础字母加上组合重音符。不同语言的库对字符串是否进行Unicode正规化并不一致,进而影响哈希、搜索、比较与身份验证。实践中应明确采用统一的正规化方案(通常选择NFC),并在数据进入系统之前对关键字段进行正规化处理和校验,避免因为字符序列差异导致的重复用户、登录失败或索引不命中。 JSON对象键的顺序问题对加密与签名流程影响极大。标准规定对象键的顺序不具备语义,但很多语言在序列化时保留插入顺序或按内部实现顺序输出,而有些实现会对键排序或以随机顺序迭代。

这会导致当签名或计算内容哈希时,同一语义对象在不同服务之间序列化为不同字节序列,从而签名不匹配。对策是采用规范化的序列化流程用于任何需要字节级一致性的场景,诸如按字典序排序键或使用已有的规范化JSON实现,确保签名和校验逻辑在所有端保持一致。 空值语义在各语言间也并不一致。JavaScript区分undefined与null,JSON中没有undefined;Python将null映射为None,Go在使用interface{}时无法区分字段缺失与显式null,Java的树形节点可以检测是否存在键但在反序列化到POJO时可能被默认值覆盖。这种不可区分性会在部分更新、差分合并和稀疏字段表示上造成模糊行为。为了解决这个问题,可以在架构层面区分显式空值与字段缺失,例如使用nullable与optional的约定,在静态类型语言中通过指针或Optional类型保留缺失信息,或者在JSON Schema中使用required与nullable组合明确语义。

时间与日期的表达没有统一类型,这导致基于时间的逻辑出现混乱。常见的时间表示有ISO 8601字符串、秒级Unix时间戳、毫秒级Unix时间戳以及各种自定义格式。不同语言或库可能误把秒当作毫秒或忽略时区信息,导致时间偏移或错误的时刻解析。最佳实践是统一采用带时区的ISO 8601 UTC表示或在Schema中明确字段的单位和时区,并在客户端与服务端都建立一致的解析与生成规则。对于接口,优先鼓励以字符串形式规范化传输时间,并在文档中注明解析规则和示例。 解析器和库对不合法或非标准JSON的容忍度也存在差异。

重复键处理、尾随逗号、单引号字符串和前导零等在不同实现中有不同默认行为。若某些实现允许宽松解析,可能会在生产中接收并储存本应被拒绝的输入,进而产生数据不一致或安全隐患。强烈建议在网关或API边界启用严格解析模式,并使用Schema验证工具拒绝不合格或潜在危险的输入。对需要兼容第三方宽松输出的场景,应在服务内明确做一次清洗并记录转换细节。 数据库和平台对JSON类型的处理也各有不同,例如PostgreSQL区分TEXT形式的JSON与规范化并优化的JSONB,二者在键排序与索引支持上有所差异。MongoDB使用扩展JSON来表示额外的类型如ObjectId與日期,这在跨平台导出导入时需要特殊处理。

将数据存入数据库前应了解目标存储对JSON的表现,并在架构设计阶段选择合适的列类型或数据模型以避免后续兼容性问题。 历史教训告诉我们,这些问题并非纸上谈兵。社交平台的ID超出JavaScript安全整数范围导致客户端显示错误的事件屡见不鲜;分布式系统中微妙的键排序差异曾导致签名验证失败而出现大规模拒绝服务;Unicode正规化差异曾让用户无法正常登录或搜索到自己的内容。面对这些真实案例,工程实践必须超越"JSON是简单的"这个迷思,采取严谨的工程方法。 可操作的缓解策略包括在组织内统一数据规范并用Schema作为契约。Schema验证工具不仅在开发与测试阶段发现错误,也应在运行时作为守卫,拒绝不符合约定的数据。

对于数字与货币字段,应在Schema中指定字符串或高精度数值类型,并在客户端与服务端都使用专门的数值库进行运算。对于字符串相关问题,统一制定Unicode正规化策略并在入库前执行正规化。对于需要字节级一致性的签名流程,应采用可验证的规范化JSON序列化方案并在所有语言实现中使用相同的库或算法。 跨语言兼容性测试是工程化防线的重要组成部分。建立自动化测试用例,覆盖数字边界、Unicode多态、键顺序、空值表现、时间格式、错误容忍度与签名一致性,将这些测试纳入CI/CD流水线。通过构建兼容矩阵,定期验证不同语言与库的序列化和解析行为,可以在发布前发现潜在的互操作性问题。

还应包含真实API样本与第三方数据以保证测试场景贴近生产。 在库选择与配置上要有意识地取舍。不是所有JSON库都适合所有场景,某些库提供高性能但对精度与可配置性支持较弱,另一些库在精度与灵活性方面更强。评估时应关注对大整数和高精度浮点的支持、是否可启用严格重复键检测、是否支持定制的数值解析以及是否可以稳定地进行键排序或规范化。文档和社区活跃度也是重要参考标准,选择在生产环境中经过广泛检验的实现可以降低风险。 总结而言,JSON作为跨系统的数据桥梁,其易用性掩盖了实现差异带来的复杂性。

工程团队需要承认这些隐性问题,并通过统一规范、严格验证、库配置、跨语言测试与明确的运行时约束将风险降到可控范围。只有把隐含假设显性化,并在团队间建立共同的契约,才能让JSON真正发挥可靠的数据交换作用,而不是成为故障调查期间最难啃的一块骨头。愿每一次序列化与反序列化都能平滑通过,而不是成为系统间互操作性的陷阱。 。