近年来,随着科技的迅猛发展和人工智能的广泛应用,用户数据的收集与使用日益成为公众关注的焦点。然而,令人遗憾的是,科技行业普遍存在对“用户同意”这一基本概念的深刻误解。这种误解不仅反映在企业的隐私政策和数据处理方式上,也体现于它们在设计用户交互和权限获取过程中所采取的策略。本文围绕科技行业对用户同意的认知缺陷展开探讨,揭示自动选择(opt-out)机制对用户权益的侵害,并呼吁实现更加透明、公正且尊重个人自主权的数据管理方式。 用户同意原则的核心在于“自愿”和“知情”,意味着用户必须在充分理解相关信息的前提下,主动同意其数据被收集和使用。然而,目前科技企业更多采用的却是“自动选择退出”机制,即默认情况下用户的数据会被采集,若用户不主动采取行动选择退出,数据依旧会被使用或出售。

这种做法无疑是对同意核心精神的背离。自动选择机制本质上是一种法律策略,目的是减少企业承担的合规风险,但从伦理角度出发,它对用户隐私构成了严重威胁。许多用户甚至因为未被明确告知或界面设计巧妙设置的障碍,根本无从知晓或选择退出,形成“假同意”的陷阱。 技术巨头自动出售用户数据用于训练人工智能模型的事件近年来频频曝光,成为公众批评的焦点。例如,知名云平台及内容管理系统运营商宣布将用户在其旗下平台(如博客和社交媒体)上的内容数据出售给人工智能开发公司,引发了用户强烈不满和激烈舆论争议。企业方面虽然发表了官方声明,声称数据交易符合用户社区的关切并提供了选择退出的选项,但这一切依然未能解决根本问题。

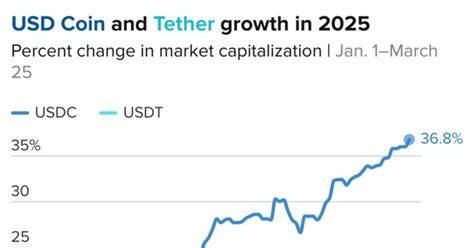

多数用户根本没有真正的“同意”,选择退出机制更像一层“保护伞”,为企业规避法律风险而非真正保障用户权益。 目前科技行业中,还存在一项极具争议但极端典型的案例——基于区块链技术的性同意记录应用。该应用将人们在某些私密行为中的同意“区块链化”,虽然听上去似乎未来感十足,但实际的隐私风险和伦理冲突同样引发了广泛质疑。区块链的不可篡改性意味着一旦记录无法删除或修正,若缺乏完善的法律保护,将严重威胁用户的隐私权和个人信息安全。这进一步凸显了行业在处理“同意”问题上的短视与缺失。 深究造成这一局面的根本原因,可以发现三大主要驱动力。

一方面,行业普遍将数据视为最重要的资产,优先考虑如何最大化数据商业价值,往往忽略用户的知情权与选择权。另一方面,缺乏统一且严格的监管体系,使得企业得以在数据使用上打擦边球,采用模糊甚至误导性的同意策略。第三,软件设计中存在的“黑暗模式”(Dark Patterns)也助长了侵害用户权益的做法。通过故意设置复杂的操作流程、隐藏关键信息或者使用误导性语言,企业诱导用户默认同意,实现数据最大化采集。 面对上述现状,业内专家和用户群体纷纷呼吁科技企业彻底摒弃自动选择退出机制,转而采用明确的“主动选择进入”(opt-in)机制。主动选择意味着只有用户明确表达同意,企业才能采集和使用其数据,这不仅符合伦理要求,也能推动行业向更加透明、负责任的方向发展。

除此之外,同意权限应具备更细粒度的控制,用户能够自行决定数据是否允许第三方、尤其是人工智能公司使用。通过赋予用户更多自主权,既保护了个体隐私,也提升了企业的用户信任度和品牌美誉。 此外,技术防护手段的创新同样不可忽视。例如,应用“数据投毒”技术即成为保护原创内容的有效方式。该方法通过向公开数据添加特殊“信号”污染模型训练数据,使未经授权的AI模型无法有效利用这些内容。这种保护机制不仅降低了他人盗用用户数据的风险,也促使人工智能企业更多遵守规则与版权边界。

作为内容平台的运营方,如若能推广这样的技术应用,无疑能够构建更完善的数据保护生态,体现对用户权益的尊重。 与此同时,行业内部以及立法层面也需大力推动教育与规范,提升从业人员对同意和隐私保护的认识。开发者和设计师应深刻理解“同意”背后的伦理意义,在产品设计中摒弃任何形式的强制默认或暗示用户同意的做法。监管机构则应完善相关法规,对违反用户隐私权的行为设置明确、严厉的处罚,确保各方自觉遵守。公众应当提高警觉性,积极学习隐私保护知识,勇于行使自身的知情权和选择权,共同营造一个尊重个体隐私的数字环境。 总的来说,科技行业对用户同意的误解是当前数字时代隐私危机的缩影,其影响深远且令人担忧。

自动选择退出机制的滥用和设计暗黑模式的普及,使多数用户处于被动甚至无知状态,个人的隐私自主权受到严重侵蚀。这不仅损害了用户权益,也最终威胁行业的可持续发展。科技企业必须彻底革新同意获取和数据管理的方式,拥抱主动选择进入,细化权限控制,采用创新技术保护原创内容,同时积极响应法律法规和社会道德的呼声。只有这样,才能真正实现科技发展与用户权益保护的双赢,推动数字社会迈向更加公平、透明与人性化的未来。