随着人工智能技术的飞速发展,越来越多的软件开发者开始借助AI工具来辅助编写代码。这些工具从简单的代码补全到复杂的功能实现,极大地提高了开发效率。在这样的背景下,一个重要且引人深思的问题浮出水面:是否应该在Git的代码提交中将AI列为联合作者?这一问题不仅涉及技术层面,更触及软件开发的伦理、透明度及责任归属等核心问题。传统上,开发者在代码注释或提交信息中会标明引用来源或者协作者,目的在于维护代码历史的清晰和完整性。随着AI的加入,代码生成过程变得更加复杂。AI并非完全的工具,它在某些情境下具备创造性,为开发带来实际贡献,因此是不是应当给予"作者"身份呢?探讨这一话题,需要先从透明性谈起。

透明性是任何协作开发的重要基石。它帮助团队成员和未来维护者了解代码的来源和背景,能有效预防误解和潜在的问题。正如开发者标注从网络资源借鉴的代码,AI所生成的重要代码片段同样值得公开透明。未明确标识AI贡献,容易使后续团队成员对代码的意图和潜在风险一无所知。尽管AI的代码看似规范,实际上可能存在逻辑漏洞或者对特定场景的盲区,明确标识能让维护者保持警觉,进行更加细致的审查。另一方面,AI并非是完全独立的实体,更非具备法律人格的创作者。

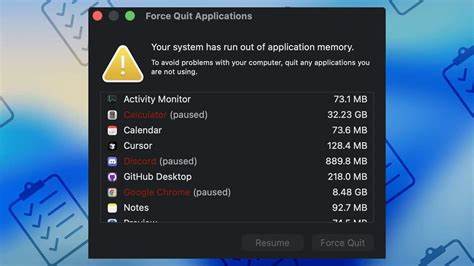

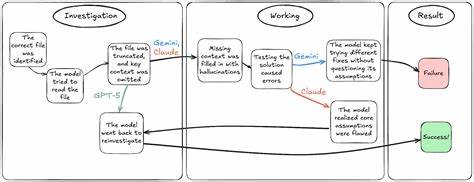

因此,标注AI为联合作者在法律和责任角度尚有争议。开发者依旧需要对AI生成的代码负最终责任,AI不能被免除代码缺陷导致的后果。然而,承认AI对代码的贡献,并非意味着放弃人类开发者的责任,而是在促进代码历史的真实反映。智能编程助手如Claude Code曾在提交信息中自动添加自己为联合作者,引起了社区热议。一部分开发者认为这种做法有助于代码溯源与合作透明,另一部分则认为这是"噪音"或不必要的冗余。实际上,区分AI的贡献程度非常关键。

AI参与微小的自动补全或简单语法修正时,根本无需特别标注,但当AI生成完整函数、实现核心算法逻辑或构建大量代码块时,就应当被视为实质贡献者并加以认可。设立合理的判定标准,有助于在保持工作效率的同时,避免无谓的过度标注。采用清晰明确的标签或"Co-Authored-By"格式能很好地平衡这两者。标注AI贡献不仅是一种诚实守信的行为,更是对未来代码质量保障的实际举措。AI生成的代码往往带有一定不确定性,可能遗漏边界情况或含有不适合项目语境的假设。通过透明的注释和标签,提醒维护者需特别关注相关代码,促进更严格的质量检查。

随着AI时代的到来,软件开发的协作模式与责任体系也在发生深刻变化。开发者需要主动适应这一转变,建立将AI视为"协作者"的良好习惯和规范。但这并不意味着抵消人类开发者主导的核心地位,而是在实际操作中为科技进步所带来的新贡献形式赋予合理的身份标识。部分反对声音认为,AI仅是工具的一种扩展,类似于编译器或调试器,过分强调其身份只会增加繁琐。但这种观点忽视了AI在创造性工作中的角色变化。现代AI不仅完成简单重复任务,更能基于上下文自主构思代码结构和方案,体现出某种程度的"智能"行为。

正如引用技术博客或公开资源一样,这类贡献值得正式认可。责任归属的讨论同样关键。明确标注AI贡献并不意味着放弃开发者应对最终代码质量负责的立场。相反,这种双重认知能强化审查和测试流程,促使开发者更加谨慎地审视AI生成的内容。对于团队管理层来说,公开透明的AI使用记录也有助于风险管控和知识管理。在一些应用场景下,AI贡献极为显著,甚至生成了核心业务逻辑代码。

这时,标注AI为联合作者是对事实的恰当反映,也有助于团队成员准确评估代码的维护成本和潜在风险。技术社区正逐渐形成关于AI代码归属的共识。虽然尚无统一标准,但倡导透明和责任并重已成为主流趋势。一些开发者在个人项目中采用了多种实践,比如在Git提交信息中加入"Co-Authored-By: Claude <noreply@anthropic.com>"或添加"[AI]"标签,甚至在Pull Request描述里专门增加"AI参与度"一栏,详细罗列各AI工具的贡献内容。推动业界共同建立明确的AI贡献记录规范,有助于减少争议,提升代码管理水平。展望未来,随着AI智能化程度提升及更多自主编码工具的出现,代码"作者"身份的定义和边界势必更加模糊。

人类开发者应对自身责任保持清醒认识,同时也要合理接纳AI带来的新协作形式。通过规范化的标注和合理的责任分配,软件开发能够实现更加健康可信的生态环境。总结来看,是否将AI列为Git提交的联合作者,关键在于认识AI在代码创作中的实质性贡献,以及对团队协作透明度和责任归属的坚持。合理标注AI参与不仅维护了技术伦理,也促进代码质量的可持续发展。面对这场正在展开的软件开发范式变革,作为开发者,我们应当主动拥抱透明与规范,推动构建一个更为诚信与合作的数字未来。 。