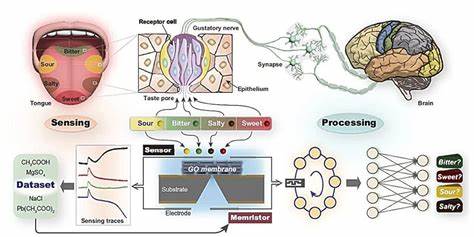

大型语言模型(Large Language Models,简称LLMs)作为人工智能领域的重要技术,凭借其强大的自然语言理解与生成能力,正在不断改变各行各业的工作方式。尤其在政府领域,随着数字化转型的加速推进,LLMs拥有巨大的潜力,可以帮助政府部门高效处理和分析海量文本数据,辅助政策制定与公众服务优化。然而,政府机构所涉数据多为高度敏感且涉及隐私保护,如何在确保数据安全的基础上合理利用大型语言模型,成为当前亟需解决的关键问题。本文将深入探讨政府如何通过安全的自托管技术实现大型语言模型的应用,同时分析其面临的挑战与未来发展趋势。 大型语言模型的独特价值在于其能够理解并生成接近人类水平的语言,支持自动化文档总结、信息抽取、数据结构化处理,甚至辅助代码生成等复杂任务。对于政府部门来说,这意味着能显著提升文档处理效率,比如在贸易协议条款、政策咨询反馈以及议会辩论记录等领域实现快速分析和洞察挖掘。

这不仅节约了大量人力成本,也为决策层提供更为及时和深入的数据支持。 传统上,许多机构使用的LLMs多依赖第三方云服务,诸如ChatGPT等公共平台,虽然方便且功能丰富,但不可避免地涉及数据跨境传输及存储,极易带来数据泄露和隐私风险。政府部门处理的信息往往包括商业机密、个人隐私乃至国家安全相关内容,数据外泄不仅影响公共利益,更可能引发法律和伦理问题。因此,保障数据主权和安全,成为推动政府部门采用自主部署技术的重要驱动力。 自托管大型语言模型的核心优势在于所有数据和计算资源均在内部网络环境中运行,与公共互联网隔离。通过构建私有云或利用专属虚拟私有云(VPC),政府能够严格限制模型访问权限,确保敏感数据不会被外泄。

同时,自托管架构为定制化模型优化和特定场景调优提供了空间,使得LLMs更贴近部门实际需求,提升应用效果。 以英国商务与贸易部(DBT)为例,该部门通过在AWS SageMaker平台内搭建自托管大型语言模型,成功实现了GPU资源加速计算,并在其隔离的Data Workspace环境中安全运行。Data Workspace通过网络隔离和权限管理,保证了所有数据只能在批准用户之间流动,极大降低了安全风险。通过内部开发的Python工具包,用户可以直接在安全环境中便捷调用模型,显著提升了操作体验和工作效率。 这种模式还带来了成本优化和资源共享的优势。大型语言模型运行对硬件设备要求极高,尤其是GPU计算资源价格不菲。

通过集中管理和多项目共享,避免了资源浪费,提升了投资回报率。与此同时,团队还在持续探索性能与成本的平衡,比如尝试将部分任务转移至计算能力较低的实例上,以减缓整体开支压力。 用户需求驱动了模型选择和功能迭代过程。DBT通过深入用户调研,确定了诸如主题建模、结构化数据提取、情感分析等关键应用场景,为模型部署提供了明确方向。同时,也通过不断反馈机制,将产品持续优化以满足日益多样化和复杂化的需求。 面临的挑战主要包括技术复杂度、运维成本以及合规监管。

大型语言模型在训练与推理阶段都需大量计算资源,维护其稳定运行需要专业技术团队。此外,模型选择、版本管理及安全监控都需系统化、规范化管理。法规层面,数据隐私保护要求日益严格,政府必须确保在技术实施中充分遵守相关法律法规,避免合规风险。 未来,自托管大型语言模型在政府的应用前景广阔。随着硬件性能不断提升及开源AI生态的发展,部署门槛有望进一步降低,更多政府部门将能够利用此类技术提升行政效率和公共服务质量。同时,围绕模型透明度、偏见控制及伦理合理使用的问题也将成为关注重点,推动建立完善的责任机制和标准体系。

综合来看,政府中的安全自托管大型语言模型应用是数字时代智能化治理的重要方向。通过技术与安全并重的策略,政府不仅能够有效利用人工智能带来的变革红利,还能切实保障公众利益和国家安全。持续推进技术创新与用户需求的深度结合,将为实现智慧政府、数字主权和公共服务现代化奠定坚实基础。