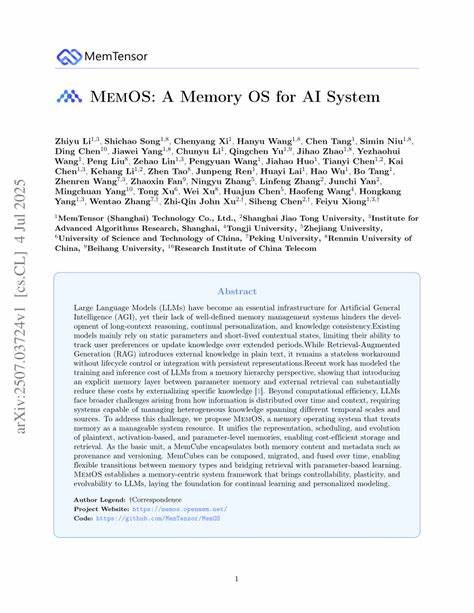

随着人工智能技术的高速发展,尤其是大型语言模型(LLM)的兴起,AI系统在理解和生成复杂语言内容方面展现出前所未有的能力。然而,尽管这些模型在自然语言处理领域取得诸多突破,它们在记忆管理方面存在的不足,成为制约其能力发挥的一大瓶颈。传统的模型主要依赖静态参数和短时上下文状态,无法高效支撑长时间的推理、持续的个性化学习以及动态的知识更新。面临这一挑战,MemOS的出现为人工智能内存管理带来了创新性的解决方案。MemOS是专为人工智能系统设计的记忆操作系统,它打破了既有模式,将内存视为可管理的系统资源,从而实现了内存的统一表示、调度和演进。众所周知,内存管理在计算机系统中扮演着关键角色,而在AI领域,尤其是大型语言模型的训练与推理阶段,合理管理内存直接关系到模型效率与智能水平。

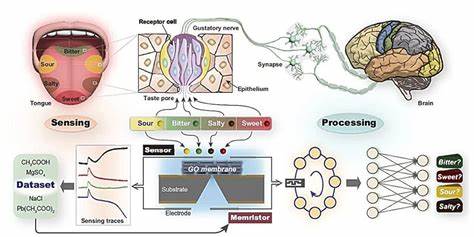

传统方法如检索增强生成(RAG)采用外部文本知识辅助生成过程,虽提高了信息丰富度,但仍表现为无状态、缺乏生命周期控制的策略,不能充分满足知识持续更新和个性化需求。MemOS引入了新的内存层次架构,介于参数记忆与外部检索之间,灵活外化特定知识,显著降低了训练和推理的成本。不仅如此,MemOS还解决了信息在时间与上下文维度上的分散问题,支持管理不同时间尺度与来源的异质知识。MemOS的核心单元是MemCube,一个集成了记忆内容与元数据(如来源和版本控制)的数据结构。MemCube支持组合、迁移和融合等操作,使其能够在不同类型的记忆之间自由转化,实现检索与基于参数的学习的无缝连接。这种设计赋予了系统更强的可控性、可塑性和可演化能力,为持续学习和个性化建模奠定了技术基础。

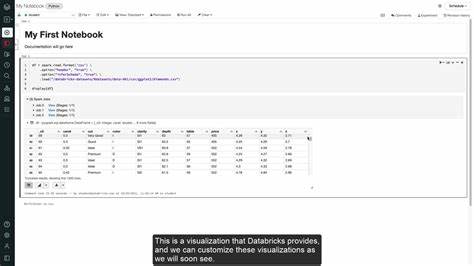

在实际应用中,MemOS通过统一的系统框架,优化内存数据的存储与调用效率,确保在面对海量知识与长上下文需求时保持高效响应。其生命周期管理功能帮助模型动态调整记忆内容,追踪知识来源和版本,避免信息冗余与遗失。同时,MemOS支持知识的自我演进,满足了人工智能系统在长期运行中对知识更新的需求。这带来的益处不仅体现在提升推理效率和准确率,还显著增强了模型对用户偏好的持续追踪与个性化适应。对于人工智能领域的研究者与开发者而言,MemOS提供了一个强大且灵活的平台,来探索内存的多维度管理方案。通过协同记忆内容与管理元数据,MemOS推动大型语言模型向着更智能、更自主的方向发展,解决了传统模型无法高效处理动态记忆的痛点。

未来,随着MemOS的不断完善与推广,人类与AI的交互将更加自然流畅,模型持续学习和适应环境的能力将得到质的飞跃。整体来看,MemOS方案的提出打破了AI内存管理的传统瓶颈,实现了记忆资源的系统化管理与优化。它不仅降低了模型的计算成本,还提升了模型的适应性和持续学习能力,助力人工智能系统更好地服务于各种实际场景和复杂任务。随着人工智能技术向更加复杂和多样化方向发展,MemOS的理念和技术架构无疑为业界提供了创新的内存解决方案,开启了AI记忆管理的新纪元。面对未来,MemOS也需要应对如何进一步兼容多模态数据、优化系统性能及增强隐私安全等挑战,但其核心思想和设计无疑将在人工智能内存体系建设中发挥重要作用。总结而言,MemOS作为一种专注于AI系统的记忆操作系统,通过创新的MemCube结构与统一的内存管理体系,不仅促进了大型语言模型的效率提升和智能化进程,也为实现真正意义上的持续学习和个性化AI打下坚实的基础。

随着技术的不断迭代与应用扩展,MemOS的出现标志着人工智能内存管理进入了一个崭新的发展阶段,其带来的深远影响将在未来智能技术的发展中持续显现。