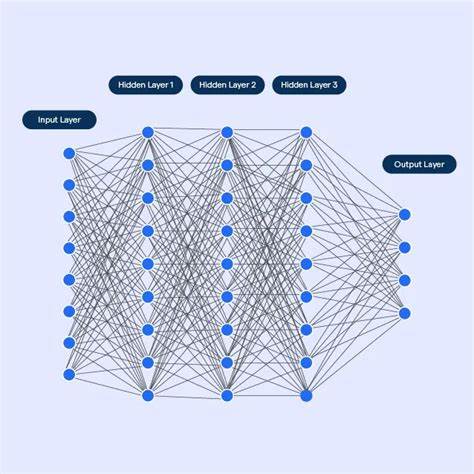

随着人工智能技术的飞速发展,深度神经网络(DNN)在图像识别、自然语言处理以及语音合成等多个领域展现出卓越的性能。然而,理解深层神经网络为何能够有效学习并泛化复杂任务,其背后的理论基础尤为关键。在这一理论体系中,模型复杂度作为衡量模型表达能力与泛化性能的重要参数,引起了越来越多研究者的关注。如何准确定义和量化深度神经网络的复杂度,成为推动该领域理论进步的核心问题之一。复杂度不是单纯的参数数量,往往涉及模型在拟合数据时所需编码信息量的深层含义。传统意义上的复杂度常用参数规模或网络层数衡量,但这无法覆盖神经网络真实学习到的底层结构信息。

近年来,信息论提供了重要工具,尤其是熵和Kolmogorov复杂度(描述一个对象最短描述程序长度的理论度量)为我们理解模型复杂度提供了数学视角。熵作为随机变量不确定性的测量,可以捕捉训练数据的本质随机性和结构。深度模型训练过程中的复杂度与训练数据本身的复杂度密切相关,模型试图学习训练集中的“有用结构”,而非噪声部分。在此语境下,模型的复杂度可被视作试图压缩训练数据的过程,其目标是找到既能概括普遍规律又不过拟合细节的最优表征,这与最小描述长度(Minimum Description Length,MDL)原则高度契合。MDL理论指出,最优模型应当是能够同时最小化模型本身的编码长度以及模型对数据的误差描述长度之和的模型。这意味着深度学习中的正则化方法与MDL理论实质上是在调节模型的复杂度,以避免过拟合。

复杂度理论还引入了“显式复杂度”(apparent complexity)概念,通过对模型或数据进行适当的“平滑”或“去噪”变换,将无用信息过滤,从而揭示隐藏的结构。神经网络在训练过程中,权重渐进调整相当于在隐空间中实现了这种平滑操作,学会了对数据潜在结构的编码与压缩。因此,可以将训练好的网络看作是一种自适应的复杂度压缩器。另一种重要视角是“精致度”(sophistication),它拆解数据为结构化信息与随机噪声的组合,但其计算难度极大,实用受限。尽管如此,其思想启发了针对复杂度的更可行近似方法,如结合数据压缩算法(gzip等)对训练数据和模型表达的编码长度进行估计,以近似衡量复杂度。通过模拟如“咖啡自动机”这类物理系统的演化,研究人员观察到复杂度在系统状态演变中呈现先升高后降低的趋势,反映现实世界中结构生成与破坏的过程。

此类研究为理解深度神经网络训练中模型复杂度的动态变化提供了启示。对于深度学习的实践者而言,复杂度理论指示模型不仅要关注误差最小化,还应同时考虑模型的描述长度与泛化能力。较低的复杂度往往意味着模型捕获了数据中更具普遍性的规律,不依赖过多细节噪声,其泛化性能更佳。复杂度测度的完善和实现有助于设计更高效的模型架构、优化训练策略及避免过拟合问题。进一步,当前复杂度理论还与变分自编码器(VAE)、扩散模型等生成模型的设计密切相关。VAE通过显式学习低维潜在空间,相当于构造了一个可控的平滑函数实现复杂度压缩;扩散模型以逆转熵增加为目标,隐含区分噪声与结构信息,拓展了复杂度理论在模型训练中的应用场景。

展望未来,深度神经网络的复杂度研究将结合更多新兴理论,如图神经网络的结构复杂度评估、多模态学习中的信息融合复杂度。模型复杂度不仅关乎模型性能,也直接关联训练资源消耗、模型解释能力与安全性等方面。掌握复杂度的理论解析,有助于在数据资源有限情况下,科学评估模型的学习极限与创新空间,指导模型规模和数据量的有效匹配,避免所谓的数据“墙”。此外,复杂度理论促进对神经网络内部表征几何结构的认识,揭示不同训练阶段和任务下特征场景的复杂度变化规律。总之,建立健全的深度神经网络模型复杂度理论,不仅强化了机器学习方法的理论基础,也为人工智能算法的可控性、可解释性及可持续发展奠定坚实基石。对于推动人工智能从经验驱动向原理驱动转变,理解和应用模型复杂度理论具有不可替代的战略意义。

未来科研工作中,结合信息论、统计学习理论以及实际应用需求,不断精进模型复杂度的度量方法和优化策略,将助力开发更强大、更高效、更安全的智能系统,引领人工智能迈向新的高度。