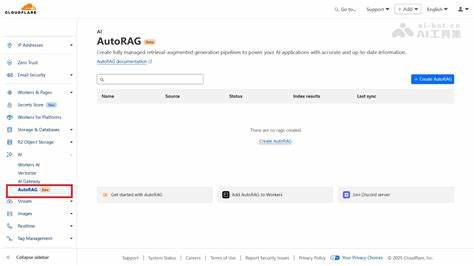

随着人工智能技术的飞速发展,检索增强生成(Retrieval Augmented Generation,简称RAG)作为一种融合检索与生成的先进技术,正逐渐成为智能问答和知识管理领域的关键利器。Cloudflare作为全球领先的互联网基础设施公司,最近推出了AutoRAG产品,旨在简化RAG应用的搭建流程,同时提供灵活且高效的检索与生成接口。本文将基于实测体验,全面解析AutoRAG的设计理念、核心功能及其面临的挑战,助力读者深入理解这项技术的实际价值和应用前景。AutoRAG的设计初衷显然是降低用户进入门槛,使得开发者和企业能够快捷地在自有数据上构建智能问答系统。该平台目前支持两种嵌入模型:baai/bge-large-en-v1.5面向纯英文文本,适合对英语语境要求严格的应用,而baai/bge-m3则支持多语言环境,增强了跨语言检索的多样性和灵活性。尽管可选方案较为有限,AutoRAG的嵌入模型在精准捕捉文本语义上下功夫,确保了语义匹配的基本质量。

关于检索机制,AutoRAG采用余弦距离进行相似度匹配,这是目前业界广泛接受且性能较为平衡的向量相似性度量方法。尽管当前版本未开放更多匹配算法选项,但平台提供了四种相似度搜索级别供用户选择,涵盖从极为精准的“Exact”到“Loose”的宽松匹配,满足不同业务对召回率和准确率的个性化需求。此外,系统允许用户调整文档切分的参数——包括分块大小和重叠率,预置的默认设置兼顾了性能和上下文连贯性,为后续的生成模型提供了丰富且相关的检索基础。值得关注的是,Cloudflare的AI网关产品融合进AutoRAG体系,能够将生成请求智能路由至包括Gemini、OpenAI、Anthropic、Mistral等顶尖大语言模型服务商。尽管目前生成调用主要集中在LLama模型,默认使用的是LLama 3.3 70B版本,业内人士建议更优选项如Gemini 27B可能带来更佳的性能体验。AI网关的加入不仅提升了模型调用的灵活性,更增强了日志可视化和调试能力,用户可以实时监控上下文和提示词,极大提升了开发和迭代效率。

AutoRAG还配置了查询重写功能,试图从用户原始问题中提炼核心意图,优化检索上下文的相关性,尽管当前该功能响应速度较慢,约1.7秒,但体现了Cloudflare对提升自然语言理解的持续投入。在数据管理方面,AutoRAG与Cloudflare的R2存储深度整合,用户只需将新增数据上传至R2桶,系统便能自动索引并纳入检索框架,极大简化了数据更新周期。这种自动化索引机制确保了系统具备高度的扩展性和动态适应能力,是构建实时知识库的理想选择。然而,产品仍处于beta阶段,存在一些明显的限制和瑕疵。例如,必须在创建AutoRAG实例前预先向R2上传数据,否则服务无法正常运行;缺少针对提示词的优化机制,限制了生成内容的定制程度;部分功能存在BUG影响用户体验。最为关键的是当前的检索表现虽有一定基础,但在面对复杂或领域专属问题时准确率仍有待提升。

这反映了当前检索增强生成技术在通用化和专用化之间的平衡难题,尤其是当数据集规模较小且内容公开时,RAG系统面临较大挑战。基于作者以往对巴菲特和查理·芒格公开数据的RAG应用经验,AutoRAG所返回答案整体符合预期,但检索的精确度和相关性表现仍需优化。本文作者通过多轮提问验证了系统的问答能力,包括投资理由、投资建议以及特定概念解释,发现生成回答信息丰富且逻辑清晰,但底层检索机制在返回最佳上下文方面表现不够理想。此种体验也反映出检索技术固有的领域依赖性,有利于专业领域的深度训练,却难以做到广域通用。对于企业和个人用户而言,AutoRAG尤其适合用作验证RAG概念和检测数据集价值的实验平台。当用户在单纯基于提示词的生成技术达不到期望结果时,部署AutoRAG可作为快速测试工具,判断数据驱动的检索增强是否确实能带来提升。

此外,该平台对业务迭代、市场调研和原型开发均具备极大价值,可以实现低成本高效率的产品试验。展望未来,AutoRAG若能引入更加多样化的检索算法,例如经典的BM25或引入重新排序机制,将极大地提升检索质量和系统响应速度。作者特别指出,尽管重新排序模型现阶段增加了系统延迟和成本,但随着前沿AI语言模型不断进步(尤其是预计2026年后如GPT-4.1那样具有精准“针尖”检索能力的模型上线),部分传统重排技术或许将逐渐边缘化,市场格局或有颠覆。此外,功能方面如可自定义检索规则,例如根据数据类型(新闻、公告等)控制上下文多样性,避免单一数据源信息过量填充,有助优化答案的综合性和准确度。整体看,Cloudflare AutoRAG秉承了Cloudflare一贯的“无服务器”理念,通过预设合理默认和简化操作细节,使技术门槛显著降低,用户无需深厚背景即可快速部署有效的RAG应用。对于寻求快速上市和敏捷迭代的公司来说,AutoRAG提供了极具吸引力的工具链,尽管目前更适合探索性原型开发而非大规模生产级环境。

Cloudflare的AI网关和Vectorise产品展现了更为广阔的发展空间,或将在未来成为构建智能AI生态系统的核心支柱,值得持续关注。最后,作者回顾了自己半年前设计的15个聊天提示案例,当时传统生成模型如ChatGPT失败率较高,而自家定制RAG系统表现更优。经过6个月的技术演进,ChatGPT的成功率大幅提升,部分特定应用场景下传统RAG的必要性面临质疑。作者断言,随着基础大模型的持续能力增强,非专属或公开数据集驱动的RAG模式价值或将逐渐减弱,但对于拥有独特私有数据资源的企业而言,RAG依然具有不可替代的意义。综上所述,Cloudflare AutoRAG作为检索增强生成领域的新兴产品,展示了较强的技术整合能力和良好的生态适配性。它既为开发者提供了快速构建智能问答系统的实验工具,也为内容管理和业务智能化转型提供了潜在助力。

未来,随着产品不断完善和功能拓展,AutoRAG可望在企业级智能问答和知识检索中占据重要位置,带来更高效、更智能的用户体验。