在当今人工智能高速发展的时代,自然语言处理技术成为推动智能应用的重要引擎。Google推出的EmbeddingGemma作为一种强大的嵌入模型,在文本理解、搜索优化和推荐系统等领域表现优异。如何针对特定任务有效微调EmbeddingGemma,成为提升模型性能的关键所在。本文将深入探讨微调EmbeddingGemma的核心方法和实用技巧,帮助开发者和研究者更好地驾驭这一技术。 首先,了解EmbeddingGemma的基本架构和优势至关重要。EmbeddingGemma基于最新的深度学习技术,利用庞大的语料库训练,实现对文本语义的高维度表达。

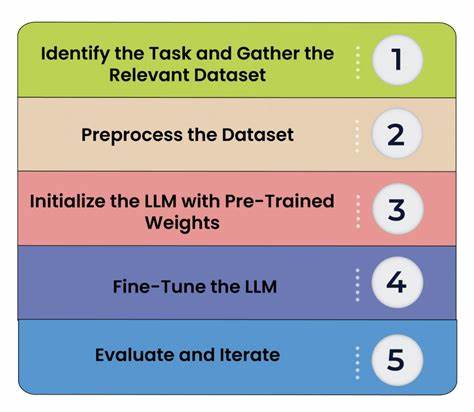

相比传统的词向量模型,EmbeddingGemma能够捕捉更复杂的上下文信息,适用于更多样化的应用场景。因此,在微调过程中,合理利用其预训练权重充分挖掘模型潜力成为重中之重。 微调的第一步是明确目标任务及其数据特征。不同的自然语言处理任务,如文本分类、情感分析或信息检索,对模型关注的文本特征存在差异。针对目标任务收集高质量的标注数据,是确保微调效果的基础。数据应具有代表性,同时涵盖多样的文本风格和表达方式,以提升模型的泛化能力。

接着,构建适合EmbeddingGemma的微调环境需要选择合适的软件框架和硬件支持。常用的深度学习库如TensorFlow和PyTorch均支持加载Google的预训练模型,开发者应根据项目需求和自身技术栈做出选择。硬件方面,配备高性能GPU可以加速模型的训练过程,提高实验效率。 实际微调过程需要设置合理的训练参数,包括学习率、批量大小和训练轮数等。EmbeddingGemma由于预训练规模庞大,建议采用较小的学习率以避免破坏已有的权重结构。采用分阶段训练策略也是提升微调效果的有效手段,先冻结部分层进行浅层训练,再逐步解冻进行深层优化,能够防止过拟合并提升模型稳定性。

数据增强同样在微调中发挥重要作用。通过对文本进行同义替换、随机删除或添加噪声等操作,扩展训练数据集,可以增加模型的鲁棒性。这种方法尤其适合样本量有限的场景,帮助模型更好地适应多样化的文本输入。 此外,结合迁移学习思想,将EmbeddingGemma与其他预训练模型进行联合微调,能够进一步提升效果。比如结合语言模型和任务特定模型的优势,实现信息的互补与共享,从而提升模型在复杂任务中的表现。 在实际应用中,评估微调成果离不开合适的度量指标。

根据任务性质,选择准确率、召回率、F1分数或语义相似度等指标,系统地衡量模型性能。持续跟踪模型在验证集和测试集上的表现,对于发现潜在问题和持续优化至关重要。 最后,模型部署与维护同样重要。将微调后的EmbeddingGemma集成到生产环境中,需要保证模型响应速度和资源消耗的平衡。同时,应建立监控机制,及时捕获模型偏差和性能波动,安排定期重新微调以应对数据分布变化,确保模型长期有效运行。 综上所述,微调Google的EmbeddingGemma模型是一个系统工程,涵盖数据准备、训练参数调整、策略设计、性能评估及部署维护多个环节。

掌握这些关键环节和实践经验,不仅能够充分发挥EmbeddingGemma的优势,还能够提升各类自然语言处理任务的智能化水平,推动相关应用的创新与发展。随着技术的不断迭代,持续关注前沿研究和工具更新,也将助力开发者更好地应对未来挑战,打造更智能、更高效的语言理解系统。 。