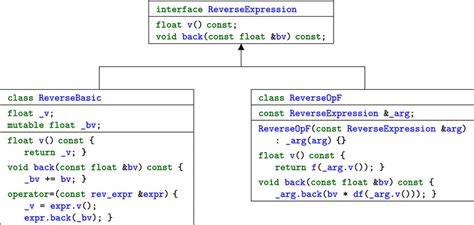

自动微分(Automatic Differentiation,简称AD)作为计算梯度的核心技术,在机器学习、科学计算以及优化算法中应用广泛。它能够精确计算复合函数的导数,帮助模型训练和优化过程更加高效。在自动微分的实现方式里,反向模式(reverse mode)和正向模式(forward mode)是最常见的两种策略。本文基于C语言环境,深入分析了反向自动微分与向量化正向自动微分的性能表现,重点探讨两者的内存管理、算法效率以及实现细节的差异,进一步揭示了性能瓶颈的本质以及优化路径。反向自动微分被广泛认为是多输入单输出问题的最优选择,尤其适合机器学习模型的训练过程。它的核心思想是在函数执行过程中记录中间变量的计算流程(通常称作"tape"记录),进而利用链式法则反向传播梯度。

尽管这种模式在理论上拥有算法效率优势,但其在实际运行中容易遭遇内存分配频繁和指针间接访问带来的开销,导致性能瓶颈。相比之下,向量化正向自动微分则采用一次执行传递完整梯度向量的方式,在每个中间节点存储梯度信息,适合小规模梯度的高效计算。作者采用结构体形式实现了{float value, float grad[GRADLEN]}的设计,在单次遍历中完成所有梯度的传播。通过将这一设计应用于多项式拟合问题,结合C++语言底层优化能力,得到了直观且有实用价值的性能对比结果。实验以拟合指数函数exp(1/x²)为目标,利用梯度下降法优化多项式系数,衡量不同梯度维度下两种自动微分技术的执行时间。实验在搭载苹果M2芯片的MacBook Air上进行,编译参数采用clang -O2优化级别,确保生成高效的汇编代码,同时验证了SIMD(单指令多数据)指令的应用情况。

结果显示,向量化正向自动微分在处理梯度维度小于120~150的情况下性能优于反向自动微分。这是因为此时向量化设计能够充分利用缓存,加速梯度计算流程。然而,随着梯度规模扩大至280维度以上,向量化正向模式的性能骤降,主要原因在于每个中间节点携带的完整梯度向量造成缓存在L1和L2级别的频繁缺失,内存访问瓶颈显现。为了缓解这一问题,作者提出了"分块向量化"策略,即将完整梯度向量分割成多个子块,每次只计算长度为α的梯度子集。这一方法虽然导致函数值的重复计算,但显著提升了缓存局部性,减少了内存带宽压力。通过调节分块参数α,实验发现α约为64时表现最佳。

改进后的分块向量化向前自动微分相较于单块版本性能大幅提升,特别是在超过数百维度梯度计算时仍保持较好的运行速度。尽管在梯度尺寸达到500维时仍落后于反向自动微分约2倍,但其作为可行方案的优势逐渐显现。作者还尝试利用pthread多线程对分块向量化正向自动微分进行并行加速,但未获得明显性能提升。推测原因可能为线程间共享缓存导致的竞争或同步开销,以及实现层面的不足。整体来看,本文提供的实验结论明确表明,在低到中等维度梯度计算任务中,向量化正向自动微分具备竞争力,尤其在缓存管理和内存访问优化方面具有潜力。反向自动微分依然在大规模梯度计算与多输入情景下保持优越性能。

重要的是,实验结果具有一定局限性,来源于单一硬件平台和特定优化算法,无法直接推广到所有环境。因此未来工作可扩展到多样化硬件架构、不同应用场景,结合真实AD库进行综合性能评估。文章也引用了相关资源,包括Charles C. Margossian关于自动微分实现的论文、面向GPU的高效自动微分实现、机器学习领域内的AD综述以及适用于SIMD架构的向量化自动微分技术研究。总体而言,本次性能探索不仅拓宽了开发者对自动微分技术局限性的认识,也凸显了缓存优化在高性能数值计算中的关键影响。对于追求极致性能的科学计算工程师和机器学习研究人员,合理选择和优化自动微分模式将成为推动模型训练与工程实现效率提升的重要手段。随着硬件架构的不断进化和AD算法的持续创新,未来自动微分的性能潜力仍有广阔的开发空间和优化契机。

。