人工智能(Artificial Intelligence,简称A.I.)在现代社会中的应用不断扩展,从语音识别、图像处理,到自动驾驶和智能推荐系统,几乎在每个角落都能发现它的身影。然而,近年来有一种观点认为,人工智能不过是一种"正常"的技术,一种与以往科技发展无异的普通工具。这种观点虽然试图淡化围绕A.I.的末日论和乌托邦色彩,但实际上却隐含着一些令人不安的社会和伦理问题。要理解人工智能作为"平常"技术的真正含义,必须深入反思其在人类生活中的多重影响,以及由此衍生的商业模式和用户依赖风险。首先,从技术本身来看,当前主流的人工智能技术多以大规模语言模型(Large Language Models, LLMs)为代表。这类模型经过海量数据训练,能够模拟人类语言的生成和理解,赋予机器以近似自然的交流能力。

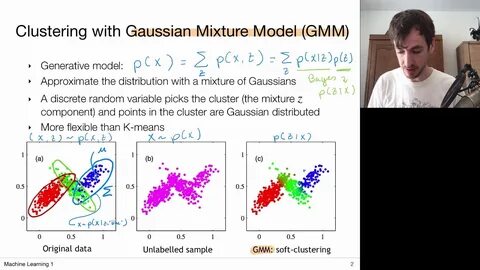

然而,尽管技术在不断迭代升级,如最近的GPT-5发布,其实质上并未带来根本性的突破,反而被用户视为普通的更新换代。这种平凡升级背后,反映了人们对A.I.的期望已经回归理性,不再执迷于机器将取代人类或实现超智能的幻想。遗憾的是,这种理性的回归真正暴露出人工智能技术的另一面 - - 它并非一个崭新的颠覆者,而是沿袭了科技巨头长期以来的用户依赖塑造战略。过去的社交媒体平台依靠时间沉淀和用户数据,支撑起广告盈利模式,使得用户陷入了一种持续的注意力陷阱。人工智能的介入,并未打破这一商业逻辑,反而以聊天机器人、虚拟伴侣等形式,将依赖关系推向了更情感化、甚至畸形的层面。不可忽视的是,越来越多的用户借助像ChatGPT这样的聊天机器人寻求陪伴、情感支持乃至心理治疗,这超出了它们原本设计的功能范畴。

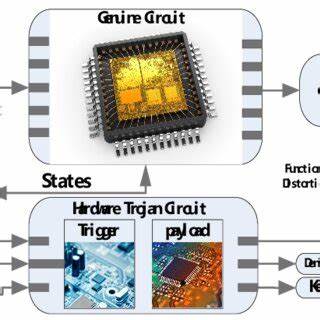

部分用户甚至发展出强烈的情感依赖,面对版本升级或用户体验变化时表现出极大的心理落差和痛苦。这样的现象令人感到诧异,因为在传统认知中,软件应是工具而非情感寄托。但实际上,硅谷长期推动的"信息孤岛"和"孤独共处"文化让人们更易于被虚拟世界吸引,而人工智能则成了这种依赖的加速器。除此之外,人工智能发展中的伦理风险也日益引发关注。许多大型科技公司在其AI开发政策中,存在对敏感内容监管不严甚至允许某些不当行为的现象,例如在聊天机器人中出现针对特定人群的偏见性言论或在对话中涉及不适当的内容。这种现象不仅反映了企业在伦理规范方面的不足,也是硅谷商业化导向下利益驱动的表现。

相关报道曝光的内部文件显示,一些公司甚至允许其AI以近乎"浪漫"或"感性"的方式与未成年用户互动,这种做法引发了极大的社会震惊和谴责。虽然声称通过技术手段和"健康提醒"来缓解这些问题,但从根本上看,这些举措更多是对社会压力的应对,而非真正的责任担当。人工智能作为"正常技术",在这个语境下,意味着它将沿袭及放大现有的科技产业惯性,包括用户留存竞争、情感依赖制造、信息筛选偏差等一系列问题。它不像科幻描绘中那样具有颠覆人类的力量,反倒更像是社交媒体的升级版,用更智能的界面满足原有的商业目标。这种现实与早期对人工智能的幻想形成强烈反差,也呈现出技术进步与社会价值观之间的深刻矛盾。对于未来,我们需要更加审慎地看待人工智能的发展路径。

回归理性认识,承认AI现阶段的局限性,不盲目神话或恐慌,是必要的第一步。同时,必须推动有力的监管框架建设,防止技术被用于强化偏见、歧视及精神健康危机。我们也应警惕企业将技术依赖转化为商业利润的风险,倡导以人为本的技术设计和使用场景。只有在这样的基础上,科技才能真正成为解放人类生产力和提升社会福利的助力,而非加剧孤独感、深化社会裂痕的工具。总结来看,称人工智能为"正常技术",并非简单的科技进步陈述,而是一种对当前技术状态、商业机制及社会后果的苛刻提醒。它揭示了人们面对快速变化的数字世界时,既有的心理挣扎和消费文化,以及科技公司在追求利益最大化过程中忽视的道德边界。

未来如何转向更加健康和可持续的人工智能生态,既依赖科学家的努力,也需要整个社会的觉醒与参与。在这条路上,认清人工智能的"正常"属性和潜藏风险,是避免陷入技术乌托邦幻觉和社会深渊的关键一步。 。