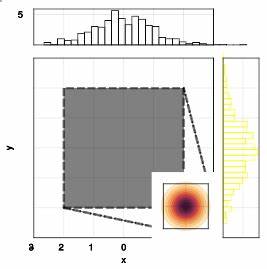

随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)的普及和应用,业内外对其性能表现的关注度日益增加。近期,关于"AI Nerf"现象的讨论逐渐升温,这一术语用来描述AI模型在某些任务上的性能下降或明显弱化,尤其是编码任务中的表现波动。本篇文章以丰富的连续评测数据为基础,深度解析这一现象背后的原因、现实影响以及未来发展趋势,旨在为行业从业者、研究者以及关注AI动态的公众提供权威而详尽的参考。人工智能模型的性能表现历来依赖于训练数据的质量、模型架构的创新以及后续的优化策略。然而,随着模型迭代和版本更新,一些使用者反馈出现了性能不及以往的现象。例如,Claude Code(Sonnet 4及4.5版本)在连续七天的编码任务评测中,表现出失败率波动的趋势,且某些时间段内较之前有明显上升,这意味着代码生成准确性有所下降。

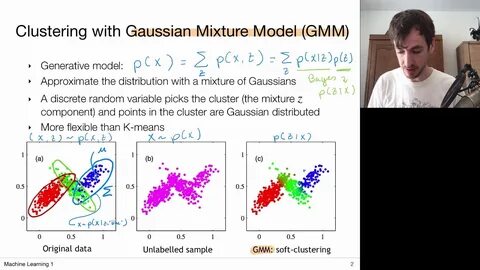

类似地,GPT-4.1在过去30天编程测试中的失败率也时有波动,虽总体保持稳定,但仍无法完全避免性能波动。这些数据并非偶然,而反映了当前AI模型在面对复杂、多变任务环境时的潜在瓶颈和挑战。造成AI Nerf现象的原因多种多样。首先,模型更新过程中可能加入了更加严格的安全和合规约束,限制了模型在生成内容时的自由度,导致某些任务执行效果受限。其次,训练数据的多样性和质量的变化亦会影响模型精度,特别是随着模型面向更多应用场景,必须在通用性与专业性之间寻找平衡。还有一方面,持续的技术优化可能引入新的架构调整或算法变化,从而产生短期的性能震荡。

对于使用者来说,AI Nerf现象带来的直接影响是任务完成效率和质量的下降,尤其是在依赖高准确率的代码生成、文本创作等领域。用户可能感受到响应不如预期,甚至出现错误率增高,进而影响决策和工作流程的稳定性。企业层面则需关注模型供应商的版本迭代日志和性能反馈机制,以便及时调整应用策略。面对AI Nerf,业界提出了多种应对思路。持续、细致的性能监测成为基础环节,通过诸如"IsItNerfed?"等平台的连续评测数据,开发者和用户能够实时掌握模型表现变化,发现潜在问题。与此同时,增强训练数据的多样性和针对性,提高模型自适应能力,也是缓解性能下滑的重要手段。

更长远来看,构建多模态、多任务和可解释的AI系统,有望提升模型的总体稳定性和鲁棒性。此外,加强行业监管和伦理审查,确保性能优化与安全合规之间的合理权衡,也成为未来发展的关键。值得关注的是,AI Nerf并非单一负面现象,而是AI技术成熟过程中的自然阶段。在不断扩大应用边界和解决更复杂问题的过程中,模型需不断调整和优化,这可能导致部分性能指标短期内波动。正确认知这一点,将帮助相关从业者更理性地看待模型升级和变化,避免过度担忧和误判。随着技术进步和算法创新,AI模型的抗扰动性和适应性将不断增强,未来或能有效减少性能波动,实现更为稳定和可靠的应用表现。

总体而言,人工智能"下滑"现象提醒我们,AI发展虽充满潜力,但依然面临技术复杂性和多维挑战。持续关注模型表现,多渠道收集反馈,并结合科学方法进行优化,是推动AI持续进步的必由之路。借助数据驱动的监控平台、积极探索前沿技术,配合合理的商业及政策环境,AI将迎来更为光明的发展前景。用户在实际应用中,也应保持动态观察态度,灵活调整策略,促进人与机器的协同进化,共同实现智能化工作的提升。未来,AI Nerf现象有望成为行业深度转型的"成长阵痛",而非永久性的性能障碍。通过精准识别问题根源,科学制定优化方案,人工智能将在保障安全合规的前提下,实现更高效、更智能的发展目标,充分释放其在经济、社会和科学领域的巨大潜力。

。