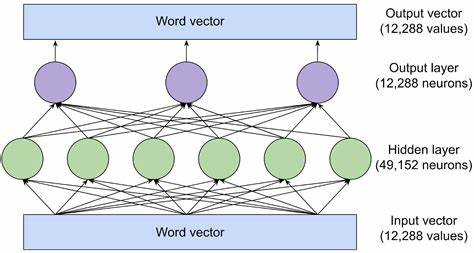

近年来,大型语言模型(Large Language Models,简称LLM)如OpenAI的GPT系列和Google的BERT等,因其卓越的自然语言处理能力和广泛的应用前景,受到了高度关注。随着技术的不断进步,许多人开始思考LLM背后的理论基础,尤其实用而且精确的统计学方法是否对于这些模型的设计、分析和改进不可或缺。本文将围绕“LLM是否真正需要统计学基础”这一问题展开深入探讨,结合最新学术研究和实际应用案例,揭示统计学对大型语言模型的重要价值。大型语言模型的本质是对大量文本数据进行建模与生成。它们通过训练海量的语料库,使用复杂的神经网络架构捕捉语言中的概率分布和语义关联。从这个角度来看,LLM天生就是一种统计模型。

其生成的文本具有显著的随机性和不确定性,而概率统计正是应对不确定性与变异性的强大工具。统计学的核心思想就是研究数据的规律与噪声之间的平衡,提供稳健的推断与预测方法,这与LLM在处理非结构化语言数据时的需求高度一致。另一方面,虽然很多大型语言模型凭借强大的计算能力和深度学习技术在实际任务中取得了令人瞩目的成绩,但它们的“黑箱”性质也引发了科学界和应用场景的关注。LLM通常规模庞大、结构复杂,参数众多,且训练过程高度依赖经验性的调参和算力支持。由于缺乏明确的理论解释和可解释性,这些模型在风险评估、可靠性保障及决策支持方面存在挑战。统计学提供的理论框架和方法正是解决这些问题的良方。

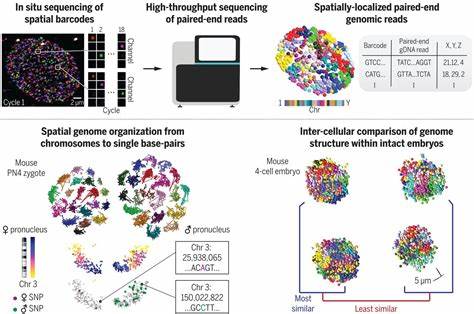

统计学强调模型的可解释性、变量选择、误差估计和模型验证,这些对理解和优化LLM至关重要。在具体研究方向上,统计学对大型语言模型的影响和贡献已经初见成效。例如在模型的对齐(alignment)问题上,统计学帮助研究人员设计合理的评价指标并量化模型与人类需求的契合程度。在水印技术(watermarking)的发展中,统计方法用以分析信息嵌入的可靠性和隐蔽性,增强模型生成内容的版权保护。在不确定性量化方面,统计学提供了系统性工具,帮助LLM衡量预测结果的置信度,提高模型在高风险领域的应用安全性。此外,评价指标的设计和多样化数据混合优化也依赖于统计学的原理与技术,推动了LLM的持续进步。

值得强调的是,预计未来统计学和大型语言模型的结合将不会是单一统一的理论体系,而更可能呈现多元化、交叉性的研究格局。统计学不是简单地为LLM提供单一方案,而是通过多角度、多层次的方法,构成一个“马赛克式”的知识体系,为模型的解释、优化和应用铺设坚实的基础。这样的理解鼓励统计学界尽早参与到LLM的研究和实践中,促进跨学科的合作创新。总的来看,大型语言模型的统计本质决定了统计学的理论和技术对其发展至关重要。统计学不仅帮助我们更好地理解和解释这些复杂模型,还在实际应用中提供了优化方案和风险控制手段。面对未来人工智能的发展,统计基础将成为推动大型语言模型向更高水平演进的重要动力。

从数据理解到模型评估,从生成安全到效果提升,统计学的价值不可替代。对于统计学界而言,积极投入到LLM相关研究中,不仅能拓展统计学的应用边界,也将助力人工智能技术实现更安全、更智能、更高效的愿景。