在2025年的技术环境里,CEO要求AI落地已成为常态,但如何在不让工程师反感的情况下推进AI采用,是每位工程经理必须面对的现实问题。成功的AI落地并非购买越多工具越好,而是把AI当作工程项目来组织:明确目标、选定试点、建立规则、测量效果并持续迭代。本文以实践经验为基础,提供一套可操作的路径,帮助工程团队实现可持续的AI采纳并证明ROI。 首先要理解,工程师反感AI的根源往往不是技术本身,而是糟糕的体验和无效的产出。随意把工具塞给团队只会引发阻力与反感。相反,赢家团队会把落地拆成明确的阶段,从代码编辑器开始,逐步延伸到自动化代理、AI驱动的代码审查和系统化的效果衡量,最终形成持续创新机制。

在选择AI代码编辑器时,应优先考虑对公司代码库与开发流程的适配性。市面上有多种工具,包括桌面编辑器插件与云端IDE辅助功能,建议先挑选两款进行对比试验,以便在真实项目中观察差异。让一支小规模的试点团队承担探索任务至关重要。理想的试点成员既要对新工具有好奇心,又要在团队中具有影响力,人员构成应兼顾不同业务线和资历层次,规模控制在三到五人可以获得多样反馈而又不致于协调过度。 试点阶段的重点并不是盲目攒使用次数,而是让AI"学会"团队的编码习惯。为此必须编写具体的规则文件,明确代码风格、安全约束和测试要求。

模糊的口号式规则会让AI给出千篇一律且不贴合团队实践的建议。有效的规则应该涵盖命名规范、类型声明、配置管理、安全处理、测试模版等细节,数量控制在十到十五条为宜,后续根据实际反馈持续补充与精炼。把规则看作是对AI的"工程师手册",让它把团队的隐性约定显性化。 与规则同等重要的是为AI提供工程上下文。Model Context Protocol(MCP)或类似机制能够把数据库、内部API、项目依赖等上下文暴露给AI,使其建议更贴近工程实际。为常用仓库配置远程MCP,使工具在理解大型第三方库或自研框架时不至于盲猜。

Context的丰富度直接决定AI在本地代码修改与PR建议时的有效性。 当试点验证结束并确认可行后,可以做有限范围的推广。推广节奏不宜过快,建议经过两个冲刺周期的alpha验证后再进行组织级 rollout。推广期间要结合定性访谈与定量日志,既要听取团队对体验的主观意见,也要观察真实使用数据来判断落地质量。 落地过程不能只靠一次培训,而要把内部知识传播制度化。让试点团队成为内部的AI讲师,开展小规模、场景化的实操演示,演练如何用AI修复实际缺陷、重构遗留模块或生成集成测试。

重点培养"上下文工程"能力,即如何为AI构建恰当的提示与背景,能极大提升工具效率并降低无用消耗。用例分享、提示库和专用Slack频道都是促成知识沉淀的有效手段。 在完成代码编辑器层面的应用后,可以引入背景代理来承担简单但重复的编码任务。背景代理能够自动提交PR或补丁,适合处理小规模修复、依赖升级与格式化等工作。允许非工程角色如产品或客服通过代理发起改动,可以释放工程师的重复劳动,但前提是为代理设定明确权限和审批流程。代理的成功取决于其环境和权限是否逼近工程师的真实工作场景,因此应与规则文件和MCP上下文一起配置,以提升正确率并降低审查成本。

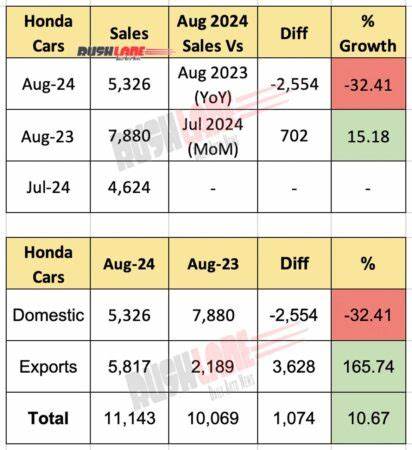

随着代理的加入,代码审查往往会成为新的瓶颈。AI并不能完全取代人工审查,但可以承担重复性检查,过滤显而易见的问题,让人工审查专注于架构设计、安全边界和复杂的逻辑判断。为AI审查器编写审查规则同样重要,它需要知道哪些风格问题必须拦截、哪些可以忽略,以及在审查意见中如何呈现改进建议,才能提高信任度并减少噪音。 衡量AI落地的效果比盲目看"使用量"更重要。许多团队把使用次数当成成功指标,但真正有意义的指标应当反映工程价值,包括采纳质量、生产力变化与代码质量。采纳质量可以从日活跃用户数、跨团队参与度和代理采纳率等维度观察。

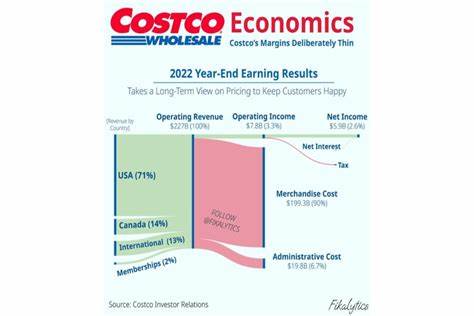

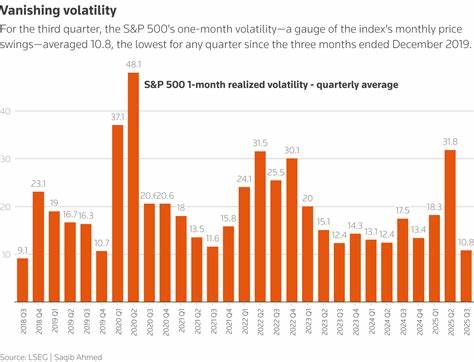

生产力层面的衡量要关注能否缩短从需求到首次提交的时间、代码审查周期是否缩短以及部署频率是否提高。质量层面的警戒信号包括PR回滚率上升、修复时间增加或代码在短期内被大量重写。 成本控制也是衡量的重要一环。跟踪AI工具的费用与工程节省之间的比值,可以用节约的工程小时乘以人力成本,再与工具开销做对比,得出初步ROI。关注代币消耗的分布能够识别出哪些团队或场景在低效使用工具,从而有方向地展开优化和培训。 建立测量体系的实用步骤是先选三项关键指标,一项反映采纳、一项反映生产力、一项反映质量。

先手工跟踪一个月以理解数据模式,再考虑用工具把分散的数据源(代码仓库、任务管理、AI使用日志)打通到一个可视看板。每月至少召开一次回顾会议,用趋势而非快照指导决策。 AI工具的生态更新迅速,短期内现在的最佳工具可能被新的平台取代。因此需要建立持续评估新工具的机制。指定专人或小团队定期扫描市场、做小规模评估并用统一的衡量标准对候选工具打分。评估频率要平衡探索与稳定,过于频繁会打乱团队节奏,过于保守则可能错失效率红利。

在选择新工具并准备推广时,仍需遵循已经验证的流程:选定试点、书写规则、配置上下文、测量效果、分阶段推广。不要把工程师当成被动的接受者,让他们参与工具评估与规则制定会显著提升采纳率。跨部门合作同样能带来意想不到的价值,比如为产品、设计和客户支持评估AI解决方案,工程团队的经验能够提升这些解决方案在生产环境中的可用性,也有助于建立组织内的AI文化。 最后要强调的是心态层面的调整。工程师并不讨厌AI,他们讨厌的是浪费时间和被迫承担低价值工作。把AI当成提高工程效率的工具而非替代者,明确AI的作用边界,并保障代码质量与工程师的判断权,能把抵触转化为拥护。

AI落地不是一次性工程,而是持续的工程化过程,需要规则、上下文、测量与反馈的闭环。 通过明确的试点策略、精细化的规则设定、充分的上下文接入、负责任的代理权限、以结果为导向的衡量体系以及持续的工具评估,工程经理可以在不牺牲团队体验的前提下实现AI带来的生产力提升。把落地当作一个可交付、可迭代的工程项目,通过数据和实践证明AI的价值,才能让团队真正从中受益并长期拥抱变革。 。