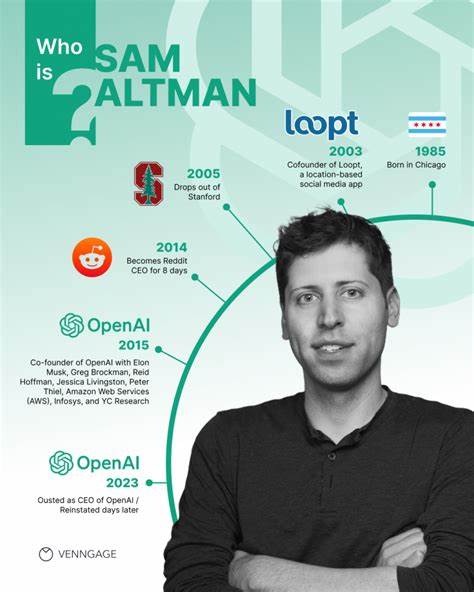

随着人工智能技术的飞速发展,全球范围内对于新型AI模型的安全性和伦理问题日益关注。作为OpenAI首席执行官的Sam Altman在新AI模型发布前被安排进入服务器机房的举动,引发了业内与公众的极大兴趣和讨论。这一看似简单的安排背后,实际反映出人工智能开发过程中对安全、风险控制以及责任感的深刻考量。本文将带您深入了解这一特殊举措的背景、意义及其对于人工智能产业的启示。 首先,什么是服务器机房?简单来说,服务器机房是集中存放计算机服务器、网络设备及相关硬件设施的专用空间。对于像OpenAI这样的大型人工智能研究机构来说,服务器机房不仅是AI模型运行的中枢,更是保障数据安全与计算稳定性的关键。

这些服务器承担着复杂模型的训练、推理任务,任何硬件故障、软件漏洞或安全问题都可能导致模型异常运行,甚至风险失控。 在传统的科技公司中,高管不常亲自接触底层服务器设备,但Sam Altman的做法显然不一样。在新AI模型正式发布前,他自愿进入服务器机房,体现了他对自身产品生态系统全方位掌控的决心。这样做不仅是一种象征,更是实质性地参与到关键技术核心之中,确保每一步检查无误,避免任何潜在风险。通过亲临服务器环境,Altman能够直接感知AI系统的运行状态,及时发现异常迹象,保证模型上线时的安全稳定。 这一安排还表达了对AI安全风险高度重视的态度。

众所周知,AI尤其是大型语言模型与生成式模型在发布后可能带来诸多风险,包括误导信息传播、伦理问题、甚至被不法分子利用。将负责人置于服务器机房,某种程度上显现了“安全关口”的概念,即确保项目领导者与核心技术环境紧密连接,第一时间应对突发事件。这样的举措也是一种责任体现,彰显了高层对AI产品安全的亲自把关,努力避免技术失控及其负面影响。 此外,这种行为还有助于增强团队的凝聚力和文化建设。人工智能开发往往需要跨领域的协作,从数据科学家、工程师到安全专家,每一个环节都至关重要。 当领域领导者亲身投入核心技术现场时,能够激励整个团队形成“安全第一”和“质量优先”的氛围。

团队成员会因此更加专注于细节,严格把关每一步流程,从而极大提升产品发布的成功率和安全保障水平。 深入解析,该行为还反映了当前AI领域越来越注重技术伦理与社会责任。随着人工智能影响力不断扩大,人们预计未来AI将更广泛地渗透医疗、金融、教育等关键领域,稍有不慎便可能引发严重后果。因此,从设计、开发到部署各阶段都必须恪守严谨标准,确保系统高度可控。Sam Altman的“进入服务器机房”不仅象征了技术层面的严谨,也隐含了对社会责任的担当。他实际参与加载、调试的过程正表明,AI不是一个抽象的产品,而是一个需要精心呵护和严密监管的复杂生态。

从技术角度看,服务器机房环境通常包含复杂的硬件设施和先进的管理系统,能够保障AI模型的高效率运行和数据完整性。Sam Altman作为领军人物,实际接触这些技术细节,能够更好理解系统瓶颈、潜在隐患和改进空间。这种从底层了解技术架构的做法,有助于推动AI研发路线更加务实和安全,有效避免因沟通障碍导致的产品风险。 同时,该做法也符合现代企业治理对风险管理的要求。在高风险的技术创新领域,领导层主动介入一线技术监控,有助于建立更快速、高效的风险响应机制。无论是发现安全漏洞,还是应对突发事件,领导团队的亲自把关均能显著提高决策效率和应变能力。

这种“领导深入风险点”的管理模式,体现出对新技术态势的全方位掌控,减少意外发生的概率。 值得一提的是,这一传统创新结合的做法还在业界形成了积极示范效应。越来越多AI公司开始关注核心数据中心安全,并通过设立明确的监控管理流程,将创始人或CEO与系统运维密切结合,形成完整的安全生态链。这不仅是一种安全实践,也是公司价值观的体现,致力于打造可信赖、负责任的人工智能产品。 未来,随着AI模型复杂度和规模不断提升,此类安全严控措施的必要性将更加凸显。技术领导者深入服务器环境实地体验,将成为保障AI健康发展的重要组成部分。

与此同时,公众和监管机构也将期待看到更多组织采用类似高标准的风险防控手段,促进人工智能产业迈向可持续、透明和安全的新阶段。 结语,Sam Altman在发布新AI模型前被安排进入服务器机房,远不只是一个奇特事件。它真实反映了当下人工智能领域对安全、责任、管理和技术理解的深刻追求。这种从领导层到技术核心的紧密联动体现了对未来AI发展方向的清晰思考和高度负责。对业界而言,这样的实践为提升AI安全保障树立了榜样,激励更多创新企业增强风险意识和执行力,携手构建更安全、更可信的智能新时代。