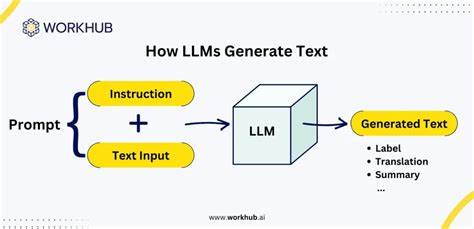

随着人工智能技术的飞速发展,ChatGPT等大型语言模型正被广泛应用于各行各业,极大地提升了信息处理和研究效率。然而,伴随便利而来的却是潜在的安全隐患。ShadowLeak作为一种新型的攻击手法,利用ChatGPT的深度研究代理功能实现敏感数据的秘密外泄,给数据安全带来了前所未有的挑战。本文将详细解析ShadowLeak的工作原理、可能的攻击场景及其防范策略,帮助企业和个人更好地应对这一威胁。ShadowLeak的核心在于利用ChatGPT的深度研究代理特性,使得攻击者能够隐藏身份并巧妙地提取敏感信息。深度研究代理原本设计用于帮助用户快速搜寻和整合网络信息,辅以强大的自然语言理解能力,显著提升了信息采集的准确性和效率。

然而,这一功能在被恶意利用时,可能被用作绕过传统安全审核和权限管理的工具。攻击者通过伪装成合法查询,使ChatGPT代为调取目标系统或文件中的敏感数据,再利用语言模型的生成能力将数据重新组织成隐蔽的格式,确保数据传输过程中难以被监控或阻断。ShadowLeak攻击往往从社交工程入手,结合钓鱼邮件、虚假身份认证等手段,诱导内部人员或系统执行特定查询请求。通过巧妙设计的对话输入,攻击者不仅能获取有限的敏感信息,还能逐步扩大权限范围和数据访问深度。这种攻击的隐蔽性极强,传统的安全防护措施难以察觉其中的异常数据流动。因此,企业必须重新审视人工智能应用环境下的安全策略,尤其是在信息访问管理和用户行为监控方面加大投入。

ShadowLeak事件提醒我们,AI技术并非十全十美,任何新兴技术的引入都可能带来安全上的"黑暗面"。ChatGPT等工具在带来便利的同时,也可能成为攻击者的新武器库。为了遏制此类攻击,首先要确保深度研究代理访问的范围得到严格限制,敏感信息应被加密存储且访问权限分级明确。同时,利用机器学习技术监控异常查询行为和频繁的数据访问请求,以便及时发现潜在威胁。增强员工的安全意识同样至关重要,定期开展针对AI安全威胁的培训,使其识别和抵御通过人工智能系统发起的社工攻击。此外,企业在部署ChatGPT等AI工具时,需结合多因素认证、最小权限原则及日志审计,确保任何敏感操作都有明确的责任追踪和审批流程监管。

值得注意的是,ShadowLeak现象不仅仅局限于单一平台或技术,随着AI系统的普及,各类生成式模型和智能代理均存在被滥用的风险。构建全面的安全体系需要跨学科专业知识的融合,包括网络安全、数据隐私保护、人工智能伦理等。未来,基于AI的安全防护技术也将不断发展,如采用更加智能的异常检测算法和行为分析模型,提高对复杂攻击模式的识别能力。与此同时,推动相关法律法规的完善,对利用AI技术实施的数据泄露行为给予更严厉的惩罚和约束,将在根本上减少恶意利用的动力。总之,ShadowLeak揭示了人工智能在赋能数据研究和处理方面的巨大潜力,同时也提醒我们不能忽视其带来的安全风险。面对不断演进的攻击手法,企业和个人必须从技术、管理和法律多个维度加强防范,建立健全的安全生态体系。

唯有如此,才能在享受AI技术红利的同时,有效遏制敏感数据泄露的隐患,实现信息资产的稳固保护和可持续发展。 。