计算复杂性作为计算机科学的核心领域,一直致力于理解算法执行过程中的时间与空间资源消耗。传统认知中,算法运行时间与其所需内存空间往往被认为近似相关,或至少不会出现大幅的差距。然而,2025年初,一项由数学家与计算机科学家Ryan Williams在STOC会议上发表的重大突破,彻底颠覆了这一观点,揭示了所有算法在其运行时间远大于所需内存空间的现象。这一新发现不仅是理论计算领域的里程碑,也为后续算法设计和优化带来了全新视角。文章将深入解读这一突破的背景、核心理论、证明思路及其未来影响。计算复杂性和计算资源的权衡是理解计算机效率的关键。

算法运行时间(Time)指计算机完成任务所需的步骤数,而空间(Space)则指运行过程中机器所需的内存容量。传统上,人们知道时间常常是更为限制性的资源,但之前并未有理论证明,时间和空间在复杂性上的差距可以如此显著。这一次,Williams提出了一个划时代的模拟定理,表达了任意时间复杂度为t(n)的确定性算法,其空间复杂度最多为t(n)乘以对数t(n)。简单来说,如果一个算法的运行时间是t(n),那么它所需的空间远低于t(n),大约只需t(n)log t(n)。不仅如此,这一结果远远优于1977年由Hopcroft、Paul和Valiant提出的经典定理,当时最好已知的空间模拟界限大约是t(n)/log t(n),其空间消耗几乎达到时间复杂度的同等数量级。Williams定理实现了近乎平方级的空间效率提升,这在理论研究中令人瞩目。

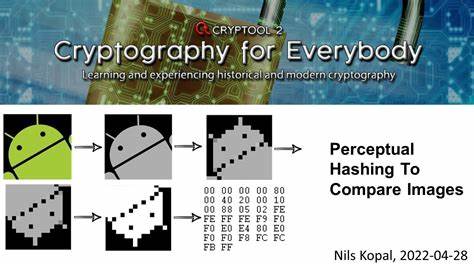

为何这是一个震惊领域的发现?首先,过去的计算复杂性证明中,空间的节省幅度较为有限,人们普遍认为时间消耗远大于空间的显著差距难以实现。Williams的成就成功打破了这一壁垒,展示了空间利用率的极致优化潜力。其次,这一空间模拟技术不保证在可控时间内执行,强调了时间和空间资源的根本差异:空间可以被有效回收和重复利用,而时间则是线性消耗、无法倒流。Williams的证明关键依赖于James Cook和Ian Mertz在前一届STOC会议上发表的空间高效的树形算法。该算法巧妙地借助有限域理论将时间分段片断以对数大小的寄存器编码,并在递归计算树节点的过程中,仅需极少的寄存器保留本地计算状态,大量其他空间反复利用,从而极大减少整体空间消耗。这一“魔法式”的算法设计是Williams模拟定理不可或缺的基石。

进一步来看,Williams基于多磁带图灵机和预先定义访问模式的随机访问机(oblivious RAM)模型,详细论证了该空间模拟定理的有效性。所使用的模型允许事先知道机器对记忆体的访问路径,从而优化空间管理。诸如随机访问机中实现完全通用访问模式、非确定性、量子计算等更广泛模型的模拟问题,则依旧是科学界尚未解决的前沿。该定理在复杂性理论中的意义深远。早在1986年,Mike Sipser提出硬性随机性假设,指若存在极其耗时却极其节省空间的算法,则可导出随机化类RP等价于确定性类P的结论。然而,Williams的定理推翻了这一假设,促使理论家重新审视硬度和随机性之间的关系,并激发新的假设框架和研究方向。

此外,改进Williams结果,进一步将空间模拟压缩到t(n)的幂次更小区间(例如n^ε,ε<1/2)可望实现对P与PSPACE分离的重大突破。此类进步将极大丰富我们对交替时间计算的理解,也可能对实际算法优化带来影响。学术界对Williams及其团队的证明流程表现出浓厚兴趣。建议深入研究Williams论文第3.1节及注脚6,这里提供了简化版本的空间界限。Cook和Mertz论文第2至4节则详细介绍了关键树形评估算法,而名家Oded Goldreich也发表了对该算法的详细注解,便于研究者系统掌握。实际意义方面,尽管理论证明强调的是计算过程中的资源利用性质,而非直接减少执行时间,但该发现为破解计算资源瓶颈、优化算法空间效率奠定了坚实基础。

例如,在虚拟化环境中,内存瓶颈常限制计算性能,Williams技术有可能启发低空间消耗的算法设计,改善资源分配。业界也对该结果在处理大规模数据、缓存管理、以及并行计算场景下的潜力表现出浓厚兴趣。公众对于该成果反应多样,有网友幽默调侃标题误以为为节省金钱而非内存发行,体现研究传播中的趣味性。同时,关注随机访问机模型开放性问题的人表示,结果也凸显了图灵机在时间成本上的低效,暗示空间节省的同时可能伴随时间效率限制。此外,一些专家提出理论之外的实际工程考虑,例如为何不以更多内存换取更少时间,回应了实际系统中时间与空间的权衡。展望未来,Williams定理开启了计算复杂性领域的新纪元。

科研人员正积极探索基于其方法的改进与应用,尝试将树形算法技术更直接地整合至图灵机模拟中,希望达到更优的空间时间界限。此外,对于尚未突破的随机访问机一般模型和量子计算模型,业界也充满期待其是否适用类似技术。作为计算复杂性理论的一项核心突破,Williams的工作不仅丰富了我们对计算资源之间复杂关系的理解,还激励着长期以来希望实现计算效率革命的学者们勇往直前。在大数据、人工智能高速发展的今天,如何在保证算法高效性的同时降低复杂计算中的空间消耗,正成为推动新一代计算技术进步的关键课题。此次突破虽聚焦理论,但其影响波及软件工程、硬件设计和系统架构,有望催生创新设计思路和优化技术,进而提升计算机科学的整体水平。总之,你需要的内存远少于时间,已不再是遥不可及的猜想,而是催生未来计算效率革新的现实基础。

科研人员和从业者们应当抓住这一历程中难得的机遇,推动理论与实践的深度融合,共同探索更加高效、节能的计算未来。