在现代软件开发中,应用的可观测性已经成为确保系统稳定运行和快速定位问题的关键手段。OpenTelemetry作为一个开放标准和框架,正在成为收集应用指标、日志和分布式追踪的事实标准。特别是在Go语言环境下,OpenTelemetry提供了便捷而强大的SDK支持,使开发者能轻松为应用添加监控能力。然而,所有的监控和追踪功能并非无成本,随之而来的性能开销和资源消耗是每个开发者必须认真考虑的问题。理解并量化OpenTelemetry对Go应用的影响,对于合理设计监控方案至关重要。本文将结合实际测试,深入探讨启用OpenTelemetry SDK对Go应用的CPU、内存、网络以及延迟等方面的影响,并从eBPF技术的角度提出轻量级监控的可行方案。

通过科学的实验方法与数据分析,帮助开发团队权衡观测深入度与性能负担之间的关系,从而做出合理的技术决策。观测性的重要性毋庸置疑,尤其是在微服务、容器化和云原生架构广泛应用的背景下,性能指标、请求追踪和日志分析成为快速定位故障的利器。然而,将OpenTelemetry集成到应用中后,探究其对系统性能的具体影响显得尤为必要。本文所基于的测试环境包括多台Linux节点,使用Go编写的HTTP服务作为被测应用。核心逻辑简单,通过对请求计数器的递增操作,模拟高并发场景下的业务负载。测试分两阶段进行,先在未集成OpenTelemetry的基线状态下测量性能指标,再启用OpenTelemetry SDK进行比较。

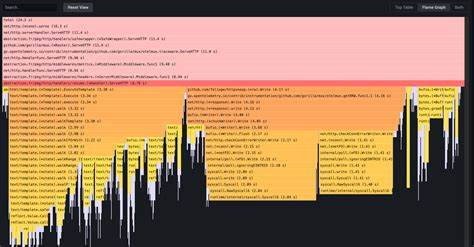

测试使用Docker容器隔离各部分组件,确保不同节点职责明确,避免互相干扰。同时采取主机网络模式,最大程度减少网络代理带来的额外延迟。整体负载由wrk2工具精确控制,设定每秒一万请求的压力级别,持续20分钟。在未启用OpenTelemetry的基线环境下,应用能够稳定处理高并发请求,95百分位延迟约为5毫秒,99百分位延迟则不超过10毫秒,偶尔会出现20毫秒的峰值。CPU资源占用稳定约为2核,内存保持在10MB左右,表现出极好的资源利用效率。启用OpenTelemetry SDK后,系统性能出现明显变化。

内存占用相比基线增加至15MB至18MB,主要由SDK自身及其后台传输线程消耗。CPU占用上升至2.7核,相较基线增加了约35%。更细致的CPU采样显示,近10%的CPU时间消耗在批量处理和导出追踪数据的组件上。同时Redis操作因加入追踪钩子增加了近7%的CPU开销。HTTP处理部分也因嵌入的中间件额外负担有所上涨。网络流量方面,启用追踪后每秒产生约4MB的上行流量,约合32Mbps。

对于高吞吐量应用或网络带宽有限的环境需谨慎评估这一开销。延迟指标虽有所上升,但幅度较小,99百分位延迟从10毫秒升至15毫秒,整体吞吐量保持稳定,无超时或错误发生。综合来看,OpenTelemetry在该Go应用中引入了可测量但在可接受范围内的开销。对性能要求极高的场景,这种开销不能忽视,而对绝大多数注重故障排查和诊断速度的团队而言,付出的性能代价值得获得的可观测性回报。面对部分工程师因性能限制犹豫启用追踪,eBPF(扩展的伯克利包过滤器)技术提供了一种无需修改应用代码的观测方案。eBPF能够在内核层面动态捕获应用行为,实现轻量级的监控。

Coroot社区版利用eBPF技术,收集指标及部分追踪数据,在高负载条件下建议仅启用指标收集以减少开销。测得运行在测试节点上的eBPF代理CPU使用率未超过0.3核,适合生产环境持续运行。相比SDK模式,eBPF方式牺牲了追踪的细粒度与全面视角,换取了更低的资源占用和更少的维护成本。换言之,选择何种观测方案需视具体业务需求而定。需要深入调试与完整请求链追踪时,SDK方式仍是最佳选择;而要求最低开销及快速部署的场景,则可优先考虑eBPF支持的指标采集框架。总结而言,观测技术的引入必然带来一定成本,关键看团队如何权衡性能与可观测性。

通过科学的基准测试,开发者可以明确不同观测方案的负载特性,避免盲目追踪导致性能瓶颈。当前OpenTelemetry生态不断完善,未来工具链的优化将进一步降低开销。与此同时,异构观测层的融合应用也为业界带来更多选择。Go语言社区对于OpenTelemetry的支持日益成熟,而结合eBPF的无侵入式观测技术,更帮助开发者以最低代价获得系统健康全貌。对于追求高性能与高可用的分布式应用,合理设计观测架构不仅提升故障响应速度,更有助于优化系统资源利用和用户体验。无论是SDK全量追踪还是轻量级指标采集,结合实际业务场景和性能预算,精细调优才能实现观测价值最大化。

未来,随着技术发展和标准演进,OpenTelemetry与内核级监控的深度整合将逐步成为行业趋势,为云原生应用运维提供更加高效和智能的解决方案。