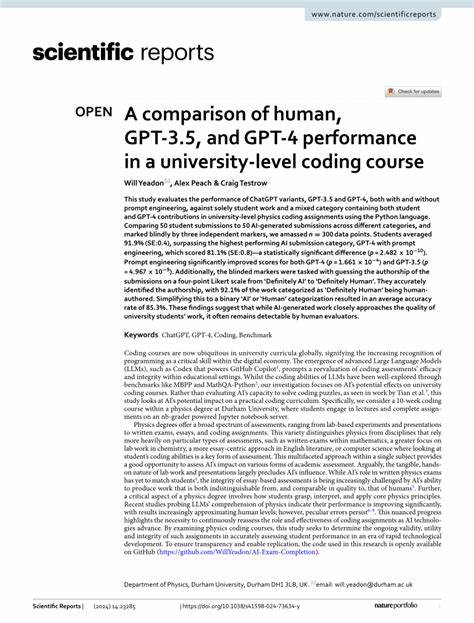

随着人工智能技术的迅猛发展,特别是大型语言模型(LLM)如GPT系列的出现,教育领域开始迎来前所未有的变革。尤其是在高等教育层面,GPT等模型在辅助解答课程作业和考试中的应用越来越引人关注。本文深入剖析了一项最新研究,该研究评估了GPT在一门以数学证明和算法为核心的大学课程中的实际表现,揭示了其能力与不足,并探讨了未来教育实践中如何合理利用这类AI工具。 GPT系列模型凭借其强大的语言理解和生成能力,已被广泛应用于多种文本生成场景,从写作助理、代码生成到学术研究支持。然而,在高度逻辑严谨、需要条理清晰且论证严密的数学证明课程中,其表现仍存在不确定性。最新研究通过匿名盲评的方式,将GPT-4o与o1-preview生成的解答与人类学生的作业进行对比,评估模型在真实教育环境中的水平。

研究采用了大学算法课程的期末考题,考题设计强调证明能力和逻辑推理,具有典型的大学数学训练特点。教学助理在不知答案来源的情况下对所有作答进行评分,确保评分的公正性与客观性。 结果显示,GPT-4o模型整体表现未达到及格线,说明其在严谨推理和证明细节的把控方面存在显著不足。其回答中常见的问题包括缺乏充分的论据支持、存在误导性论述及逻辑跳跃,致使整体推理不够扎实。相比之下,o1-preview模型表现显著优于GPT-4o,不仅超过及格标准,还在部分题目中超过了人类学生的中位数水平,这一现象显示了不同版本GPT模型之间能力的差异及升级带来的进步。尽管如此,o1-preview仍存在类似的逻辑漏洞和未充分论证的现象,提示人工智能在完全取代人类精确推理方面仍面临挑战。

这一发现为教育行业带来了重要启示。首先,虽然先进的LLM可以辅助学生拓展思路、提供解题思路参考,但完全依赖其输出存在风险。其生成的内容可能含有难以察觉的错误,若无严密把关,可能误导学生。其次,评估方式需与时俱进,传统的评分标准需结合AI生成内容的特点,厘清人类原创性与AI辅助的界限,建立适合混合教学环境的评估和监管体系。 同时,研究指出,教育工作者应结合自身教学目标灵活采用AI工具,将其作为促进理解和激发兴趣的辅助工具,而非评判学生学术水平的唯一标准。如何设计教学活动,使学生不仅能借助AI辅助完成任务,更能培养独立思考和严谨论证的能力,是当前亟需解决的关键问题。

另一个值得关注的角度是,GPT模型的局限性反映了当前AI技术在逻辑推理和抽象概念处理上的瓶颈。尽管模型在语言流畅性和数据中模式识别方面表现出色,但深入的数学证明需要对定义、定理及其内在联系有精准的理解和推理。这种认知层面的差距,是影响GPT类模型在学术严谨性领域难以大放异彩的重要原因。 在未来的发展方向上,提升AI在逻辑推理和知识结构理解能力将成为重点。可能的路径包括将符号推理引入语言模型架构,加深模型的数学领域知识,结合人类专家反馈不断优化AI推理过程。此外,教育界可以探索如何融合AI工具与传统教学,通过个性化学习计划和互动反馈机制,提高学生学习效率和质量。

综上所述,GPT在大学证明型课程中的表现虽有亮点,但整体还未达到完全取代或独立完成高水平数学证明的能力。教学和学术评估应理性看待AI输出,既利用其辅助潜力,也警惕其错误隐患。未来AI教育应用的发展,将依赖于技术的不断进步与教育理念的同步更新。当机器智能与人类智慧携手合作,教育的未来将更加丰富和多元。 通过这项研究,教育者可以更加清晰地了解AI在复杂学术任务中的实际表现和适用边界,从而制定更加科学有效的教学策略,促进高等教育的创新与发展。