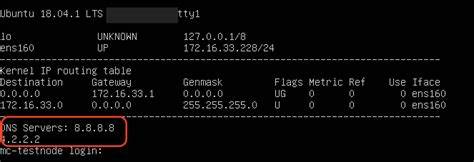

在现代云原生架构中,Kubernetes(简称K8s)作为容器编排平台的重要性日益凸显,而DNS解析作为服务发现和集群通信的基础环节,其稳定性对于整个系统的正常运行至关重要。然而,许多Kubernetes用户经常遇到DNS解析失败的问题,导致应用无法通过服务名称访问其他服务,从而引发连通性故障。经过深入分析,网络策略(Network Policies)往往是导致DNS解析失败的隐形“元凶”。 Kubernetes使用CoreDNS作为默认的DNS服务,监听集群内的53端口(包括UDP和TCP协议),为Pod提供名称解析功能。网络策略用来限制Pod之间以及Pod与外部之间的通信权限,这虽然增强了安全性,却也极易在不慎配置时造成对CoreDNS的访问阻断。具体表现为Pod无法向Kube-system命名空间中的CoreDNS服务发起DNS查询请求,进而导致服务名称查找失败。

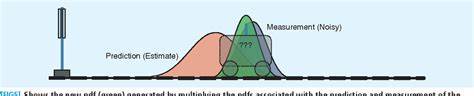

用户通常会遭遇类似“Could not resolve host: example.com”或“lookup <service-name> on 10.96.0.10:53: no such host”的错误信息,这标志着DNS请求被拦截,无法正常完成域名解析。此时应用层的请求因无法转化为IP地址而失败,严重影响服务的互联互通和稳定性。 造成这一问题的本质原因在于网络策略对出口流量(Egress Traffic)的限制。如果集群网络策略中没有明确允许Pod访问53端口的DNS请求,默认策略可能会阻止所有出站流量,从而断开与DNS服务的连接。尤其在采用严格零信任模型或者强化安全防护的场景下,这种误配置更为常见。 为了解决DNS解析失败问题,首先需要审视当前的网络策略配置,确认是否允许了Pod对CoreDNS服务的UDP和TCP端口53的访问权限。

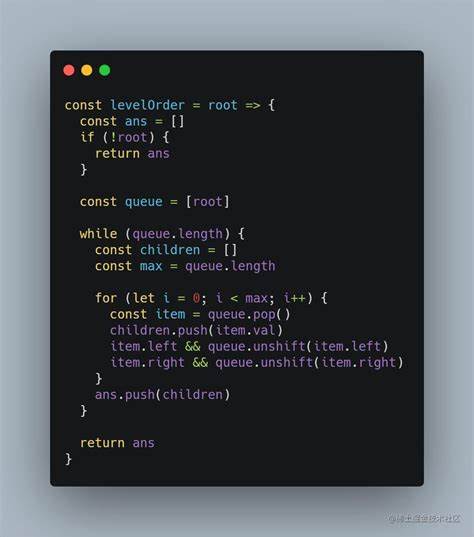

可以从受影响的Pod中执行DNS查询测试,如通过kubectl exec进入Pod执行nslookup或dig命令测试域名解析。若Pod运行的是轻量或无shell环境,则可以依赖kubectl debug创建调试容器,并安装必要的网络工具进行诊断。 网络策略的配置调整是关键步骤。通常需要为DNS流量专门开启出口规则,指定目标为kube-system命名空间下运行的CoreDNS Pod,允许UDP和TCP协议的53端口通信。示例修正后的网络策略明确加入了这类规则,保证了DNS请求能够顺利发出并接受响应,同时兼顾允许其他业务服务端口的规则,以避免影响正常服务流量。 完成网络策略调整后,重新执行DNS解析测试,正常情况下会看到请求成功返回IP地址,验证问题被彻底解决。

此外,为了深入了解网络流量状态,可以利用tcpdump等抓包工具在集群节点层面对DNS请求进行监控,从数据包级别确认流量是否经过网络策略的合理转发和允许,这有助于排查更复杂的网络故障。 伴随着Kubernetes集群规模的扩大与网络策略数量的激增,手动管理和频繁调整网络规则会带来极大挑战。为此,自动化工具如Otterize进入了视野,能够借助Intent Operator和Network Mapper自动捕捉应用通信意图,生成准确且安全的网络策略,避免人为配置失误,提升运维效率和集群安全性。 总的来说,Kubernetes中DNS解析失败的现象极大可能是因网络策略阻断了DNS流量。重视网络策略对DNS访问的配置,积极采用自动化工具管理策略,合理监控流量,才能保障应用的稳定性和集群的健康运行。面对复杂多变的云原生网络环境,理解和掌握DNS流量与网络策略的互动关系是每一位Kubernetes管理员和开发者不可或缺的核心能力。

随着技术的不断发展,云原生网络安全与自动化也将成为提升集群可靠性的关键方向。