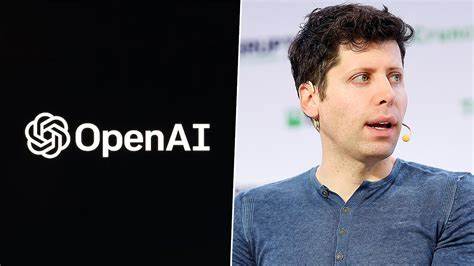

在人工智能迅速发展的时代,OpenAI的管理层和安全委员会的变化无疑引起了行业内外的广泛关注。近日,OpenAI首席执行官山姆·阿尔特曼(Sam Altman)宣布他将退出该公司于今年五月成立的“安全与安全委员会”。这一决策引发了对OpenAI未来安全政策和管理结构的深刻思考。 作为全球人工智能领域的领军组织,OpenAI自成立以来便承诺研发安全且有利于人类的人工智能技术。然而,阿尔特曼的离开让人不禁思考,OpenAI的目标和企业利益之间是否存在着无法调和的矛盾。新的安全委员会将在卡内基梅隆大学教授齐科·科尔特(Zico Kolter)的主持下运作,成员还包括Quora首席执行官亚当·德安吉洛(Adam D’Angelo)、退休的美国陆军将军保罗·纳卡索内(Paul Nakasone)以及前索尼高管尼科尔·塞利格曼(Nicole Seligman)。

这些成员都是OpenAI董事会的现任成员,新的结构能否为OpenAI带来更负责任的安全监督,值得我们关注。 在阿尔特曼辞去委员会职务后,新的安全委员会立即开展了一项关于OpenAI最新人工智能模型“o1”的安全审查。这一举措表明,尽管领导层发生变化,OpenAI依然重视安全性问题,并承诺将继续定期接收来自安全团队的报告,以便密切关注潜在风险。委员会有权推迟发布更新,直至安全问题得到解决,这一机制无疑是确保技术安全的重要步骤。 不过,阿尔特曼的离开并不是孤立事件。近日,美国五位参议员对OpenAI的政策表示担忧,致函阿尔特曼询问相关问题。

而且,OpenAI内部曾有近一半致力于AI长期风险研究的工作人员离开,令人对公司在面对外部审视时的透明度和责任心产生质疑。甚至有前OpenAI研究员对阿尔特曼提出了批评,指责他反对“真正的”人工智能监管,认为他更倾向于采取符合OpenAI商业利益的政策。 实际上,OpenAI近年来的联邦游说支出激增,2024年上半年预算达到80万美元,而去年全年的支出仅为26万美元。这显示出公司在寻求更多政策支持及资金投入的同时,也引发了外界对其安全和伦理承诺的质疑。此外,阿尔特曼在春季加入了美国国土安全部的人工智能安全与安全委员会,旨在为美国重要基础设施的人工智能开发和部署提供建议,这进一步印证了他在促进人工智能行业的发展中的影响力。 新的安全委员会的成立与变化,是否能够突破内部利益和外部压力之间的矛盾?阿尔特曼的离开让人们开始反思,OpenAI是否能够在日益激烈的商业竞争中保持其原有的愿景和使命。

曾有前OpenAI董事会成员在《经济学人》上发表文章,指出现如今的OpenAI无法自我监管,认为基于利润的激励驱动让公司难以保持其初衷。他们表示,自我治理在面对利润驱动时很难坚持,这是对OpenAI未来方向的重要提醒。 目前,OpenAI正传出将融资65亿美元以使公司估值超过1500亿美元的消息,这一数额表明公司正在进一步扩展其市场份额,更可能放弃其混合非营利的企业结构,而这也让许多人对其长远目标和价值观产生疑虑。阿尔特曼的离开可能使得OpenAI的未来决策变得更加商业化,其对原本旨在造福全人类的使命是否会受到影响,令人深思。 从近期的动态来看,虽然OpenAI正在积极寻找新的资金支持,但其是否能够在追求商业利益与承担社会责任之间找到平衡,依然是一个未解的难题。许多观察者对此表示担忧,他们认为,密切监控AI安全的机制和政策监管框架必须随着技术的发展而不断完善,以确保我们所开发的系统不会在追求效率和利润时危害公众利益。

阿尔特曼的离开不仅是OpenAI内部结构的调整,更是人工智能行业自我审视的重要时刻。随着AI技术在生活中发挥的作用愈加显著,企业在确保技术安全与伦理边界方面面临的挑战也愈加严峻。是否能够在维护创新的同时,确保对社会负责,将是OpenAI以及整个AI生态系统必须共同面对的重要课题。 在面对未来,OpenAI若想实现其愿景,维持其在人工智能领域的领导地位,就必须重新审视其战略方向以及治理结构,以便更好地应对外界的质疑和内部的挑战。我们期待看到,新的安全委员会能够在阿尔特曼不再的情况下,继续推动OpenAI在安全与技术发展之间寻求更好的平衡。