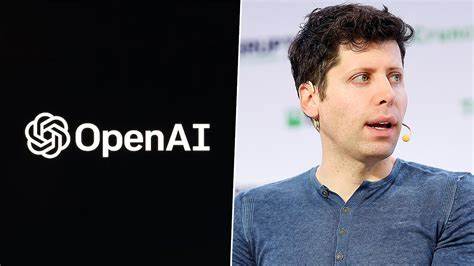

在人工智能技术迅猛发展的今天,安全问题也变得愈发突出。最近,OpenAI公司宣布 CEO 山姆·奥特曼(Sam Altman)将不再担任新成立的安全委员会成员,这一消息引发了广泛关注与讨论。这一变动不仅意味着 OpenAI 对安全重视程度的提升,也是对内部治理结构的一次重要调整。 OpenAI 的安全委员会最初设立的目的是为了监督该公司日益增长的人工智能系统的开发安全性。然而,随着 AI 能力的不断增强,对安全的关注也逐渐上升到战略层面。正因为如此,OpenAI 决定扩大安全委员会的权力,从单纯的建议者变为拥有监督新 AI 模型安全评估和推迟任何新产品发布的权力的机构。

在新安全委员会的组成中,卡内基梅隆大学机器学习系主任齐克·科尔特(Zico Kolter)将担任委员会主席,其他成员包括 Quora 的 CEO 亚当·达安格(Adam D’Angelo)、退休的美国陆军将军保罗·纳卡索内(Paul Nakasone),以及前索尼的 EVP 和总法律顾问妮可·塞利格曼(Nicole Seligman)。这些成员的加入无疑为委员会增添了多样性和专业性,使其在处理 AI 安全事务时更具权威性。 值得注意的是,此次变动发生在奥特曼刚刚宣布将领导一个新的安全委员会的几个月之后,这一新委员会的设立在当时引起了业内的广泛期待。然而,随之而来的却是奥特曼决定卸任责任,以解决潜在的利益冲突问题。该决策还伴随着原安全委员会成员的相继离职,特别是两位联合创始人伊利亚·苏茨凯弗(Ilya Sutskever)和扬·莱克(Jan Leike)的退出。莱克在离开时,公开批评 OpenAI 忽视“安全文化和流程”,执着于“光鲜的产品”,这引发了对公司未来发展的担忧。

这一系列的变动表明,OpenAI 正在经历一次深刻的自我反思和结构重构。而这种重构的背后,亦是对当前 AI 技术快速发展的深刻认识。随着 ChatGPT 以及其他大型语言模型的崛起,社会各界越来越关注这些技术的安全性。AI 的迅猛发展带来了诸多挑战,如何保障其在实际应用过程中的安全性已经成为全球科技界亟需面对的问题。 新安全委员会的成立,标志着 OpenAI 在治理结构上迈出了重要一步。通过将安全监督的权力从公司内部转移到一个独立的委员会,OpenAI 希望能够减少内部利益冲突,确保安全评估过程的公正性与专业性。

委员会的独立性意味着任何与产品发布相关的决策,都将经过严格的安全审核。这对于开发更为安全的 AI 系统至关重要,能够在一定程度上缓解社会对人工智能潜在风险的担忧。 尽管奥特曼的卸任让人感到意外,但从长远看,这一决策反映出 OpenAI 希望将人工智能的开发和应用置于更加安全和负责任的框架之内。未来,如何在技术快速发展的同时,确保 AI 的安全性,将是 OpenAI 及整个科技行业必须面对的一个重要议题。 对于普通用户而言,AI 安全不仅仅是技术领域的问题,更关乎社会的方方面面。无论是应用于金融、医疗、教育,还是其他行业,AI 系统的安全性都会直接影响到人们的生活。

随着各国对 AI 安全规制的日益重视,OpenAI 此次调整不仅是回应内部的质疑,同时也是对全球对 AI 安全监管需求的积极响应。 未来,我们可以期待 OpenAI 在新安全委员会的指引下,能够在 AI 的安全开发上迈出坚实的步伐。无论是从科技创新的角度,还是社会责任感的角度,确保人工智能的安全性将是推动这一领域可持续发展的重要基础。 总结来说,山姆·奥特曼卸任 OpenAI 新安全委员会的成员,既是一个变化的节点,也是一个新开始。随着这一委员会的独立运作,OpenAI 必将在 AI 安全治理的道路上,迈出更为坚定的步伐。这一事件提醒我们,科技的发展离不开相应的安全保障,而如何在创新与安全之间找到平衡,究竟是科技公司未来必须面对的挑战,也是全社会共同发展的责任。

未来的人工智能,只有在安全的框架之内,才能真正造福人类。