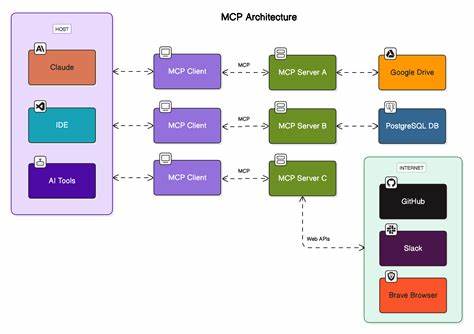

在当前人工智能迅猛发展的背景下,算力需求的激增推动了数据中心基础设施的变革。尽管提及人工智能基础设施时,人们往往首先想到的是GPU,但实际支撑起庞大复杂神经网络训练的,是各种层级的互连技术。实现高效的芯片间、系统间通信是训练数万亿参数模型的关键所在,博通(Broadcom)正悄无声息地在这一领域发力,试图以其多样化的互连解决方案抢占市场高地。 博通的影响力源于其全面的互连技术布局,从芯片封装内部的晶圆间通信,到系统内的芯片间连接,再到数据中心规模的系统间网络,几乎涵盖了AI计算硬件中所有重要的通信环节。与依赖自研封闭生态的巨头不同,博通专注于“商用硅”(merchant silicon)市场,即将其芯片和知识产权授权给众多客户,广泛隐藏于多家头部科技企业的技术方案之中。例如,Google的TPU在多处采用了博通的IP设计,而苹果等公司也传闻基于博通技术打造面向AI的服务器芯片。

对于大规模云服务提供商和超级计算中心而言,这种模式极具吸引力。他们可以利用博通现成的互连组件,专注于打造差异化的计算核心和软件架构,省去重复开发互连技术的时间和成本。由此,博通定位为支持整个AI生态的“基础设施中枢”,参与从硬件互联通道到光通信和封装技术的多个层面。 以太网交换芯片是博通在AI互连市场的重要武器之一。随着部署的GPU数量达数十万,连接这些加速器所需的交换节点令人瞠目结舌。博通凭借其高端Tomahawk系列交换芯片,在高端数据中心交换市场占据重要位置。

比如,2022年推出的Tomahawk 5具备51.2Tbps吞吐能力,而2025年更新的Tomahawk 6将吞吐率提升至102.4Tbps,配合多达1024个100Gbps或512个200Gbps高速SerDes端口,使得在两层网络架构下,仅需750台交换机即可连接高达12.8万个GPU。 数据中心规模的以太网交换能力不断突破,为大规模AI训练搭建了坚实的网络骨干。虽然像Nvidia、Marvell和Cisco等竞争者也在开发相似性能的高端交换芯片,但博通凭借其较早的布局和稳定的产品线,在大部分顶级云服务商和大型AI项目中占据关键地位。 除了传统的数据中心“规模外扩”以太网构架之外,博通还积极推动“规模内扩展”以太网方案。即针对单机机架甚至多机架范围内部署数十到数百个GPU的高性能互连网络。传统的点对点连接和专有协议在扩展性和兼容性上存在局限,而博通倡导利用标准以太网技术实现灵活高效的规模升级互连,避免客户因供应商锁定陷入困境。

行业正逐步接受以太网作为规模内的互连方案。英特尔的Gaudi AI训练平台已经使用以太网构建规模内和规模外互连,AMD计划在其下一代系统中通过以太网隧道封装开放的ULink协议,这显示出以太网在AI规格互连中的可行性和成熟度。博通自家的scale-up Ethernet技术栈已经开始整合支持现有高性能交换机,实现低延迟和高带宽的机架内互联,为硬件设计者提供开放且兼容的方案。 光组件共封装(Co-Packaged Optics, CPO)是博通近年来重点投资的技术。传统数据中心网络依赖可插拔光模块连接交换机和光纤,但这带来功耗和空间方面的限制。通过将激光器、数码信号处理器与复用器等光通信组件直接封装到交换芯片上,CPO技术大幅降低了功耗,缩小了系统体积,提升了带宽密度。

根据博通数据,CPO方案功耗较传统可插拔光模块节省超过3.5倍。 博通自2021年起推出的CPO产品不断升级,最新版本能够支持每条光通道高达200Gbps的数据速率,配合Tomahawk 6芯片可实现多达512个200Gbps的光纤端口。预计到2028年,博通将率先推出支持400Gbps通道速率的CPO解决方案,应对未来AI数据中心的爆炸性带宽需求。 其他芯片巨头如Nvidia也在探索基于光子技术的网络设备,但更多聚焦于规模外扩网络,规模内扩展仍主要依赖铜缆连接。铜缆虽然成本和能耗较低,但传输距离和带宽受到限制。博通提出将光学组件直接共封装到加速器芯片上,已演示出6.4Tbps光互连芯片组,极大提升单个GPU或AI加速器的带宽能力。

此举有望支撑数百个GPU联合作为单一规模化系统,提升训练效率和系统灵活性。 此外,随着摩尔定律放缓,单块芯片规模难以大幅提升,行业正转向多芯片模块(MCM)和3D封装技术解决性能瓶颈。博通推出了名为3.5D XDSiP的多芯片封装蓝图,支持密集的面向面连接,利用混合铜键合(Hybrid Copper Bonding)技术,实现芯片间更高速度、更低延迟的信号传输。与市场上现有的面向背面连接方案相比,这种做法在互连效率和封装简化方面具备优势。 博通的3.5D封装设计向所有芯片设计者开放授权,有望成为下一代AI加速器与系统设计的标准基础。未来多芯片GPU和异构计算平台的高效互联,将极大提升AI模型训练和推理性能,同时降低制造复杂度和成本。

博通的成功,一方面得益于其多层次互连技术的成熟和完善,另一方面来自于“隐形巨人”的市场策略:通过作为商用硅供应商和IP授权方,博通巧妙地融入到包括Google、苹果、Meta等行业领军者的AI硬件生态。相较于传统封闭式全栈硬件方案,客户可以灵活采用博通的互连解决方案,专注于自己的创新逻辑设计,从而快速应对AI应用的需求爆发。 展望未来,随着AI模型不断庞大,训练计算需求继续攀升,数据中心互连技术的重要地位将愈发突出。博通已通过高带宽交换芯片、先进的光学共封装技术以及领先的多芯片封装方案,构建起一个覆盖整体AI基础设施的技术体系。这个体系不仅满足了当下大规模训练的性能和能耗需求,也为未来全新的AI硬件架构创新提供了坚实基础。 从芯片封装内的高速互连,到数据中心内数千甚至数万加速器的以太坊交换网络,再到共封装光模块带来的带宽和能效革命,博通正在以多维度的技术实力和灵活开放的商业模式,悄无声息地完成从数据中心网络巨头到AI基础设施核心供应商的转型。

它的成功故事不仅为中国乃至全球AI产业提供宝贵参考,也为相关企业如何抓住AI基础设施赛道提出了有益启示。