在现代科技高速发展的今天,计算机已深入到我们生活的方方面面,但很多人依旧会好奇一个看似简单却至关重要的问题:为什么计算机只用零和一两个状态来工作,而不是采用三态甚至更多状态的系统?为什么没有其他进制体系能够像二进制那样称霸计算领域?这不是因为二进制在数学上最完美,或者是某种优雅的理论选择,而是基于现实世界中物理规律、制造技术、经济成本以及人类行为习惯的综合影响,二进制成为了唯一可以真正承受复杂环境考验的方案。从微观半导体物理到宏观产业链的演变,都为二进制的胜利提供了坚实的基础。物理定律不容商量,微观世界的噪声问题天然决定了必须用最简单的状态区分来保证信号的准确传递。随着晶体管尺寸缩小到纳米级别,电压的抖动、时间同步的偏差、温度的波动甚至宇宙射线的干扰,都会给信号的多状态识别带来极大挑战。相比于试图划分三态、五态乃至更多等级的系统,二进制只需界定一个清晰的阈值——高电压代表1,低电压代表0,这样的“二桶”逻辑为噪声留出了最大安全余地,让信号在极端噪声环境下依然能被识别和处理。尝试构建三态逻辑的电压区间非常窄小,极易被制造过程中细微干扰破坏,导致系统不稳定。

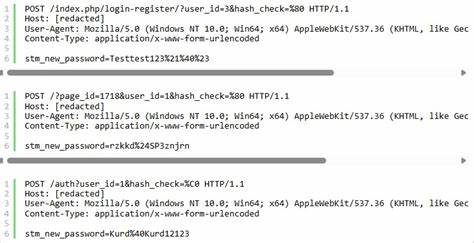

这种中间态的模糊性不仅难以控制,更会给量产带来不可接受的高风险,直接阻碍技术的规模扩展。真正的实验和历史验证也证实了这一点。20世纪50年代,苏联研发的Setun三进制计算机在实验室能较好运行,但在大规模工业生产中惨遭失败。美国贝尔实验室曾大胆尝试4态、8态多值逻辑系统,数学理论上虽美轮美奂,但物理实现却困难重重,电路复杂且不可靠,最终被逐渐放弃。模拟计算机虽然能处理连续信息,但其使用场景极其有限,不具备数字计算的通用性和可复制性。即使是在当前的人工智能领域中,虽然浮点数、低精度整数权重在算法层面魅力无限,底层依然是基于无数开关管的二进制硬件运行。

量子计算虽引入了叠加态等新概念,但量子比特本身需要传统二进制计算机来做错误纠正和控制,经典计算依然是不可或缺的基石。经济成本和产业锁定效应使二进制成为难以替代的存在。全球数万亿美元的半导体制造设备、无数二进制逻辑电路的设计和优化软件、几代专业工程师的经验积累,以及庞大的二进制软件生态系统,共同构筑了一个极高的进入门槛。即便出现从理论上更优的三进制或多进制计算机,也必须要付出巨额的研发、制造、重建编译器和软件、再培训工程师等成本。投入与产出比令绝大多数企业望而却步。就像键盘布局的QWERTY由于历史原因根深蒂固,尽管Dvorak在效率上更优,但依然未能实现主流替代。

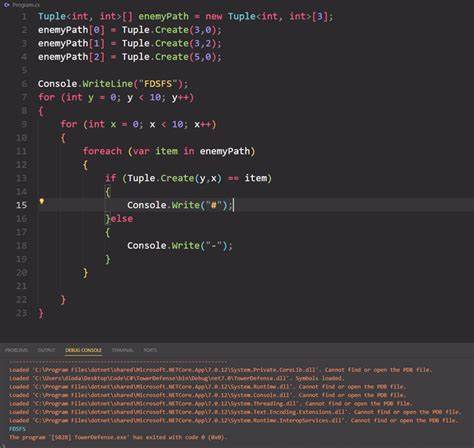

技术生态的惯性让二进制独大继续稳如泰山。二进制的技术优势不仅体现在抗噪声能力上,还体现在逻辑电路简洁性与设计效率上。复杂的数字系统几乎全由NAND、NOR两类含非逻辑门构建,逻辑简化使电子设计自动化工具更高效且成熟,从芯片设计、验证到制造,每一步都能保证高度可靠。数据存储单元—无论是SRAM、DRAM还是各种缓存机制,都依赖于两状态的稳定保存来实现。电路从一个状态切换到另一个状态,只需越过电压阈值,没有多余中间过渡,切换速度快且能耗低,这对于追求高性能和低功耗的现代计算至关重要。除了物理和技术层面,调试复杂度也是被忽视的重要因素。

模拟电路的波动性和多态性导致故障模式模糊,调试时令人头疼。二进制以明确的0和1状态让工程师能够快速定位问题,提升生产线稳定性与产品质量。软件工具链同样方面,几十年积累的编译器、仿真器和测试框架都围绕二进制架构构建,庞大的生态系统形成自我强化循环。未来新计算范式虽然层出不穷,诸如量子计算、光子计算、神经形态计算等都在探索突破,但目前它们大多数仍建立在传统二进制体系之上。量子计算的经典处理部分依然是基于传统逻辑,神经形态芯片在模拟大脑结构的同时也借助二进制电路的精准控制。说白了,现代计算的“底盘”还在二进制逻辑上,尽管“车身”和“引擎”日益复杂。

总结而言,二进制之所以能击败其他进制和逻辑体系,不是偶然而是必然。它在自然法则的制约下拥有最稳健的信号识别能力,在技术实现层面有最简洁高效的逻辑实现,经济和产业链层面则形成了难以替换的巨大壁垒。短期内,我们不太可能看到非二进制计算机大规模取代现有体系。相反,在未来,更多的是在持续优化二进制底层架构,让其更节能、更高效、更智能。借助量子计算与神经形态技术等新兴力量补充计算能力,而非彻底取代二进制。理解这些背景能帮助我们更好地看懂计算机的发展轨迹,也能对未来计算技术演进有更加理性的期待。

。