人工智能作为当前科技领域最炙手可热的技术之一,正在深刻改变着人们的生活和工作方式。无论是在文本生成、图像识别、语音转写,还是代码编写、内容创作等场景,AI工具正发挥着不可忽视的辅助作用。然而,令人困惑的是,为什么不同的人在使用人工智能时,体验却差异巨大?有些用户认为AI大幅提升了他们的工作效率,而另一些则抱怨AI误差频出,使用体验糟糕透顶。要理解这种“极端分化”的现象,必须从多维度出发,全面剖析背后的关键因素。首先,人工智能模型的设计和局限性是影响用户体验的核心因素。当前大多数主流AI,尤其是基于大型语言模型(LLM)的系统,在生成内容时采用的是概率分布和模式匹配技术,它们更多地倾向于“模仿”而非真正理解人类语言的深层含义。

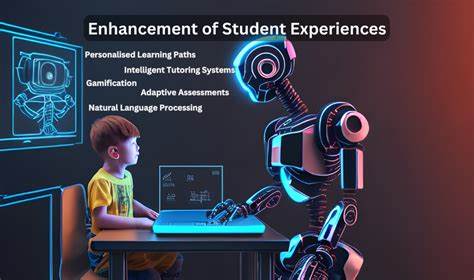

因此,AI在面对模棱两可或复杂知识时,难免会出现“幻觉”(hallucination)——造出听上去合理但事实错误的信息。这种模型本身的局限性,使得其结果的准确性具有不确定性,有时甚至让专业人士无法接受。其次,用户的专业背景和对AI的认知水平对于体验差别起着至关重要的作用。正如不少专家指出,AI在帮助记忆简单命令或快速查找资料时表现不俗,成为文档查阅和基础编码的有效辅助工具。然而,对于有深入专业知识的人而言,AI频繁出现的细节错误、逻辑混乱或信息偏差极易暴露,进而降低其信任度和使用满意度。可以说,专业知识越丰富,用户越难被AI的表面合理性所蒙蔽,错误也越容易被察觉。

相反,缺乏相关领域知识的用户,往往难以分辨AI输出的真实性,很容易对其表现产生过高评价,认为AI是“万能”的助手。再来,使用场景和需求的不同也导致了体验的差异。许多人工智能应用在执行具体、明确任务时,如简单的文字校对、图片轻度处理或语音转录,精度较高,能够满足用户的预期和需求。但如果将AI用来处理需要高度精准或专业判断的任务,比如法律咨询、医学诊断、或复杂程序设计,AI的错误代价大幅增加,导致用户体验急剧下滑。换言之,AI的合适应用场景与用户需求匹配程度,直接影响用户对技术的认可与依赖。此外,人工智能的动态发展和版本更新频率,也是造成体验差异的重要原因。

市场上存在数以百计的AI模型和平台,不同算法的训练数据、结构和优化目标各异,导致用户在不同产品之间切换时体验截然不同。更糟糕的是,许多平台并未明确标注所采用的具体模型版本及其能力范围,令用户难以判断使用的工具的实际水平和适用性。这种信息不透明进一步加剧了感知上的落差和混乱。值得一提的是,用户对AI“预期”心理的差异也不可忽视。一些用户将AI视为一台能自动完成绝大多数任务的智能机器,抱有过高的期望,结果当AI出现问题时会感到失望甚至愤怒。而另一些用户则以较为理性的态度,把AI看作是一个需要反复验证与校正的辅助工具,即使出现错误也愿意承担并加以纠正,对AI的容忍度和满意度自然较高。

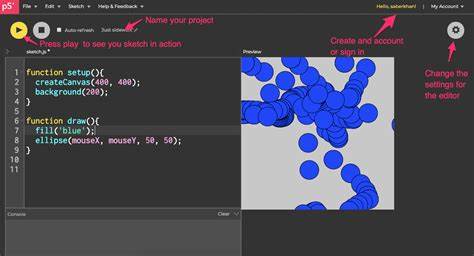

这种认知差异也导致了用户体验的极端分化。另外,用户与AI交互的技能和方式亦是关键。优秀的提示工程(Prompt Engineering)能力能够显著提升AI的输出质量。懂得如何准确表述需求、分步引导AI完成复杂任务的用户,往往能够获得更精准和实用的结果。而对提示无经验或未加修正的用户,则容易陷入模糊描述带来的误导性答案,体验自然大打折扣。总的来说,人工智能使用体验之所以存在戏剧性的不同,是技术本身的局限与不稳定、用户知识水平和认知预期的差异、具体使用需求和场景的不匹配以及信息透明度的不足等多重因素交织的结果。

面对这些挑战,用户应保持理性,培养基本的AI使用素养和辨识能力,避免盲目信任或全盘否定。同时,开发者应提升模型的稳定性,加强对细节准确性的优化,并在产品层面提供更多透明信息和明确的适用范围提示,帮助用户合理定位AI的作用和期待。未来,随着人工智能技术的持续进步和应用生态的完善,用户体验的鸿沟有望逐步缩小。但是,理解并接受当前AI的实际能力边界,才是避免失望与误用的根本之道。