近年来,随着芯片制造工艺的不断改进和新一代处理器的推出,计算机硬件性能似乎在持续提升。以苹果的M系列芯片为例,其从M1到最新的M2 Pro,数值上的性能提升显著,理论性能和能效均处于行业领先水平。然而,许多用户却感觉日常使用电脑的速度变化并不大,甚至浏览网页、切换标签页的体验与十年前差别不大。为何随着技术的飞速发展,计算机速度的使用感知却没有明显提升?要理解这个现象,需要从多个维度综合探讨计算机性能提升的背景、软件生态变化、用户体验心理以及硬件与网络环境的限制等方面。首先,计算机系统的响应速度与用户界面设计密切相关。多年前就已经确定的用户界面响应标准基本满足人们对交互体验的需求,换句话说,界面速度提升超过某个阈值后,用户察觉不到更多的快感。

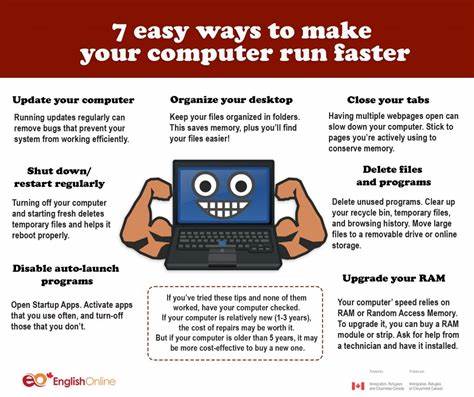

这种“满足阈值”导致了界面操作速度的提升不再是感知上的重点,因为人与设备交互的节奏基本固定,无需更快也不易察觉更快。当我们用电脑浏览网页或打开应用时,操作的卡顿与延迟往往与硬件性能无关,而是由网络传输速度、服务器响应、软件效率等多因素引起。现代的web应用越来越复杂和庞大,前端代码量级飞速膨胀,加载资源多,渲染需求高,这导致了软件本身“变臃肿”,运行效率下降。所谓的“软件膨胀”现象,指的是软件开发过程中功能堆积、代码体积不断增加,虽硬件性能提升,但软件复杂度的上升速度更快速,从而消耗掉本该带来显著性能提升的硬件优势。另一条重要原因是硬件性能提升方式的转变。过去十多年,CPU的主频增长放缓,性能提升更多依赖于并行计算能力和多核设计。

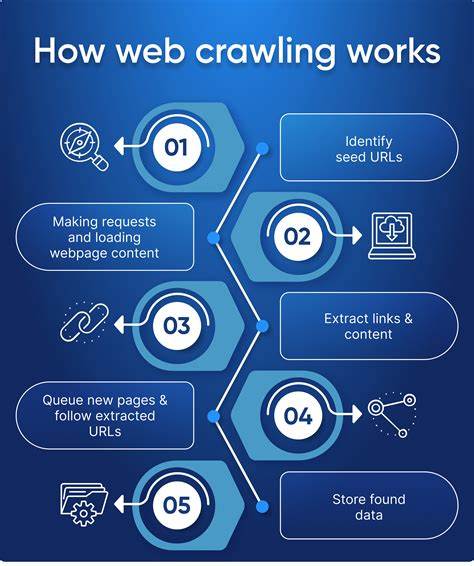

而浏览器等应用的单线程性能提升有限,因此对日常操作速度的影响不大。换句话说,现代处理器更适合处理多任务和大规模并行计算,但这些并不是日常电脑速度感知的核心。用户感觉电脑速度变慢或没有变快,部分体现了安达法尔定律的影响。该定律指出,无论系统多快,整体任务时间都会被必须顺序执行的部分限制。即使电脑硬件性能再高,但网络延迟、I/O速度和软件执行流程中的顺序瓶颈使得整体体验效果难以大幅度优化。尤其是在大量数据需要网络传输的应用场景,如网页浏览、在线文档编辑、云端协作时,网络速度和响应成为体验质量的决定因素,这无疑限制了对本地硬件性能的感知提升。

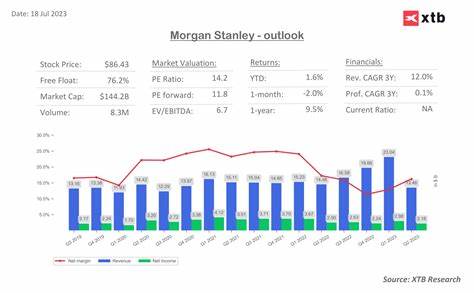

值得注意的是,系统的其他资源使用也会影响速度感知。例如,内存占用率高时,系统可能频繁进行内存交换或垃圾回收,造成响应延迟。现代应用如即时通讯软件、代码编辑器和浏览器插件等往往会占用大量内存,这些隐性资源消耗加剧了卡顿感。苹果M系列芯片虽然在CPU和GPU性能上取得了显著进步,但面对现代软件生态系统不断增长的资源消耗和对多核并行的依赖,单核性能提升的感知被稀释。另外,硬件设计上的物理限制同样不可忽视。芯片制程的进步从10纳米到5纳米带来了性能和能耗上的跃升,但每一次制造工艺的重大突破都愈发困难,性能提升的曲线趋于平缓。

加之市场对于功耗和散热的严格要求,使得芯片设计不得不在性能与能效之间做出权衡。此外,图形处理单元(GPU)作为现代计算机性能的重要组成部分,也面临架构创新受限和应用需求不断变化的挑战。许多日常任务并未充分利用高性能GPU的并行计算能力,导致用户难以直观感受到硬件性能的提升。与此同时,用户对计算机速度的感知具有主观性和心理因素。对熟悉环境的惯常期望使得注意力更多聚焦于任务响应中断和卡顿瞬间,而非持续稳定的性能提升。另一方面,新技术常常伴随着新功能和复杂交互,用户的注意力分散使得对速度提升的感知减弱。

总之,电脑性能虽然以硬件指标形式持续提升,但在实际使用中感觉不到明显加快的原因,是多因素叠加的结果。软件复杂度的增长消耗了硬件升级带来的优势,网络与系统架构的物理瓶颈限制了实际响应速度,用户界面的交互体验设计达到满意阈值后提升有限,再加上人的感知局限,形成了体验速度停滞的现象。理解这些背后的技术规律,有助于我们正确看待计算机技术的发展趋势,不盲目追求极端硬件数字,而是关注软硬协同优化和整体使用体验提升。未来随着人工智能辅助优化、云计算加速算法和更高效软件架构的普及,电脑的响应与算力感知仍有可能跨越现有瓶颈,带来更贴近实际需求的速度体验。