在人工智能技术迅猛发展的当下,推理(Inference)作为AI模型输出结果的关键环节,其性能直接决定了应用的用户体验和实际效益。Groq作为领先的推理基础设施提供商,以“速度、质量、成本及规模”为核心,打造了面向未来的高效计算平台,推动AI推理走向更高水平。 Groq的与众不同之处,首先体现在其自2016年开创的定制硅—LPU(Lightweight Processing Unit)上。不同于传统依赖GPU的推理架构,Groq凭借专为推理任务设计的LPU芯片,彻底改变了计算资源的分配与优化方向。LPU不仅专注于推理所需的关键计算操作,还保持了极致的简单性和高效率,使得推理速度得到飞跃性提升的同时,显著降低了硬件复杂度与能耗。 推理速度是衡量AI基础设施性能的重要指标,Groq通过其LPU的架构优势,实现了毫秒级的低延迟响应和持续稳定的吞吐能力。

这对于需要实时或近实时反馈的应用场景,例如自动驾驶、金融风控、在线推荐系统和医疗诊断来说,无疑是极具竞争力的优势。Groq的技术不仅满足了高性能计算的需求,更兼顾了系统的稳定性和可靠性,确保推理流程即便在高负载环境下也能无故障运行。 在成本控制方面,Groq的基础设施也展现了其独有的竞争力。传统GPU推理平台通常因高昂的硬件费用及电能消耗,导致推理成本居高不下,制约了许多企业的AI应用部署。Groq凭借自研LPU芯片的高效能与简洁设计,显著降低了硬件采购和运营维护成本。此外,GroqCloud作为其云端推理解决方案,进一步将推理资源以服务化形式提供,减少了用户的前期投入门槛,使各种规模的企业均能享受高质量推理能力。

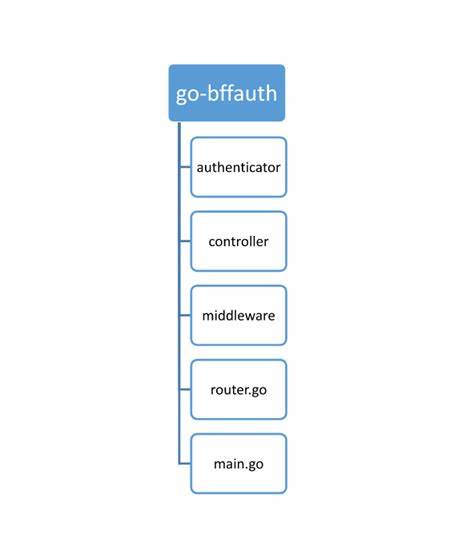

规模化部署是高效推理基础设施不可或缺的一环。Groq通过构建分布式数据中心网络,实现了推理工作负载的全球覆盖和负载均衡。其推理堆叠架构允许用户灵活扩展计算能力,应对各种复杂多变的业务需求。无论是大规模的在线服务,还是点状部署的边缘计算环境,Groq都能提供可靠且高效的解决方案,满足多样化应用的扩展需求。 Groq基础设施不仅关注硬件性能提升,更提供完善的软件生态支持。GroqCloud API兼容OpenAI接口,开发者可轻松将现有的AI模型无缝迁移至Groq平台,缩短开发周期并降低技术难度。

丰富的SDK和文档资源助力开发者快速集成和调优应用,使推理效率和用户体验达到最佳状态。同时,通过客户案例可以看出,诸如麦克拉伦F1车队等高端用户均选择Groq作为其推理方案供应商,其严格的性能要求和实际应用验证了Groq方案的行业领先地位。 Groq的成功也离不开对未来趋势的精准把握。随着稀疏专家模型(MoE)等大型复杂AI模型的兴起,传统推理架构面临巨大的压力和挑战。Groq积极优化其基础设施架构以支持这类新兴工作负载,确保在面对模型复杂度爆发时依然保持高效、经济和规模弹性。这种前瞻性的设计理念,保障了Groq推理平台在未来数年内持续保持竞争优势。

从研发角度来看,Groq不断推动硬件与软件的深度融合,凝聚跨领域的技术创新力量。其专注于推理特性的定制芯片设计,结合云端智能资源调度,形成了差异化的核心竞争力。这种创新驱动助力更多企业实现场景化的人工智能落地,加速数字化转型和智能创新的步伐。 综上,Groq基础设施以突破性的LPU芯片为核心,以云端GroqCloud为平台,构建了涵盖速度、质量、成本与规模多维优化的推理解决方案。它不仅满足了当下AI应用的高性能需求,更为未来的智能世界奠定了坚实的基础。无论是科技企业、高校研究机构还是行业应用开发者,选择Groq意味着迈向高速、经济且可持续的AI推理新时代。

随着人工智能不断深入各行各业,Groq将持续推动推理计算的边界,赋能更多创新应用,开创智能时代的新纪元。