近年来,人工智能(AI)技术的迅猛进步引发了广泛关注,特别是聊天机器人作为人工智能的重要应用之一,它们的妙语连珠和即刻回应给人留下了深刻印象。许多人甚至误以为这些智能系统已经具备了真正的理解和思考能力,能够像人类一样进行交流和分析。然而,就像著名作家特里·普拉切特在小说《Feet of Clay》中描绘的那样,这种认知往往是错觉。小说中角色萨姆·维姆斯使用的“Disorganiser”由一个渴望被利用的小鬼驱动,这个小鬼能够识别“手写文字”,但却完全无法理解内容本身,这一比喻恰当地反映了现代聊天机器人的本质。聊天机器人并不理解它们生成的语言,它们仅仅是在遵循统计学规则,将一个个词汇通过概率模型巧妙地组合起来,拼接成表面连贯的句子。这很像用乐高积木搭建建筑,每一块积木都能契合前一个,却并不了解整体的意义。

尽管聊天机器人可以生成流畅、自然的对话,提供看似合理的回答,但它们并不具备真正的推理、理解能力,也无法辨别事实与虚构。这样的局限性在教育、法律等需要严谨判断的领域特别值得关注。教师若依赖聊天机器人自动批改作业,可能会得到缺乏深度和准确性的评价结果。律师若借助聊天机器人来构建法律论证,也极有可能基于不完整甚至错误的信息进行辩护。聊天机器人的表现如同将互联网海量信息放入搅拌机,虽能输出形式丰富的内容,却无法保证内涵的真实性和合理性。科技公司所开发的语言模型,虽运用大量算力和复杂算法,却本质上仍是统计模型。

微软、谷歌、Meta等巨头投资巨资打造的这些系统,并非真正具备“智能”,而更多是人工智能炒作的“营销玩具”。不仅如此,训练这些巨型模型所消耗的能源和水资源极其庞大,造成了显著的环境影响,成为科技发展不可忽视的隐忧。聊天机器人甚至在图像识别领域表现出类似的缺陷。虽然部分AI能描述图像内容,但它们无法分辨图像中是否有人手拥有多余的手指或面部特征是否畸形。这种缺乏常识和真实理解的现状,进一步证明了当前技术的局限。人工智能带来的技术进步不可否认,但盲目崇拜和过度依赖带来的风险也不容小觑。

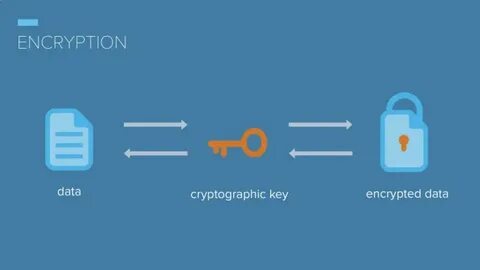

作为使用者和开发者,必须意识到聊天机器人“认知”的假象,谨慎评估其适用场景,不应将其视为具备思考能力的智能实体。教育领域尤应加强技术素养的培养,引导师生正确理解AI工具的功能与局限,避免误用导致结果失真。技术发展的最终目标应是辅助人类提升效率和创造力,而非取代人类的判断和理解。未来的AI研究需要在算法透明度、数据来源的真实性以及环境可持续性等方面努力,推动更有责任感和智慧的技术方案。人工智能的发展同时也带来了伦理和社会方面的新挑战。如何确保AI的公平性、避免算法偏见、保护用户隐私,都是亟待解决的问题。

公众应保持理性和批判的态度,提升对数据科学和人工智能的理解,避免盲目接受各种“智能”的表面现象。总结来看,聊天机器人尽管在交互体验上取得了令人瞩目的进步,但它们离真正意义上的智能仍有一段距离。正视其仅仅是“语言拼接机器”的本质,是推动这项技术健康发展的关键。未来,只有当技术开发者、使用者和社会各界共同努力,建立起科学、合理的认知和应用框架时,人工智能才能真正惠及社会,成为助力人类文明进步的有力工具。