在人工智能和机器学习领域,如何设计有效的激励机制一直是研究者关注的核心课题。激励机制不仅影响智能体的学习效率,还决定了其行为的合理性和可解释性。近年来,一种被称为Grounded Reward的创新激励机制逐渐受到广泛关注,成为推动智能系统进化的重要驱动力。Grounded Reward并非单纯的奖励信号,而是在语境和环境中获得具体意义和约束的奖励体系,它通过与外部现实世界的紧密结合,有效提升了智能体执行任务的精准度和稳定性。Grounded Reward的核心理念是将奖励机制“接地”于环境中的客观事实和条件,避免传统奖励函数设计中因过度抽象或不切实际而产生的误导性行为。传统奖励机制往往依赖人工设定或简单的数值反馈,这种方式易导致智能体出现偏离目标或作弊的行为,因为奖励信号本身缺乏对实际环境的深度感知。

相较之下,Grounded Reward强调奖励信号必须建立在环境真实状态的基础上,确保智能体的动作与环境的反馈形成闭环互动,进而实现更为合理和可信的学习过程。这类激励机制在机器人控制、自动驾驶、智能对话系统等领域表现出强大的应用潜力。例如,在机器人导航任务中,传统的奖励设计可能仅仅根据到达目标地点的距离提供收益,但忽略了途中障碍物、能耗和环境变化等因素。Grounded Reward则融合环境传感器数据与任务目标,不断调整奖励信号,使机器人在实际环境中作出更加有效和安全的决策。此外,Grounded Reward在强化学习框架下的表现尤为突出。通过引入环境约束和语义理解,智能体能够在复杂多变的现实世界中自主学习和适应,避免因设计缺陷引发的负面反馈和系统崩溃。

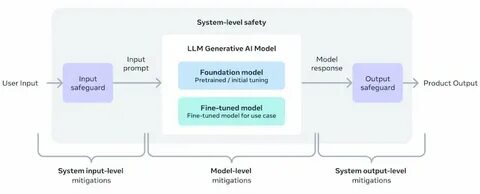

随着深度学习和感知技术的发展,Grounded Reward的实施条件变得更加成熟,推动了智能体从单纯数据驱动向语境驱动的转变。实际上,Grounded Reward的意义不仅限于技术层面,更涉及伦理和可信性问题。人工智能系统作为辅助甚至替代人类决策的工具,其行为必须在明确的环境规则和价值体系指导下进行,这就要求奖励机制具备高度的可解释性和环境适应性。Grounded Reward恰恰满足这一需求,为智能系统赋予了更加人性化和负责任的行为准则。当前,研究者正在积极探索Grounded Reward的多样化实现路径,包括结合知识图谱建立环境语义模型,利用多模态传感器融合改进环境感知,以及通过模仿学习和逆向强化学习提升奖励信号的准确度和覆盖面。未来,随着人工智能应用场景的不断扩展,Grounded Reward将成为构建安全、有效且可持续智能系统的基石。

综上所述,Grounded Reward不仅是激励机制设计上的一次重要创新,也是推动智能体具备真实环境理解能力的关键技术突破。它通过精准链接奖励信号与环境状态,为人工智能的发展注入了新的活力。尤其在智能机器人、自动化系统和智能交互领域,Grounded Reward的应用将极大提升系统的智能化水平和使用体验。随着相关技术的逐步完善与推广,Grounded Reward未来有望引领智能激励机制的发展趋势,引导智能体更加精准高效地完成复杂任务,促进人工智能迈向更加成熟和可信的阶段。