近年来,随着人工智能技术的飞速发展,强化学习(Reinforcement Learning,简称RL)作为一种重要的机器学习范式,逐渐受到研究者和产业界的高度关注。强化学习不仅在游戏领域取得惊人突破,例如AlphaGo和OpenAI Five的超人类水平表现,还在机器人控制、自然语言处理等众多应用场景展现出巨大潜力。其中,Q学习作为强化学习中的核心算法,凭借其离策略(off-policy)的特点,被视为提升样本效率、实现广泛应用的关键路径。然而,令人遗憾的是,Q学习在面向复杂、长时序决策任务时,尚未展现出良好的可扩展性,限制了强化学习在现实世界中更深层次的落地。本文系统梳理了Q学习目前面临的核心挑战,结合最新科学实验数据,分析了阻碍其规模化的根本原因,并讨论未来可能促进突破的研究方向。强化学习的可扩展性问题是近年来学术界和工业界热议的话题。

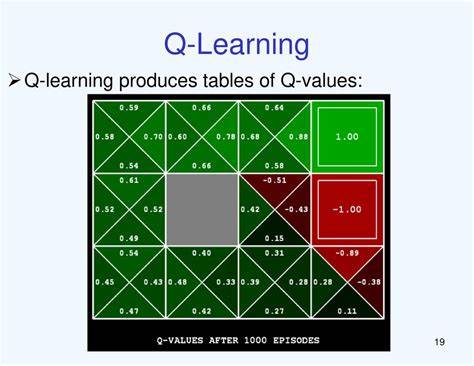

与自然语言处理中的下一词预测、计算机视觉中的去噪扩散模型及对比学习等技术相比,这些领域都已实现了数十亿甚至百亿参数模型的成功训练,并且训练目标具有高度可扩展性,能够充分利用海量数据和计算资源,强化学习确实也取得了突破性的成果。但从算法细节层面看,目前大多数广受认可的强化学习成果均依赖于在线、基于策略的算法系列,如REINFORCE、PPO、GRPO等。这类方法在训练过程中必须不断实时采样当前策略执行的轨迹数据,难以有效复用之前的经验数据,导致样本效率偏低。显然,这种特性在诸如棋类游戏及生成式语言模型训练等仿真环境中尚可接受,因可以低成本地无限生成环境交互数据;但在实世界环境中,诸如机器人手臂操控,数据采集成本极其高昂且耗时漫长,限制了相关算法的实用性和推广。Q学习则极具吸引力,因为它是一类离策略强化学习的代表,核心优势在于能够使用任何时间点、由不同策略产生的历史数据,从而实现数据的反复利用,大幅提高训练效率和降低环境交互成本。Q学习通过最小化目标函数,采用时间差分(Temporal Difference,TD)更新方式逼近最优价值函数。

这种方法使得训练过程理论上可以充分利用离线数据,但令人关注的是,Q学习的训练目标本身存在固有的偏差,这些偏差随着决策时间尺度的拉长不断累积,最终导致算法崩溃或性能严重退化。深入来看,Q学习的核心目标是最小化TD误差,即模型预测的动作价值函数Q(theta)(s,a)与由奖励r和折扣后下一步最大值Q(target)的目标之间的差距。然而,这些学习目标中的目标值本身带有估计偏差,这种偏差不是静态的,而是在每一步迭代中被不断“自我反馈”,即“偏差累积”现象。随着决策过程扩展至百步、千步甚至更长,误差的积累使得Q函数的估计变得极不准确,导致策略性能大幅下降。相比之下,在线策略梯度类方法,如广泛应用的PPO,通过多步采样策略梯度估计,偏差较小,且更擅长处理长时序依赖关系。尽管存在方差较大等问题,但其在大规模任务中表现优于传统Q学习方法。

因此,从根本机制出发,现有的Q学习算法尚未形成足够健壮的体系架构以支持复杂长时序任务的拓展。为了实证上述观点,近期的一项系统性研究专门设计了复杂、长时序的机器人操作任务集合,利用足够近乎无限的数据量以及大规模计算资源,进行严格的离线强化学习测试。该研究排除探索难度和表示学习误差等干扰因素,确保数据集覆盖充分且任务本身可解,以科学验证算法的可扩展性。结果清晰显示,典型的离线Q学习及其变体(如IQL、SAC+BC等)均难以在这些长时序任务中突破性能瓶颈。更进一步,增加数据规模和模型容量并未奏效,验证了偏差累积与长时序关联的根本性难题。这一发现对强化学习领域具有深远意义。

它不仅揭示了Q学习现阶段在实际问题中的应用局限,也反映出仅依赖大规模数据和算力无法代替基础算法层面的创新突破。令研究者欣慰的是,该研究发现,通过“时序缩短”(horizon reduction)的技术手段,可以明显缓解偏差积累带来的影响。具体方式包括引入多步回报(n-step returns)机制和层次化强化学习框架,这些方法通过减少连续TD估计的迭代次数,减缓了误差传播。实验结果表明,甚至简单的n步返回改进就显著提升了任务完成质量,而更加复杂的层次化方法在多任务和长时序环境中表现更为优越。这一发现为未来启示了新的研究方向,指出解决“时间地平线诅咒”是实现Q学习真正可扩展的核心所在。目前看来,单纯依靠传统Q学习范式难以攻克深远时间依赖问题,亟需更创新的算法设计和原理突破。

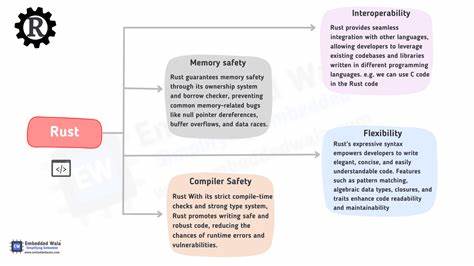

未来的潜在研究重点可能包括发展递归的、可适应多尺度层次的决策结构,实现智能体逐级分解复杂任务,甚至超越传统单步时序差分更新,实现对长期回报的有效估计。另一方面,将模型学习与强化学习结合的模型基RL展现出独特优势。因为模型训练本质上是监督学习,理论上天然可扩展,同时结合在线RL策略优化,或可规避传统Q学习偏差累积弊端,形成更稳健高效的体系。此外,利用线性规划等优化理论提出的准度量(quasimetric)强化学习以及基于蒙特卡洛估计的对比学习方法,也为提出完全不同于传统TD学习的新思路提供了可能。总的来说,随着离线数据集和复杂任务环境的日益丰富,Q学习的可扩展性问题日益凸显。科学界和产业界需携手推动算法创新,深化对偏差机制的理解,拓展层次化及模型基RL方法研究,推动强化学习迈向可处理长时序、复杂环境的大规模应用新时代。

伴随技术和理论的不断进步,未来有望见证Q学习及其变体在更广泛领域发挥深远作用,助力智能机器人、自动化系统及多模态智能代理的快速发展。