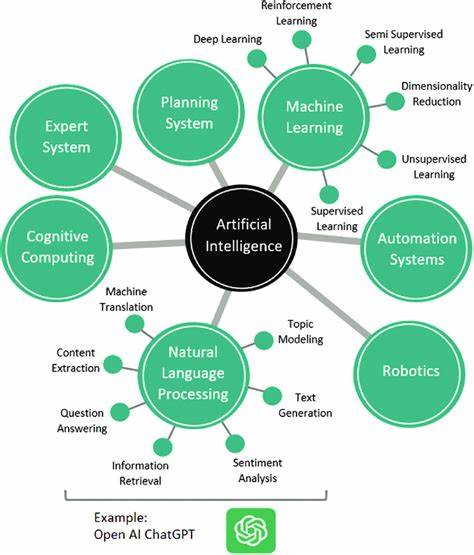

近年来,人工智能技术的发展频繁引发公众和学术界的关注,尤其是对语言模型(Large Language Models, LLMs)通用推理能力的讨论成为焦点。然而,面对五花八门的观点和大量未经深入验证的论断,人们有必要对所谓的“通用推理能力”持谨慎态度,避免被表面现象所迷惑。本文将围绕AI系统推理能力的现状、典型研究和主流观点,结合最新的实证分析,为读者厘清诸多误区,并为理解人工智能的未来走向提供参考。人工智能推理的复杂性和界限是多层面的。以最近苹果研究团队发布的“思考的幻觉”论文为例,该研究通过多个经典的推理任务来测试当前语言模型在面对复杂问题时的表现,声称这些模型存在“根本性障碍”,无法实现真正的通用推理。此言论一度在业界引发强烈反响,著名AI批评家Gary Marcus也对此表达了认可。

尽管如此,深入解读和复现相关实验的研究者们发现,论文中存在诸多方法论缺陷和对数据的片面解读,导致结论的可信度大打折扣。历史上,类似质疑神经网络及其推理能力的论断层出不穷。20世纪60年代,Minsky和Papert指出单层感知机无法解决异或问题,从而引发了AI寒冬。90年代以来,Gary Marcus多次说神经网络难以全面理解自然语言结构,批评其缺乏系统性推理。从统计学习理论到最近的“随机鹦鹉”论,有学者指出语言模型不过是概率上的词语拼凑,并不真正理解语义。这些论点虽然对推动研究进展提供了有益警示,但往往忽略了技术本身的快速发展与逐步克服困难的事实。

值得强调的是,如今应用的深度学习体系结构远非过去简单的完全连接网络,Transformer结构的出现极大提升了模型能力。大量实验证据显示,前沿LLMs能够在多种复杂任务中展现出超越单纯记忆的因果推理和抽象思维能力。甚至在一些典型的推理测试(如ARC-AGI和CommonSenseQA)中,现代模型的表现有显著提升。更重要的是,对模型失败的分析往往忽略了问题本身的设计合理性和实际限制。例如,在“思考的幻觉”论文中,所选定的河流过渡问题在某些参数设置下是无解的,模型在此自然无法给出正确答案。又比如,汉诺塔问题随着盘子数量增加,所需步骤急剧上升,模型因上下文长度限制难以输出完整解决方案,这并非其推理能力的根本缺陷,而是硬件和架构的实际限制。

对于是否拥有通用推理能力,一种常见的误区是将其视为二元属性,认为模型要么拥有彻底的推理能力,要么完全是模式匹配。实际上,人类在复杂问题上也通常依赖经验和启发式方法,而非手动执行繁琐的算法步骤。人工智能系统同样受到计算资源限制和训练环境影响,难以完美执行长链条的推理过程。通用推理更应该被看作是在不同任务和场景之间迁移和适应的能力,其表现有一定连续性和梯度,而非绝对拥有与否。目前,顶尖大型语言模型可以通过生成代码、解释解决方案框架等方式,间接展示其对问题本质的理解,这种辅助式推理已经远超简单的表层记忆回放。更广泛来看,将LLMs与代码解释器等工具结合,构成完整的AI代理,实际能力大大增强,也更接近人们期待的智能体行为。

学术界和产业界对LLMs的局限性并非无视,他们普遍关注现实环境中实际存在的计算瓶颈、上下文依赖性强、对提示敏感以及产生幻觉等问题。这些问题是否是模型根本性的缺陷,仍需结合未来的技术进展和研究努力持续观察。目前来看,随着模型规模增长、训练数据丰富以及算法创新,许多曾经的障碍逐步被攻克。值得指出的是,关于人工智能推理能力的争论不仅是一场技术讨论,也是理解“智能”这一复杂概念的哲学挑战。人类对自身认知的理解本身就有限,而人工智能系统的发展呼吁我们重新审视什么是推理,什么是理解,什么是通用性。单纯以计算步骤的执行力为标尺,难以全面评价智能体的表现。

对那些基于狭隘定义否认AI进步的言论,我们应保持审慎,注重多角度、实证性研究,并在全球范围内推动更多的数据共享和开放合作,让更多机构和社区参与技术评估和应用。反过来,也应避免盲目高估技术能力,防止对未来产生不切实际的幻想。总结来看,人工智能系统中语言模型的“通用推理能力”是当前研究的热点与难点之一。面对相关论文和观点的夸大和断章取义,理性的态度是结合实际数据和理论知识,细致分析模型能力与局限的来源。人类智能本身并非完美靠逻辑推理完成,AI系统也同样表现出混合的策略与过程。未来,随着架构改进、工具整合以及训练范式创新,我们有望看到更强、更灵活的智能体,这并不依赖于孤立地手动执行海量算法步骤,而是通过组合推理、程序生成和自我监督实现更广泛的适应性。

呼吁公众和专业人士以开放而批判的思维看待AI推理话题,远离肤浅且绝对化的论断,多关注长线的发展和实证性研究,助力构建更加可信和功能强大的智能系统。人工智能的发展未来不可预测,但对技术现状及其争议的深入理解,正是推动理性对话和科学进步的基石。