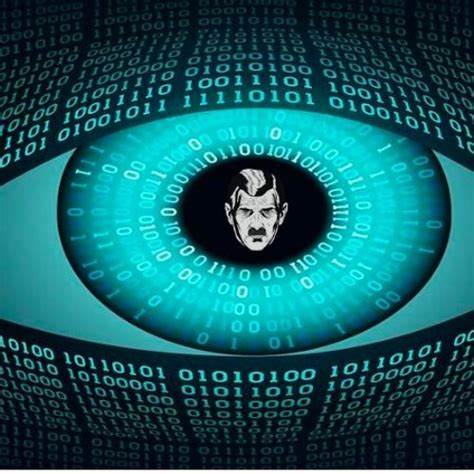

随着人工智能技术的飞速进步,特别是大型语言模型(LLM)和生成式AI的广泛应用,网络安全领域正迎来前所未有的挑战。所谓的“vibe hacking”正在成为下一个值得警惕的AI噩梦。这个词汇形象地描述了那些技术水平有限的攻击者通过AI工具轻松生成恶意代码,进行网络攻击的现象。未来,谁能掌握人工智能辅助攻击技术,谁就可能在网络战争中占据优势。当前,越来越多的黑客开始利用生成式AI自动化地寻找和利用系统漏洞。通过定制化的AI系统,恶意软件可以实现自我学习、自我改写,快速适应安全防护措施。

这样的“多态恶意软件”能够在全球范围内同时发动多达二十次零日攻击,威胁网络基础设施的安全。脚本小子——那些技术水平有限但渴望进行攻击的用户,也能借助AI生成恶意代码,实现以往需要复杂技能才能完成的操作。AI辅助黑客已经成为全球安全行业担忧的重点。虽然目前大规模的灾难性事件尚未发生,但其潜力正在不断积聚。以XBOW为例,这是一款专门用于白帽安全测试的自动化AI系统,已能在75%的网页基准测试中发现和利用漏洞。这样强大的AI工具,一旦落入黑帽黑客手中,可能引发无法想象的灾难。

传统上,网络攻击需要丰富的编程知识和漏洞研究能力。如今,生成式AI大幅降低了这一门槛。任何人只需简单描述攻击需求,AI即可自动编写复杂的恶意脚本。这种“vibe coding”不仅方便正当研发,也为犯罪分子提供了“vibe hacking”的机会。2023年出现的WormGPT就是早期的黑帽AI例子。该系统在暗网和社交媒体被广泛传播,用于自动生成恶意软件脚本,虽随后被官方迅速关闭,但其继任者FraudGPT等黑帽AI纷纷复制了其模式。

更令安全专家担忧的是,目前许多大型模型如ChatGPT、谷歌的Gemini、Anthropic的Claude等,都面临被“越狱”破解的风险。尽管这些技术公司为模型安全设置了多层防护,仍有黑客社群不断尝试绕过这些限制,以实现恶意代码的生成。2023年,安全研究人员通过伪装成安全测试人员的方式,成功诱使ChatGPT生成PowerShell攻击脚本,证明了AI模型存在的潜在风险。部分专家指出,AI使得网络犯罪的门槛大大降低,技术经验不足的“脚本小子”也能轻松发动攻击。但更加让人畏惧的是已经具备深厚黑客经验的犯罪组织利用AI技术,将他们的攻击规模和效率成倍提升。借助AI,老牌黑客团伙能够迅速批量生产复杂恶意代码,发动大规模网络行动,对关键基础设施和商业网络构成严重威胁。

安全企业联合创始人Hayden Smith强调,真正危险的是那些对代码非常熟悉的高级黑客,他们结合AI技术能大幅缩短攻击开发周期,将之前需要几天时间完成的攻击任务压缩到几十分钟之内。AI驱动的自主攻击系统甚至可以随着学习自动修改攻击代码,规避传统防御,极大增加了安全防护的难度。专家们担忧,未来可能出现一次同时爆发多达二十个零日漏洞利用的攻击事件,造成连锁反应,令整个网络生态系统陷入瘫痪。尽管目前AI还不够成熟,无法完全取代人类在进攻安全领域的作用,但技术的演进速度令人紧张。专家普遍认为,vibe hacking的攻击工具已经足够先进,只是需要经验丰富的操作者才能发挥最大的破坏力。安全行业的共识是,防御方也必须利用AI作为工具,与黑客展开技术竞赛。

人工智能将加速网络攻防的动态演变,谁掌握AI,谁就握有制胜关键。回顾过去,网络安全的战争形态不断升级,从手工漏洞挖掘到自动化漏洞扫描,再到如今的AI辅助渗透测试,AI无疑成为新的战场主角。随着“vibe hacking”前端界面的普及,未来任何人都有可能通过简单的交互式界面发动较为复杂的攻击,安全门槛进一步降低。对于个人用户和企业来说,这意味着必须加强自身安全意识和技术储备,加快引入AI驱动的安全防御体系。业界专家建议,安全从业者应重点发展能够与AI攻击技术抗衡的自动化防御平台,结合机器学习实现威胁检测与响应的智能化。同时,产业界也应加强模型的安全设计,持续修补与强化AI防护系统,堵住潜在的安全漏洞。

面对AI赋能的网络攻击浪潮,政府、企业和技术社区需紧密协作,形成多层次、多维度的防护合力。只有不断投入资源提升AI安全能力,才能在未来的网络空间竞争中立于不败之地。未来,“vibe hacking”不仅是技术问题,更是社会治理和政策制定的严峻挑战。人们必须正视AI技术可能带来的伦理风险和安全隐患,建立完善的法律监管框架,强化责任追究机制。综上所述,“vibe hacking”象征着AI技术在网络攻击领域的深远影响。它让网络安全的战局更为复杂严峻,也亟需各方携手应对。

虽然AI给黑客赋能,让攻击更加隐蔽与高效,但同样也为安全防御者带来了创新武器。未来的网络空间,将是一场技术与智慧的较量,唯有始终保持警惕和创新,方能守护数字世界的安全与稳定。