在当今分布式系统快速发展的时代,如何保证多个节点之间的协调与同步成为关键难题。谷歌的Chubby锁服务应运而生,作为一种继承锁语义的分布式协调解决方案,广泛应用于谷歌内部诸如Google File System(GFS)和BigTable这样的核心系统。Chubby的出现不仅改善了分布式环境中的资源共享与控制,更为开发者提供了简洁高效的接口,促使复杂的分布式协调变得可操作且易于理解。Chubby并非针对高频率短时锁定设计,它更倾向于支持粗粒度锁,即锁的持有时间可以是数小时甚至数天,而并非几秒钟。正因如此,Chubby的典型应用场景是多应用之间的主节点选举机制——第一个获得锁的客户端即被视为主节点。谷歌团队选择以锁服务替代直接使用Paxos共识算法的设计初衷,涉及多个方面。

首先,对开发者友好至关重要。相比Paxos这样的共识机制,锁语义更直观,易于嵌入应用逻辑,降低开发和维护难度。其次,分布式应用通常需要处理少量关键数据的一致读写需求,锁机制能够自然地支持这一点。更为重要的是,基于Paxos的系统需要大多数节点正常工作才能继续操作,而锁服务只需确保锁授予客户端在线,就能保证应用进程的正常执行。经过综合考量,Chubby被设计为支持粗粒度锁、少量数据存储和通知机制的服务,能够支持成千上万的客户端同时观察并响应变更。它还通过客户端缓存减少对主服务器的压力,并确保缓存的一致性,简化了开发工作。

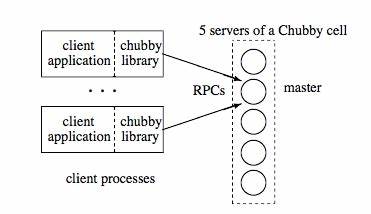

Chubby的系统架构由两个主要组件构成:Chubby主服务器和Chubby客户端库。后者集成于应用程序,代表应用执行锁协议。主服务器由多个副本组成,其中通过分布式共识算法(如Paxos)选举出唯一的主节点并授予租约。主节点负责处理写请求并将其持久化,同时通过多数副本复制以保证数据一致性和系统容错。读请求则由主节点在租约有效期内直接响应。客户端通过DNS查找当前主节点,并将请求转发至该主节点。

主节点和客户端之间保持持续的会话,以确保锁状态和通知能够及时传达。Chubby采用类Unix文件系统兼容接口,文件和目录统称为“节点”,提供永久和临时节点两种类型。临时节点随着客户端断开连接自动清除,保障锁资源的及时释放。节点带有丰富的元数据,包括实例编号、内容生成编号和锁生成编号,方便系统追踪节点状态及锁的变化。锁是一种建议式机制,意味着持有锁的应用需要遵循协议,但系统并不强制阻止其他访问。为了防止锁持有者异常退出导致数据不一致,Chubby引入了锁延迟机制。

在锁持有者无故中断时,系统会设定一段时间的锁延迟,避免新客户端立即获得锁,从而保护数据完整性。与此同时,Chubby支持序列号机制,客户端可请求由主节点分配的包含锁名和生成编号的序列号,用于验证锁的有效性,提升分布式事务安全性。Chubby同样实现了事件机制,方便客户端订阅文件内容变化、子节点添加、新主节点选举等重要事件。当文件内容变化时,相关服务能够同步更新其节点地址或状态,确保系统实时感知主节点等关键信息的变更。此外,Chubby的客户缓存支持强一致性读,通过服务器端主动通知客户端失效缓存,保证数据同步且提高读取效率。值得一提的是,客户端与主节点之间的连接通过KeepAlive调用保持活跃。

每个KeepAlive调用响应中还可携带状态更新,比如缓存失效通知。该设计不仅提高通信效率,还解决了防火墙穿透和端口监听等实际问题,使分布式协调更加稳定和安全。会话管理是Chubby可靠运行的关键环节。KeepAlive RPC创建会话并授予客户端租约,租约确认主服务器不会单方面关闭该会话。客户端本地维护略小于主服务器的租约时间,若租约将过期且未收到主服务器回应,客户端进入“风险期”,并禁用缓存以防止错误访问。在风险期内若收到回复,则恢复正常,否则终止会话并通知应用。

主服务器故障和租约过期是最具挑战性的事件。新主服务器选举后必须重建客户端会话状态,针对客户端发来的KeepAlive请求进行严格检验,保障一致性的基础上逐步恢复对外服务。在恢复过程中,主服务器通过事件通知客户端缓存失效情况,使客户端彻底同步系统状态。整个切换过程设计细致且复杂,但确保了分布式协调服务的稳定与高可用。总结来看,Chubby通过简洁的锁服务接口和健壮的系统架构,有效解决了分布式环境中复杂的协调问题。其基于租约和事件机制的设计既降低了应用开发难度,也保证了系统的可靠性和扩展性。

Chubby的案例证明,适度的集中式协调机制在大规模分布式系统中依然具有不可替代的价值,为构建稳定、高效的分布式应用提供了宝贵经验和技术基础。未来,随着分布式系统需求的多样化和复杂度提升,类似Chubby的锁服务将持续演进,推动分布式协调走向更加智能化和自动化的新阶段。