随着人工智能和高性能计算的迅速发展,GPU作为核心计算单元的重要性日益凸显。AMD凭借其先进的MI300X GPU,在高性能AI推理和训练领域树立了强有力的竞争优势。为推动这类计算平台的实际应用效率,深入了解不同运行环境和GPU资源利用方式对性能的影响成为关键课题。本文围绕三个核心话题展开:裸机运行与容器化的通信性能比较、AMD GPU的分区技术对内存带宽及推理性能的影响,以及实际应用场景中分区模式的利弊及优化方向。 首先,关于运行环境的性能对比,容器技术作为轻量级虚拟化解决方案,因其灵活性和可移植性在AI推理和训练中广受欢迎。然而,业内普遍存在对容器化架构中跨节点通信性能损失的担忧,尤其是在高带宽需求的分布式训练任务中。

基于此,研究团队对比了在AMD MI300X多节点配置下裸机环境和容器环境的网络互联性能,采用了关键的通信操作RCCL集体操作(如AllGather和AllReduce)以及底层RDMA写入性能测试。 大量测试数据显示,容器环境中AllGather和AllReduce操作的通信带宽几乎与裸机保持一致,无论消息规模从数MB到数GB都有极高的吞吐表现,峰值带宽达到350 GB/s的水平。底层RDMA写入测试更是证明双向带宽在两种环境间几无差异,从微小数据包到大规模数据传输均表现稳定。这证明容器的抽象层并没有对AMD GPU的互联通信性能产生可见的负面影响,验证了容器技术可以成为AI大规模分布式部署的首选方案,摒弃了“容器税”的误区。 接下来,探讨AMD MI300X GPU的分区技术及其对性能的实际影响。该GPU支持将单个强大GPU划分为多个独立分区,这能增强内存带宽利用率,理论上有助于提升小规模任务的并行处理能力。

研究人员通过设置NPS4模式,将MI300X分成四个分区,比较了每个分区与未分区的整体GPU在不同数据规模下的内存带宽表现。 实验结果显示,单个分区在隔离条件下确实提供了更优的内存带宽表现,尤其是在32MB至128MB的数据区间,内存带宽明显高于未分区模式。此结果与AMD官方此前发布的内容吻合,强调分区能提升单独微基准测试的带宽效率,但这只是整体性能表现的一部分。 实际应用角度,研究进一步测试了分区模式下的推理性能,尤其关注数据并行和张量并行场景。数据并行推理中,研究利用8个独立vLLM实例分别运行在8个分区上,评估其综合吞吐能力,并与单个完整GPU上的单一vLLM实例进行对比。结果显示,单GPU整体性能明显优于分区合计,且这个差距随着请求频率上升更为显著。

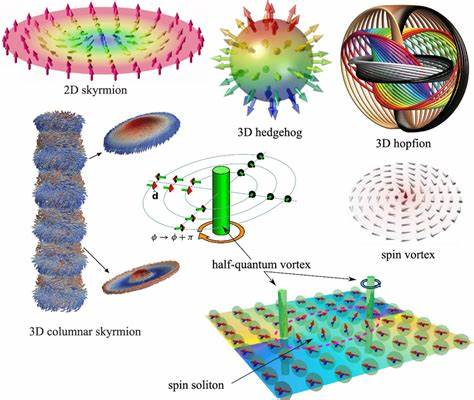

主要瓶颈来自于分区内存资源受限,每个分区只能使用部分HBM显存,难以高效缓存关键KV数据,导致整体吞吐下降。 在张量并行的模拟测试中,单GPU SPX/NPS1模式同样明显优于多分区的CPX/NPS4模式合计。性能差距源于多个分区之间同步操作的开销,尤其是AllGather这类关键集体通信带来的通信延迟和资源竞争削弱了并行效率。这揭示即使分区带来了理论上的带宽优势,在涉及分区间协同工作的复杂任务中,通信成本成为制约性能的关键因素。 综合来看,GPU分区技术在微基准测试阶段展现出显著的内存带宽提升,但在需要多个分区协同完成高强度推理任务时,会被显存限制和通讯开销所拖累。在实际部署中,分区技术更适合于运行多个轻量级的独立任务,支持开发、测试和小规模模型的并行执行。

对于追求极致性能的重负载AI任务,动态切换回未分区的整块GPU模式能够最大化硬件潜力。 研究还指出,本次基准测试环境网络配置采用了默认设置,相关RCCL和RDMA性能略低于厂商报告的峰值,意味着通过进一步调优网络拓扑、包大小、以及环境变量,仍有性能优化空间。同时,文中附带的完整测试步骤和代码已开源,方便行业从业者重复验证和改进。 此次对AMD MI300X GPU在裸机、容器及分区多种模式下的性能基准,不仅澄清了容器部署中不存在性能惩罚的现实,也揭示分区技术在AI实际工作负载中的适用场景及其局限性。随着AI计算需求的持续增长,合理利用容器的灵活性并结合智能动态分区策略,将成为提升GPU资源利用率和运算效率的重要趋势。拥抱开放生态中的工具链,无论是MPI、RCCL还是高效的网络协议,都是构建稳定高效大规模GPU集群的基石。

展望未来,进一步研究将聚焦虚拟机环境与裸机运行间的性能差异,以量化虚拟化带来的延迟和开销,助力云端AI推理和训练平台的持续进化。同时,深入优化GPU互联通信协议和分区内存管理策略,将推动AMD GPU在多任务复杂AI算力调度中的表现更上一层楼。通过本文提供的详实数据和实现参考,AI系统架构师和开发者可获得切实可行的部署指导,为高效运行AI模型提供坚实基础,推动行业迈向更高效、更可扩展的计算新时代。