近年来,人工智能技术快速发展,尤其是大型语言模型在编程辅助领域的应用逐渐普及。许多AI公司和开发工具提供商纷纷宣称,利用AI编写代码能够显著提升程序员的生产效率和代码质量,为软件开发行业带来革命性变革。然而,一项由METR(模型评估与威胁研究)团队进行的随机对照试验却给出了不同的视角。研究指出,熟练的开源软件开发者在使用现有AI工具完成编码任务时反而比传统方法花费更多时间,效率降低了19%。这一结论不仅挑战了业界对AI助力开发岗位的普遍认知,也揭示了当前AI技术在实际应用中的显著局限性。该研究招募了16名经验丰富的开发者,这些开发者长期参与维护历史悠久、代码量超过百万行的开源项目。

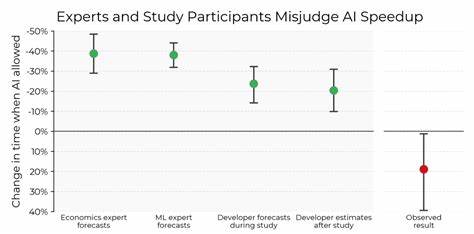

研究设计了246个涵盖修复Bug、增加新功能以及代码重构等多样化任务,半数任务使用AI工具如Cursor Pro和Anthropic的Claude辅助,其余任务则完全不使用AI。为确保实验组与对照组任务难度均衡,研究者基于任务预期耗时进行了合理分配,并包含了对代码评审反馈的修正时间。令人意外的是,尽管开发者在事前普遍预计AI辅助可以缩短24%的工作时间,事后还普遍认为AI提升了约20%的效率,但客观数据却显示,AI辅助任务的完成时间实际比无AI辅助任务慢19%。深入分析屏幕录像资料后发现,AI工具的使用显著降低了开发者在主动编码、调试以及信息查找上的直接投入时间,这似乎表明AI确实在部分环节节省了人力成本。问题的关键在于,这些节省的时间被用来进行大量的AI提示设计、结果等待以及输出内容的仔细审查和修改所抵消。此外,还有不活跃或空闲的系统操作时间,进一步拖慢了整体效率。

开发者手动接受的AI生成代码占比不足44%,多数情况下需要自行更改以契合项目的具体要求和代码风格。研究显示,用于审查和修改AI输出的时间在AI辅助任务中占据了9%的总时长,成为不可忽视的时间开销。相比于先前以代码行数或者提交次数衡量效率的大多数实验,METR的研究采用了更贴近真实工作环境的评价指标,着重考虑了任务完成质量和开发者实际时间消耗,因而得出了更加严谨和现实的结论。研究团队指出,许多现有实验往往依赖于合成任务或算法可量化的问题,缺乏对大型复杂代码库的深入测试,导致结果难以直接推广至现实开源项目。对于平均存在超过十年、包含百万行代码的复杂代码库,AI工具难以捕捉隐性知识和背景上下文,尤其是在代码设计约定、文档规范、测试覆盖率和代码格式等高质量要求方面表现尤为有限。相较之下,长期熟悉这些代码库的开发者能够更加高效地理解和应对任务需求,体现出人类经验和认知优势。

研究人员因此提出,当前AI编程工具更适合应用于结构较为简单、隐含约束较少的代码环境,而在高标准、高复杂度的开源软件维护场景中,AI的助力效果尚未达到预期。此外,实际工作中存在的提示工程复杂性、模型响应延迟和对结果准确性的反复验证,也极大增加了开发者的负担。尽管如此,研究团队展望未来,随着AI技术的多方面改进与迭代,提高模型的可靠性、减少延迟、增强上下文相关性和输出准确性是可能实现的突破方向。例如通过“提示脚手架”技术和微调使模型理解特定项目的隐式知识,或是利用更先进的模型版本如最新发布的Claude 3.7以实现核心功能的高效自动化完成,均为切实可行的优化路径。这一研究成果为行业和开发者敲响警钟,提醒大家勿盲目高估当前AI编程工具的能力,应结合项目实际情况和技术成熟度合理使用。与此同时,它也激励AI产品研发者继续致力于解决现实应用中的瓶颈,将人工智能真正发展成为程序员高效的生产伙伴。

随着AI算法和应用场景不断丰富,未来软件开发流程有望出现全新范式,既保障代码质量,又提升开发效率,实现人机协作的良性循环。作为开发者,应理性看待目前AI工具的优劣,结合自身经验灵活调整工作方式,同时关注行业动态和技术进展,把握时代赋予的变革机遇。总的来说,这项针对开源开发环境的实证研究表明,AI工具的普及并非立竿见影地带来效率提升。高复杂度项目仍需人类开发者的敏锐判断力和深入理解,而通过持续完善AI技术生态和增强工具智能化程度,未来AI辅助编程仍有望扭转当前的不利局面,助力软件开发事业迈向更加高效的新时代。