近年来,人工智能(AI)技术的飞速进步极大地推动了各行各业的数字化转型。然而,随着大型语言模型(LLM)和多智能体系统的广泛应用,一个新型的安全威胁——Prompt Injection 2.0——也逐渐走入公众和专业领域的视野。它以独特的方式结合传统网络安全漏洞,如跨站脚本攻击(XSS)和跨站请求伪造(CSRF),形成了更为复杂的混合攻击,威胁着基于AI的应用系统的安全防护。Prompt Injection 2.0并非单纯的恶意输入,而是通过巧妙设计的提示词和指令,诱导AI系统忽视原本设计的规则,执行攻击者设定的非法操作,甚至通过多步骤、多智能体协调完成复杂的恶意任务。这种攻击手段突破了传统安全工具如应用防火墙和XSS过滤器的防线,成为当下网络安全领域不可忽视的新型风险。Prompt Injection的起源可以追溯到2022年,当时Preamble公司首次发现并向OpenAI负责披露了这类攻击方式。

此后,随着LLM被广泛嵌入各类应用,攻击手法不断演化,形成了Prompt Injection 2.0,其核心区别在于攻击策略的多样性和融合性。不同于早期仅靠文字提示欺骗AI,现今的攻击结合网络攻击技术,触发AI协同执行更深层次的入侵行为。当前,Prompt Injection 2.0的威胁尤为显著在于其多智能体框架中攻击链环,攻击者可以利用AI系统自动调用多个工具和访问不同权限,实现持久渗透和横向移动。这种多阶段、多维度的攻击设计,使得检测和阻止变得极为困难。传统的网络安全机制面对这类创新威胁显得力不从心。Web应用防火墙(WAF)、XSS和CSRF防护等面对AI驱动的复杂逻辑攻击时,效果大打折扣。

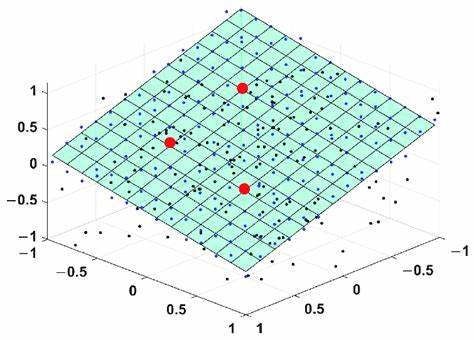

研究表明,当攻击者利用AI产生的模糊指令或隐蔽提示,传统规则基的过滤器难以准确识别。此外,Prompt Injection 2.0能够通过动态执行环境及多智能体交叉验证,实现逃避检测,进一步强化了攻击的威胁程度。针对这一新兴挑战,学界和业界开始倡导全新的安全架构设计。论文《Prompt Injection 2.0: Hybrid AI Threats》提出了一套复合防御框架,强调通过提示词隔离、运行时安全监控和权限分离来实现对AI系统的全方位保护。提示隔离技术能够防止恶意输入直接影响核心模型推理过程,减少误导风险。而运行时安全则通过实时行为分析,及时捕获异常指令执行,动态阻断潜在攻击行为。

权限分离策略将AI访问的敏感资源进行最小化授权,避免攻击链利用高权限进行破坏。此外,研究者们还构建了开放源代码的测试工具包,为安全研究者和开发者提供了便利的攻击模拟和防御验证平台。通过模拟多种Prompt Injection场景,开发团队可以更加直观地理解攻击机理,针对性地改进安全防护措施。开源工具的推出不仅推动了安全技术的进步,也促使更多企业和个人意识到Prompt Injection 2.0的潜在风险,并主动加强安全防护投入。面对Prompt Injection 2.0带来的威胁,企业在实际应用中应高度重视AI系统的安全设计。在模型集成阶段,应建立严格的输入验证机制,综合使用自然语言处理(NLP)技术识别可疑提示。

此外,运行环境的安全策略同样关键,需要动态监控AI模型的行为轨迹和调用上下文,及时发现异常并响应。安全团队要通过持续的威胁情报共享,关注最新的Prompt Injection攻击样本和攻击手法,提升对未知攻击的应对能力。同时,多智能体系统的设计者需强化代理之间的身份验证和访问控制,避免被恶意注入信任链条中。随着AI驱动技术在医疗、金融、自动驾驶等关键领域的广泛应用,Prompt Injection 2.0的危害不容忽视。它不仅可能导致信息泄露,影响隐私保护,更可能引发系统功能紊乱和业务中断,造成重大的经济和社会影响。因此,加强Prompt Injection 2.0相关的科研投入和标准制定,构建多层次、多维度的安全防护体系显得尤为重要。

未来,随着AI技术的不断进步,Prompt Injection攻击模式还将持续演化。跨领域的协作、先进的AI威胁检测技术以及具备适应性的安全架构将成为防御的关键。通过开放合作,分享攻击样本和防御经验,形成统一而高效的安全生态,才能有效抵御这一新时代的混合型人工智能威胁,为数字化社会的安全发展夯实根基。