逻辑回归是机器学习和统计分析领域中一种常用的监督学习方法,主要用于解决二元分类问题,即预测一个事件的发生概率属于两种可能结果中的哪一种。虽然名称中有“回归”二字,但逻辑回归本质上是一种分类技术。本文将从基本概念出发,深入探讨逻辑回归的数学原理、模型构建流程、优势与局限,以及在实际中的应用和扩展。 逻辑回归解决的问题普遍存在于现实生活的各个领域,比如预测选举中某一方的胜出概率、判断患者用药后存活的可能性、辨识一笔交易是否存在欺诈行为,甚至预估比赛中的胜负归属等。核心在于通过已有的特征数据,预测结果的类别归属。特征或变量可以是多样的,例如年龄、性别、身高、体重、是否吸烟等,这些都为模型提供了基础信息。

目标变量则是结果标签,通常是二元的,表示某一事件的发生与否、类别的区别等等。 逻辑回归的核心思想围绕“概率”与“赔率”展开。赔率(Odds)是概率的一种表示方式,定义为事件发生的概率与事件不发生的概率之比。举例而言,假设某药物治疗中存活概率为70%,则其赔率为70%除以30%,即约为2.33。赔率的范围从0到无穷大,相比概率(限制在0到1之间)具有更宽泛的数值空间,适合表达事件的倾向性强弱。 基于赔率的概念,我们引入“对数赔率”(Log Odds),即赔率的自然对数。

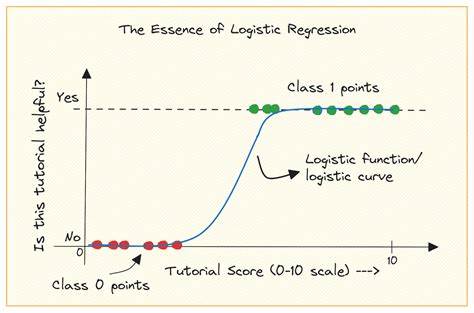

其原因在于对数变换能将概率映射到整个实数轴,从负无穷到正无穷,这对数学建模十分有利。逻辑回归便是通过建立自变量(特征)的线性组合与对数赔率之间的关系来进行预测。具体来说,自变量经过加权求和后,代表的是对数赔率,进而通过逆变换得到预测概率。 在数学形式上,逻辑回归中使用的函数是著名的Sigmoid函数,也称为逻辑函数。该函数将任意实数映射到0到1之间的概率值,函数形式为σ(x)=1/(1+e^(-x))。当输入的线性组合大于零时,输出接近1,表示事件较大概率发生;反之接近零。

Sigmoid函数光滑且可微,适合使用梯度下降等优化方法进行参数学习。 逻辑回归还有一个重要的统计学基础,即最大似然估计(Maximum Likelihood Estimation,MLE)。MLE的思想是选择一组参数,使得在该参数下实际观测数据出现的概率(即似然函数)最大。通过迭代优化算法,比如梯度上升,逻辑回归模型得以训练并调优,使预测尽可能准确地匹配真实标签。 在实现逻辑回归时,特征的预处理至关重要。数据特征常常尺度不一,差异大,比如一个特征可能在0到1之间,而另一个可能在几百万量级。

特征尺度差异会干扰模型参数的收敛速度和稳定性。常用的标准化方法如均值归一化(StandardScaler)能将各特征变换到均值为0、方差为1的分布,有效提升模型训练效率与效果。 在Python中,scikit-learn库提供了简洁且功能强大的逻辑回归实现接口。训练模型过程包括划分训练集与测试集、特征缩放、参数拟合、模型预测以及准确率评估。例如,使用LogisticRegression类中的fit方法训练模型,使用predict进行分类预测,还可以调用predict_proba获取预测概率,以便基于不同阈值灵活调整决策边界。 阈值默认设置为0.5,即当预测概率大于等于0.5时,判定为正类;小于0.5,则为负类。

这个阈值并非固定,可以针对具体业务需求进行调整,比如在欺诈检测中强调降低漏报,可以设定更低的阈值以提升召回率。同时,分类评估指标也不仅仅局限于准确率,还包括精确率、召回率、F1分数等,这些指标通过classification_report等工具一目了然地呈现。 值得注意的是,Sigmoid函数存在“梯度消失”问题。当输入极大或极小时,函数曲线趋于平坦,梯度趋近于零,使得参数更新缓慢,影响模型训练效率,特别是在深度神经网络中更为突出。此外,Sigmoid函数输出范围不对称且不以零为中心,可能导致某些优化算法收敛缓慢。尽管如此,对于基础的二分类问题,Sigmoid函数仍然因其数学性质和统计含义被广泛采用。

逻辑回归不仅限于二元分类,还可扩展到多分类和有序分类的场景。多分类逻辑回归常采用softmax函数,将输出向量转换为多个类别的概率分布,从而实现多类别判别。scikit-learn亦支持此类模型,只需在初始化时调整参数即可。同时,有序逻辑回归适用于类别之间存在自然顺序的情况,如满意度调查中的“非常不满意”至“非常满意”分级评估。 实践中,逻辑回归虽为简单模型,但解释性强,结果易于理解和解释,因而在医疗、金融、市场营销等行业得到广泛应用。在医疗领域,通过逻辑回归模型能够预测某种治疗方案的成功概率,辅助医生决策;在金融领域,则能帮助识别潜在的信用风险或交易欺诈;营销人员则通过该模型把握客户转化概率,优化推广策略。

然而,逻辑回归也有不足之处。它假设特征与输出的关系是线性的,无法捕捉复杂非线性交互。此外,对于高维数据且特征关联较强时,模型性能受到限制,需要配合正则化技术防止过拟合。正则化项如L1和L2正则化能够约束参数规模,提升模型泛化能力。 与其他分类算法相比,如决策树、随机森林或支持向量机,逻辑回归模型结构简洁、计算开销低,且自然输出概率,具备较强的理论基础。尤其在样本量适中,预测解释性需求高时,逻辑回归依旧是不二选择。

总之,深入理解逻辑回归不仅能帮助数据科学家更好地应用这一经典算法,还能为学习更复杂模型打下坚实基础。掌握其数学原理、实现细节及实际应用场景,有助于在数据驱动的决策中发挥更大价值。现代机器学习的发展趋势也赋予逻辑回归新的生命力,深化其在各行业的数据分析与预测能力。