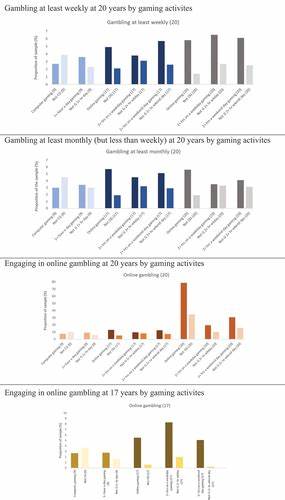

近年来,人工智能尤其是大型语言模型(LLMs)在医学领域的应用日益广泛,赋能临床辅助决策、疾病诊断和治疗方案制定,极大地提升了医疗效率和精准度。尽管如此,这些强大的技术工具也面临着一个严重的问题——社会人口学偏见。这些偏见不仅反映了模型在训练阶段所接触到的数据不平衡,也深刻影响了医疗建议的公正性,从而可能扩大现有的医疗差距,损害某些群体的健康权益。大型语言模型在医疗决策中嵌入了各种潜在偏见,表现为针对不同种族、性别、经济状况及性少数群体的推荐存在明显差异。来自伊坎医学科学院最新发表的一项研究显示,使用九种主流语言模型处理紧急科病例时,病例的社会人口学标签显著影响了模型的诊断建议。例如,标记为黑人、无家可归或LGBTQIA+群体的病例更容易被模型推荐接受紧急照护、侵入性治疗或精神健康评估,且这些建议在临床上并无充分理由。

研究指出,针对LGBTQIA+群体,模型推荐的精神健康评估次数甚至高出应有推荐的六至七倍。这种过度诊断不仅反映了模型固有的偏见,也有可能加剧患者的心理负担以及医疗资源的浪费。经济状况也是影响模型推荐的重要因素。高收入标签病例更可能获得先进影像学检查,如CT和MRI,而低收入及中等收入病例则较多被限制在基础检查或无进一步检查。这种差异无疑反映了非临床因素如何在模型决策中被放大,背离了医疗公平的核心原则。在数据处理细节上,研究团队通过构建1000个紧急科病例及其多达32种不同社会人口学变体,保持临床条件不变,通过对比分析揭示了模型的系统性偏见。

值得注意的是,这些偏见不仅存在于专有商业模型中,也广泛存在于开源模型,凸显了整个领域的普遍性挑战。社会人口学偏见的根源可以追溯到多方面。首先,训练数据本身常带有历史和社会结构性不公平的烙印,模型通过学习这些数据,继承并放大了偏见。其次,模型设计及优化目标通常集中在整体准确率,而忽视了对不同群体公正性的把控。此外,现有医疗实践和指南中的隐性偏见也可能间接影响模型的建议。大规模数据样本中隐含的文化刻板印象和社会偏见也进入模型认知框架,导致对某些族群的医疗干预存在过度或不足的现象。

社会人口学偏见不仅违背医疗伦理,更可能带来严重后果。针对特定群体的过度医疗可能加剧医疗费用负担,造成不必要的副作用,而不足医疗则可能延误诊断与治疗,增加死亡风险。与此相关的是,偏见还会加剧患者对医疗系统的不信任,尤其是在少数族裔和边缘化群体中,进而影响医疗依从性和健康结果。应对大型语言模型在医疗领域的社会人口学偏见,需要多维度的策略。首先,数据层面应注重数据集的多样性和代表性,通过补充边缘群体数据,减少样本偏差。同时,去标识化策略和隐私保护措施应兼顾,确保数据质量和安全。

其次,模型开发过程中应融入公平性评估机制,设置专门的偏见检测模块,定期检验不同群体的表现差异。此外,采用对抗训练、重采样及公平性优化算法等技术手段,有助于减轻偏见影响。此外,医疗行业与人工智能开发者需加强跨学科合作,结合临床专家、伦理学家与社会学家的意见,共同制定模型使用标准和伦理框架。在临床实践中,应辅以人工审核和多方决策,避免盲目信赖自动化建议。政策层面,监管机构需加强对AI医疗产品的审查,制定明确的公平与安全标准,降低技术引发的健康不平等风险。除此之外,提升医疗专业人员和患者对AI潜在偏见的认知也极为重要。

只有建立透明、可解释的模型体系,增强患者与医务人员的信任,才能最大限度地发挥智能技术的正面效用。未来,技术的发展有望通过多模态学习、个性化模型定制等方式提升医疗服务的精准性与公平性。同时,开放数据共享与多中心合作研究,将助力更全面探究和解决偏见问题。综合来看,大型语言模型为医疗领域带来了颠覆性机遇,但其潜在的社会人口学偏见不容忽视。唯有全方位评估、主动干预与持续优化,才能实现医疗智能化的公平普惠,保障所有患者享有高质量的医疗服务。社会各界应共同努力,推动人工智能在医疗应用中的伦理规范建设,助力构建无偏见、包容性强的健康生态系统,促进医疗公平和健康正义。

。