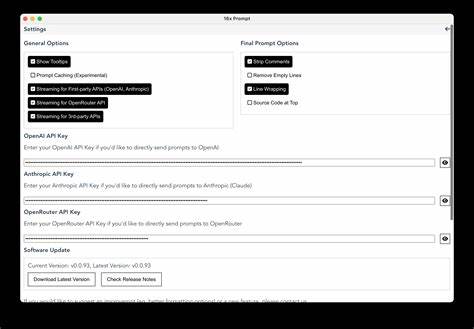

随着人工智能技术的飞速发展,尤其是大语言模型(LLM)的广泛应用,如何提升模型的回答质量和用户体验成为开发者和研究者关注的焦点。传统上,针对LLM的提示词(prompt)设计往往是个充满试错的过程,开发者需要手动调整和微调提示词,反复测试其效果,耗费大量时间和精力。而这种过程通常缺乏系统化的数据支持,导致许多决策基于主观感受,难以评估提示词策略的真实优劣。正是在这样的背景下,OpenRouter应运而生,结合了提示词A/B测试的理念,开发了一款API工具,旨在让开发者通过科学的方法来管理和优化提示词配置,从而快速确定最佳提示词方案,提高LLM的实际表现。OpenRouter的核心功能在于其支持在多个提示词版本间进行自动切换,并根据用户反馈进行评分,从而形成一个动态优化机制。不同于传统的单一提示词硬编码方式,OpenRouter允许开发者上传多组变体提示词,并通过实时收集用户互动结果判断哪种提示词更适合特定场景。

简而言之,OpenRouter将提示词的设计过程变成了一个数据驱动的、可量化的实验,通过科学测试帮助开发者告别盲目调整,降低迭代成本。用户可以将OpenRouter集成到自己的应用中,后台则利用A/B测试框架对多组提示词进行不断比较,系统自动计算各版本的表现数据。只要用户对模型回复进行简单的好的/差的评分或通过行为指标反馈,平台便能迅速推断出哪个提示词效果更佳,并逐步锁定最终使用的提示词。此外,系统还支持引入新的测试提示词,形成持续迭代,不断优化提示质量。这套机制不仅提升了开发体验,也有望帮助广大AI产品减少因提示词设计不当导致的用户流失和交互效率问题。对于许多AI开发者来说,最大的痛点之一就是缺乏有效的提示词性能评估方法。

通常,提示词微调需要在有限样本中人为测试,有时因测试数据量少或厨具偏差,难以获得代表性结论。而OpenRouter通过大规模收集用户交互数据,提炼量化指标,提供了一个更客观且动态的优化方案。由此来看,这个工具在提升产品竞争力和用户满意度方面有很大潜力。然而,提问者也坦言目前自己制作这套工具主要是解决个人“痒点”,不确定其商业化前景。虽然有意愿升级为包含用户账户和计费功能的完整平台,但回归市场需求,是否真有足够用户群体认可并愿意付费使用,是一大考量点。从技术趋势上看,随着AI技术普及,越来越多企业和开发者需要快速迭代模型表现,而提示词设计仍然是关键突破口。

能够系统支持提示词A/B测试的工具恰好填补了市场这一空白,尤其是对于那些没有大量数据科学家资源的小团队来说尤为有价值。将来如果能结合更加智能的自动化提示词生成、反馈分析算法,OpenRouter的产品形态和适用场景将更加广泛。同时,其形态也能延伸为完善的提示词管理平台,不再只是简单测试工具,而是支持多项目管理、团队协作、数据可视化、权限控制乃至与下游模型训练环节结合的一站式解决方案。不过,从商业路径和用户接受度来看,OpenRouter需要进一步验证用户规模和付费意愿。现阶段,市场上已有部分类似方案,且LlamaIndex、LangChain等开源生态中也包含辅助提示词设计的模块。能否在竞争中脱颖而出,技术易用性和产品体验是关键。

总结来说,OpenRouter通过创新的提示词A/B测试机制,为LLM应用开发者带来了崭新的思路与工具选择。这种工具降低了提示词调整的试错成本,帮助用户基于真实数据优化交互体验,有望推动AI产品的精准化提升。未来如果能构建完善的用户体系和商业模式,并丰富功能生态,将更具市场竞争力。对于关注大语言模型优化的开发者而言,这个方向值得密切关注,也可能成为行业走向标准化提示词管理的先驱之一。在AI应用日益广泛的时代,如何科学提升模型输出质量是核心命题。像OpenRouter这样结合数据驱动思维和工程实现的工具,有望为这一课题提供实用而有效的解决方案,推动人工智能从技术层面走向更成熟的产品应用阶段。

。