人工智能技术的快速发展正在深刻改变诸多行业的运作模式,尤其是在医疗、法律、工程等专业领域。与此同时,围绕着人工智能技术的责任归属问题成为学界和产业界热议的话题。美国参议员辛西娅·卢米斯(Cynthia Lummis)近期提出的“负责任创新和安全专业知识法案”(Responsible Innovation and Safe Expertise Act,简称RISE法案)试图为AI的民事责任提供新的立法框架。然而,尽管该法案被视为“及时且必要”的举措,其内容却因细节缺失和责任划分不均而受到质疑。卢米斯的RISE法案被看作是美国针对专业级人工智能责任改革的开创性尝试,主要目的是通过赋予AI开发者一定的法律豁免权,防止他们因不可预见的模型行为被无休止诉讼。同时,法案强调要求AI开发者对其模型技术参数进行公开披露,帮助医生、律师、工程师等专业人士在依赖AI工具时更清楚地了解其能力和局限。

尽管如此,许多观察者指出,法案过于偏向于AI开发商的利益,将大部分风险责任转嫁给使用这些技术的“专业人士”。专家哈米德·埃克比亚(Hamid Ekbia)指出,法案仅要求开发商公开技术规格,如模型卡和说明书,但在实际责任承担方面给予了宽泛的豁免权。这种做法可能导致缺乏足够的透明度和监管,使公众和最终用户难以了解潜在风险。批评声音还包括来自左翼政治团体,他们认为该法案实际上是向AI企业“送福利”,使其免于因工具失误承担法律责任。然而,律师费利克斯·希普凯维奇(Felix Shipkevich)则持不同观点,他认为RISE法案中对开发者的豁免是合理且必要的举措。因为大型语言模型及类似AI系统的输出结果具有高度不可预测性,开发者实际上难以完全控制其行为,若没有法律保护,其可能面临无限的诉讼风险。

法案主要针对专业人士在客户或病人服务过程中使用AI的场景。例如,金融顾问利用AI协助投资策略制定,放射科医生使用AI辅助X光片解读等。然而,对于没有专业中介介入的AI使用场景,法案则缺乏明确规定。举例而言,近日佛罗里达发生的未成年人因长期与AI聊天机器人互动而导致自杀的案例,揭示了法律责任划分的复杂性。对于这样的悲剧,责任应该如何认定,目前RISE法案并未提供答案。法律学者瑞安·阿博特(Ryan Abbott)指出,AI技术的复杂性、黑箱特性及自动化水平,带来了前所未有的潜在危害。

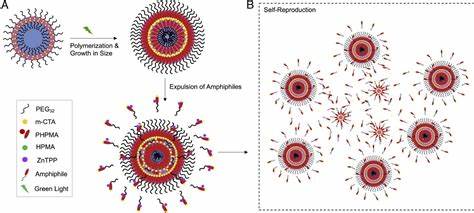

尤其在医疗领域,诊断错误的责任归属问题尤为棘手。虽然过往数据表明医生整体诊断优于AI,但新研究显示,在某些情境下,人为介入反而可能导致较差的表现。这就引发了关于在何种条件下、由谁承担错误风险的争论。保险覆盖面是否足以涵盖AI相关风险,也是业界关注的焦点。非营利研究机构AI Futures Project曾参与法案起草过程,给予了初步认可,但仍担忧现有透明度要求不够充分。他们认为公众有权了解AI系统背后的目标、价值观、偏见和程序指令,而这些内容在法案中未被强制公开。

此外,企业仍可选择承担责任来规避透明义务,潜在地规避公众监督。相较于美国,欧盟在人工智能责任方面采取了“权利本位”的立场。虽然欧盟2025年初撤回了起草中的AI责任指令,但该区域整体倾向于赋予终端用户和受影响群体更多权利保障,并强调开发者必须展示其符合法规安全与透明标准。美国采取的“风险管理”为核心的RISE法案策略,更多聚焦于技术流程、文档化审核及偏见检测,而非直接赋予个体用户更多具体权利。专家认为美国若能将风险导向与权利保障相结合,将更有助于解决AI技术带来的伦理和法律难题。尽管存在多方面质疑,法律专家认为RISE法案作为起点具备积极意义。

费利克斯表示,只要法案未来强化透明度及风险管理义务,平衡各方权益,其将为美国AI监管奠定坚实基础。政策侧的声音也认可法案提出的联邦透明指引、安全港机制及专业用户责任规范,为后续完善提供方向。与此同时,批评者提醒,若仅停留于发布模型卡,而缺乏第三方审计与全面风险评估,透明度可能沦为空洞概念,难以真正保障公共安全。假如法案成功通过,将于2025年12月1日生效,届时美国专业级AI的责任与监管环境将迎来新变革。总体来看,卢米斯的RISE法案是在人工智能民事责任领域迈出的重要一步,面对技术复杂性和快速迭代,法案在平衡创新与风险管控方面存在挑战。如何细化条文内容,统一安全透明标准,兼顾AI开发者与使用者权益,将成为未来立法讨论的核心议题。

人工智能作为改变社会未来的重要力量,其发展必须建立在合理的法律基础之上。美国RISE法案虽非完美,却为这一进程提供了起点。各界期待这一立法能够不断演进,最终实现既鼓励创新,又确保公共利益保护的理想目标。